L'IA, la musique, mes clones et Sora

Au sommaire cette semaine, des news comme s’il en pleuvait, des nouvelles de SORA, et je vous présente un nouvel outil pour générer automatiquement vos clips vidéos en IA.

”Innovation never stops” devrait être le slogan actuel de l’IA générative…

C’est parti !

✔️ Les news de la semaine

✔️ Sora Returns… et on en sait un peu plus sur son fonctionnement

✔️ Noisee, l’IA qui crée des clips vidéos en quelques clics !

Les news de la semaine

Recherche Française en IA

Le gouvernement français lance un programme de recherche en intelligence artificielle de 73 millions d'euros. Piloté par le CEA, le CNRS et Inria, et opéré par l'ANR, ce projet vise à avancer la recherche dans le domaine de l'IA pour répondre à des problématiques clés de souveraineté. Il se concentre sur trois grandes thématiques : l'IA frugale et embarquée, l'IA de confiance et distribuée, et les fondements mathématiques de l'IA. Ce programme ambitionne aussi de renforcer la souveraineté française dans ce secteur.

Un clip généré avec Stable Diffusion

Le dernier clip du duo de rappeurs BigFlo et Oli a été généré avec Stable Diffusion.

49225 images générées au total, pour un clip orchestré par le réalisateur NEB, qui a confié à Numerama avoir passé plus d’une centaine d’heures à travailler sur le projet.

« À aucun moment ce ne sont les paroles qui sont promptées. Mon travail, c’est d’imaginer ce qui représenterait les paroles en image. C’est un vrai travail d’imagination et d’écriture. » explique t-il.

Recourir à l’IA est un choix qui apparait pertinent ici, au vu du thème de ce titre, que je vous laisse découvrir :

Auto-Hacker-GPT

Des chercheurs ont révélé que des IA comme GPT-4 peuvent effectuer des piratages web autonomes, soulevant des inquiétudes sur leur potentiel de menace. Les IA ont réussi des attaques complexes sans connaissance préalable des vulnérabilités. GPT-4 s'est distingué, réussissant à pirater une majorité des sites testés. Cette efficacité suggère un risque d'exploitation par des cybercriminels, appelant à une vigilance accrue et une réévaluation des politiques de diffusion des modèles IA.

Google, toujours en embuscade

Google a développé Vlogger, une IA capable de générer des vidéos d'individus parlant à partir d'une seule photo et d'un échantillon vocal. L’outil utilise les réseaux neuronaux pour simuler de manière réaliste les mouvements du corps et des mains ainsi que les expressions faciales.

Vous avez dit “Deepfakes” ?

Machine Unlearning

Face à l'usage controversé de contenus protégés par le droit d'auteur dans les IA génératives, des chercheurs de l'Université du Texas à Austin proposent une solution novatrice : le "désapprentissage automatique". Cette approche permet d'effacer sélectivement des données problématiques des modèles d'IA, sans nécessiter une réinitialisation complète. Principalement axée sur les modèles d'image à image, elle vise à assurer le respect du droit d'auteur et à prévenir les violations, répondant ainsi à des préoccupations croissantes, illustrées par des litiges comme celui du New York Times contre OpenAI.

NVIDIA encore et toujours

La technologie LATTE3D de Nvidia présente des avancées significatives dans la génération de modèles 3D à partir de textes. Cette IA permet de créer rapidement des modèles 3D texturés, ouvrant des horizons nouveaux pour le peuplement de mondes virtuels, la publicité, ou la conception.

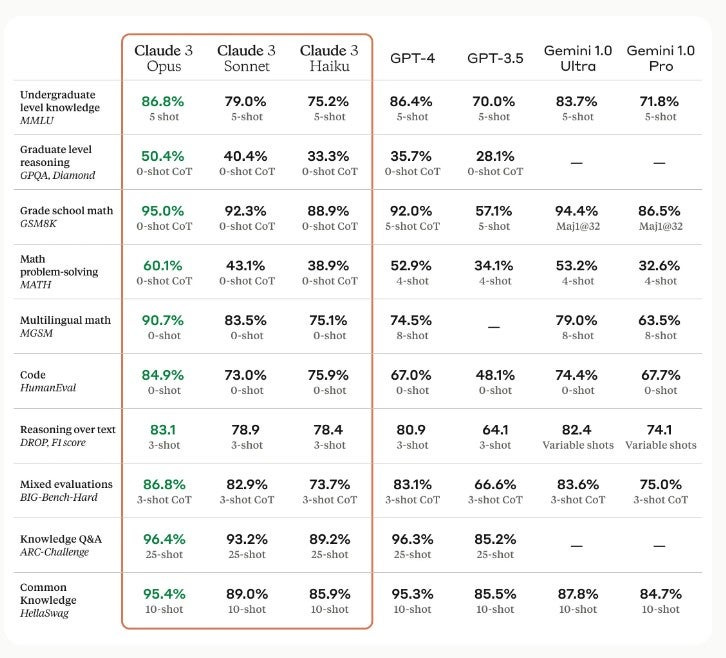

Claude 3 devant chatGPT ?

Depuis quelques semaines, j’avoue développer une préférence pour les générations textuelles de Claude 3 Opus par rapport à celles de chatGPT-4. Et bien saviez vous que Claude 3 vient de dépasser le GPT-4 d'OpenAI pour la première fois dans le classement de LMSYS Chatbot Arena ? De quoi mettre la pression sur OpenAI qui a déjà annoncé un successeur majeur à GPT-4, potentiellement GPT-4.5 ou GPT-5, cette année.

Pour une (grosse) poignée de dollars

Et puisque l’on parle de Claude, de la société Anthropic, Amazon vient d'annoncer un investissement supplémentaire de 2,75 milliards de dollars dans Anthropic, s'ajoutant à son investissement initial de 1,25 milliard, ce qui constitue le plus grand investissement externe de l'histoire du géant technologique.

Avec cet accord, Anthropic utilisera AWS comme fournisseur de cloud principal et bénéficiera des puces IA personnalisées d'Amazon. Cela porte le financement total d'Anthropic à environ 7,3 milliards de dollars, valorisant l'entreprise à 18,4 milliards de dollars. Tout ça commence à faire beaucoup de dollars si vous voulez un avis à forte valeur.

Sans les mains

La news SF de la semaine, c’est cet homme qui a joué à Mario Kart par la pensée, grâce à un implant cérébral de Neuralink. Cette avancée offre des perspectives d'autonomie pour les personnes à mobilité réduite et représente un changement de paradigme. L’histoire ne dit pas si l’homme a remporté toutes les coupes en or en 150cc.

Street Fighter LLM

Puisqu’on parle retro gaming, regardez ce qu’on réalisé des participants du dernier Hackaton Mistral AI : ils ont organisé des combats de LLM à Street Fighter 3.

Comment ont ils fait ?

1️⃣ Ils font tourner un émulateur avec Street Fighter 3

2️⃣ Ils lisent l’état du jeu et le traduisent en langage naturel

3️⃣ Le LLM choisit en temps réel ce qu’il faut faire ensuite

4️⃣ Ils exécutent la commande

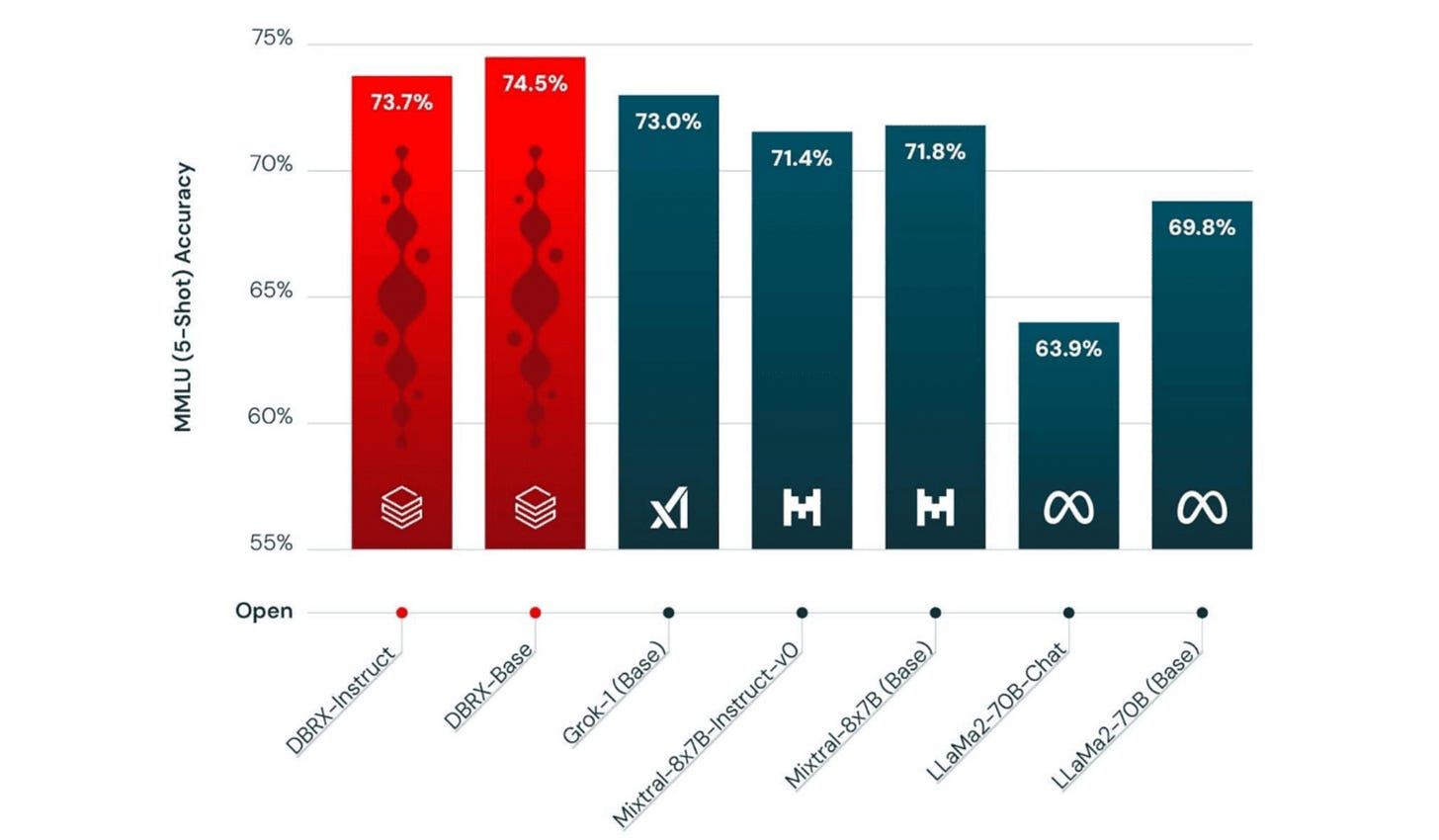

New Kid on the Block

Databricks a dévoilé DBRX, un nouveau modèle de langage open source qui surpasse des modèles majeurs tels que Mixtral MoE, Llama-2 70B, et Grok-1 en compréhension de langage, programmation et mathématiques. Plus rapide et 40% plus petit que ses concurrents, DBRX se distingue également sur les tâches de long contexte. Créé en seulement deux mois avec un budget de 10 millions de dollars, il établit un nouveau standard industriel, bien que Meta prépare déjà Llama 3.

Je reprendrais bien une coupe de Champ

Champ est une nouvelle technique pour animer une image 3D à partir d'une vidéo, en capturant fidèlement la géométrie et le mouvement. Elle intègre des données avancées telles que des cartes de profondeur et des guidages de mouvement, et utilise un processus d'auto-attention pour les fusionner avec précision. Cette méthode promet une animation d'une grande précision, ouvrant de nouvelles possibilités dans le domaine de l'animation 3D.

A combien sera le Bitcoin la semaine prochaine ?

la startup iFi AI, fondée par Ron Insana, ambitionne de révolutionner le trading individuel grâce à l'IA d'IBM Watson, en analysant de vastes données pour des projections de rendement d'actions sur diverses périodes. Gérant déjà 6 milliards de dollars institutionnellement, iFi AI propose différents services aux traders, transformant les stratégies d'investissement actuelles et illustrent l'intégration croissante de l'IA dans la finance.

En temps réel

Krea.ai lance le “real time image prompting”. On prompte, krea créée une image qu’on peut modifier en temps réel, en utilisant une image de référence “mergée” avec la génération. Parce qu’une vidéo vaut bien 90 mots, regardez pour vous faire une idée :

SORA returns

Sora, la plateforme IA de génération de vidéo la plus attendue du siècle, a fait parler d’elle récemment. Son éditeur OpenAI a donné un accès à quelques artistes triées sur le volet, qui ont réalisé des court-métrages avec la plateforme. Parmi eux, un film m’a fortement impressionné, tant par son originalité que par sa forme :

Sur X (Twitter), je suis tombé sur le “making of” de ce court métrage. On y apprend que Sora est un peu comme une “slot machine” (une machine à sous, dans le sens où on ne sait jamais ce qui va en sortir). A la manière des générations aléatoires de Runway Gen-2, l’équipe de Shy Kids a dû itérer encore et encore, et a même dû passer par des effets spéciaux visuels pour obtenir exactement le résultat escompté.

On pourrait d’ores et déjà en déduire que Sora ne sera probablement pas ce magicien capable de réaliser précisément n’importe quelle vidéo d’un coup de baguette magique. L’utiliser de manière productive nécessitera des compétences en découpage, en montage, en étalonnage et en effets spéciaux visuels.

L’analyse des Shy Kids : “Travailler avec Sora ouvre définitivement de nouvelles possibilités, comme celles de travailler avec des équipes réduites dans une configuration de cinéma indépendant, sans pour autant sacrifier les ambitions créatives.

J’y vois personnellement beaucoup de similitudes avec l’émergence des camescopes mini DV au début des années 2000. L’industrie voyait d’un mauvais oeil les petits vidéastes du dimanche qui sortaient de chez eux pour réaliser leurs courts-métrages en équipes ultra réduites sans rien demander à personne. Sora proposera t-il peu ou prou la même liberté, avec encore moins de monde dans l’équipe et sans avoir à sortir de chez soi ?

NOISEE AI

Et si je vous disais qu’il est désormais possible de créer des clips musicaux juste avec un prompt ? Vous me répondriez probablement “Ah, avec l’IA, tout est possible !”

Et vous auriez raison.

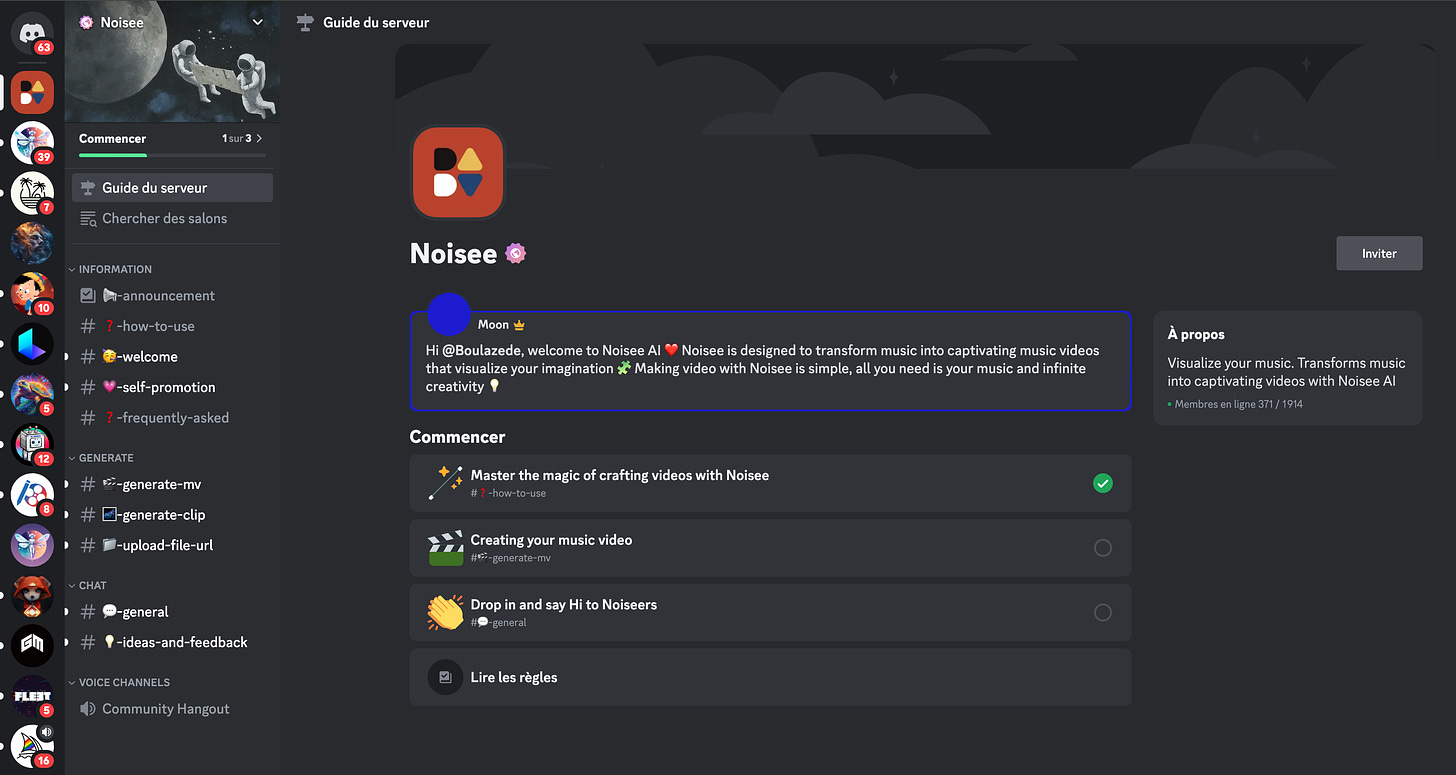

Laissez moi vous présenter Noisee.

Noisee est un prompt to video d’un type particulier : il permet de générer des vidéos d’une durée de 30 secondes (ou + si affinités).

Accessible via Discord, son fonctionnement rappelle celui de Midjourney.

1️⃣ Vous Tapez “/imagine” dans un chan, vous saisissez l'URL de la musique de votre choix et vous envoyez la commande. Noisee prend en charge les liens YouTube, Soundcloud, Suno (Yeaaahhh) et le téléchargement direct de fichiers MP3.

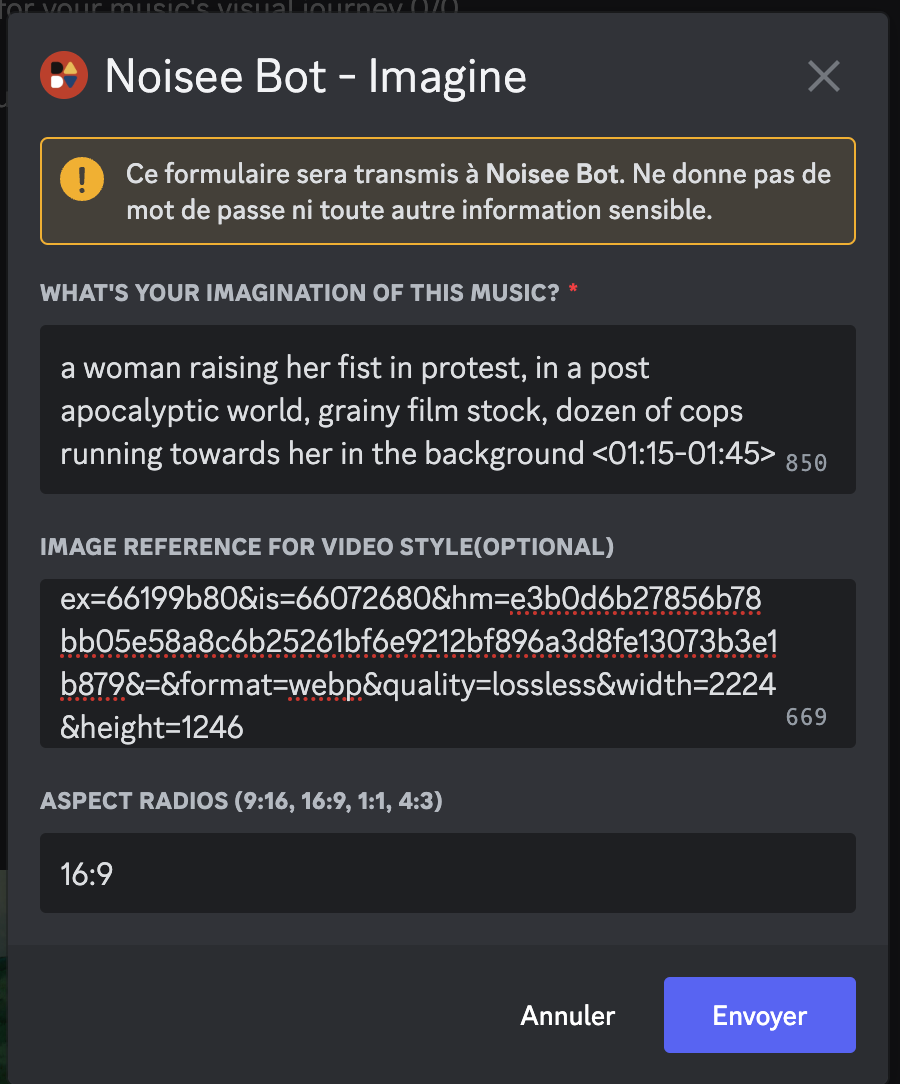

2️⃣ Après avoir envoyé la commande, une fenêtre pop-up apparaît. Entrez votre prompt et si vous souhaitez spécifier un segment dans la musique, entrez le paramètre de temps. Par exemple : <01:00-01:30>. La durée maximale est de 30 secondes par vidéo.

💡 Optionnel : Pour une meilleure cohérence de style, vous pouvez entrer une URL d'image Discord comme image de référence. Ainsi la vidéo correspondra au style de l'image. Intéressant.

3️⃣ Appuyez sur “Submit” et le bot de Noisee générera la vidéo en quelques minutes.

Alors bien sûr, j’ai testé l’outil et je vais vous partager mon processus pas à pas.

1️⃣ J’ai commencé par une reprise d’un titre d’une de mes playlists énervées favorites, “Wake Up” de Rage Against The Machine. J’ai donc récupéré les paroles sur Google.

2️⃣ J’ai copié collé les paroles dans Suno, mon outil de génération musicale préféré (Spoiler Alert : on a même enregistré un épisode de podcast sur Suno pas plus tard que cet après midi avec Laura Ghazal). Et je me suis dit quitte à twister RATM , autant le faire vraiment. J’ai choisi un style “atmospheric electropop” aux antipodes du morceau d’origine.

Evidemment, Suno m’a encore gratifié d’un tour de magie dont il a le secret, avec un morceau à la qualité sidérante pour un truc généré en 1mn et quelques clics.

Ecoutez (J’aime bien le passage à partir de 1mn20).

3️⃣ Le style visuel. J’avais en tête la pochette de l’album “The Battle of Los Angeles”, 3e album du groupe, sorti en 1999. La même année que “Matrix”, dont le titre “Wake Up” illustre la dernière séquence du film.

Je voulais tester un style coloré pour le clip. J’ai tout de suite pensé à la photographie de Roger Deakins dans Blade Runner 2049 :

Hop ! Direction Midjourney.

Prompt : “cinematic shot of a woman raising her fist in protest, in a post apocalyptic world --ar 16:9 --s 200 --sref https://s.mj.run/aUdsxoZVk84 --v 6.0’

La palette colorimétrique est moins riche que celle de Roger, mais comme on dit, “ça va faire le job”. Après quelques ajustements de prompts, j’obtenais cette image, que j’ai conservé pour l’expérience :

4️⃣ Dans le Discord de Noisee, j’ai renseigné un prompt, une image de référence (l’image ci-dessus) et un ratio d’image et le time code du passage musical le plus intéressant à mon goût. Et j’ai cliqué sur “Envoyer”.

Et après plusieurs minutes de génération, voici ce que j’ai obtenu :

Qu’est-ce que vous en pensez ?

De mon côté je suis partagé. D’un côté, on a aucun contrôle sur la réalisation, le découpage et le montage. Et on observe quelques déformations anatomiques dans les mouvements des personnages.

Et d’un autre côté, je trouve absolument sidérant de générer 7 plans et 30 secondes de vidéo, uniquement à partir d’un prompt et d’une image de référence.

C’est dingue.

Et c’est d’autant plus dingue que ce modèle est en v1. Je suis à la fois curieux et impatient de voir ses évolutions futures.

N’hésitez pas à aller jeter un oeil à cette app étonnante qui est sortie récemment. Il n’y a encore que 1000 utilisateurs.

Noisee est gratuit, mais limité à 3 générations toutes les 3 heures. Réfléchissez bien avant de cliquer sur “Envoyer” !

Il existe également une fonctionnalité “Generate Clip”, que je qualifierais de “text-to-video” assez dispensable.

PRO-TIP : lorsque vous utilisez un lien Suno, vous pouvez générer 1mn de vidéo au lieu de 30 secondes avec un lien classique.

Cette édition est terminée, merci de l’avoir lue. Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇