Veo 2 is here ! Freepik a plié le game !

Salut tout le monde, bienvenue dans cette 98e édition de GENERATIVE, la newsletter qui flotte là où les autres coulent sous les torrents de news incessants de l’IA générative.

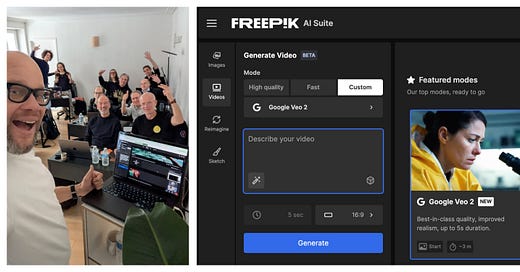

Le coup de tonnerre de la semaine, c’est l’arrivée de Google Veo 2 dans Freepik !

C’est Caro qui m’a donné la nouvelle vendredi matin, alors que j’étais en pleine formation Vidéo IA, avec une promotion d’indépendants, via le CPF.

2 journées extraordinaires Image + Vidéo avec les derniers outils du moment (on a prompté Veo 2 en direct live !) et des ateliers workshop !

Ne manquez pas les prochaines sessions fin mars, vous pouvez vous inscrire ici :

https://road-cream-7fa.notion.site/196826eb18dc80c49e64c3aad6449642

Sans plus attendre :

Si vous avez raté les infos des semaines dernières, la session rattrapage se passe ICI.

🔹 Google Veo 2 débarque dans Freepik !

On vous parle de Freepik presque chaque semaine depuis des mois. Ils n’en finissent plus d’intégrer des nouvelles fonctionnalités.

Ils viennent d’ailleurs d’ajouter la feature ultime : Veo2, le générateur vidéo le plus incroyable du monde, indisponible en Europe jusqu’à ce vendredi.

Le nombre de modèles disponibles dans Freepik monte désormais à 16(!), disponibles dans le cadre d’un abonnement unique. Ainsi, vous pouvez utiliser au même endroit MiniMax, Pika 2.0, Runway Gen 3, Luma Ray2, Hunyuan v2 Pro, PixVerse 3.5 et notre petit chouchou Kling 1.6 Pro (en + des modèles de génération d’images Flux, Mystic, et Imagen 3)

Veo 2 est actuellement uniquement disponible en text-to-video (img-to-vid à venir).

Les générations sont limitées à 5 secondes et à 720p pour l’instant (4K à venir).

Voilà pour les bonnes nouvelles.

Pour les moins bonnes nouvelles, le prix est exorbitant.

Chaque génération coûte 1000 crédits. C’est 8 fois(!) plus cher qu’avec Kling standard et 3 fois plus cher qu’avec Kling 1.6 Pro. Ainsi, l’abonnement annuel Premium + à 270€ ne permettrait de générer que… 500 clips Veo 2.

Et certains avanceraient même que la version déployée sur Freepik ne serait pas le “vrai" VEO2 (la version des premiers teasers, en accès ultra restreint) mais la version “quantized” récemment intégrée à YouTube Shorts.

Quoi qu’il en soit, les générations via Freepik ont quand même de la gueule, regardez :

Last minute : si vous utilisez Poe (une plateforme qui regroupe plusieurs IA générative), sachez que Poe propose également un accès à Veo 2 ! (Un abonnement payant est requis)

🔹 Animate Anyone 2 : le full-body swap sans 3D d'Alibaba

Animate Anyone 2 de Alibaba permet de remplacer une personne par une autre dans une vidéo, à partir d’une simple photo. Contrairement aux méthodes basées sur la 3D comme avec Wonder Dynamics, celle-ci fonctionne directement en 2D avec un rendu qui nous rappelle un peu Viggle sur les démos disponibles (aucun code n’a encore été partagé pour l’instant.)

La fonctionnalité parfaite pour moi qui, toute ma vie depuis l’âge de 15 ans, rêve de traverser la raquette d’un terrain NBA pour aller écraser un gros dunk bien sale sur la tête d’un random de 2m10.

🔹 Step-Video-T2V : le modèle open-source vidéo de StepFun

Step-Video-T2V est un modèle open-source de génération vidéo à partir de texte, “qui combine une architecture neuronale de grande envergure avec des techniques de compression innovantes”, blablala… ça a l’air pas mal quoi.

Gourmand en ressources (Minimum 4x NVIDIA A100/A800 GPUs (80GB VRAM)) et s’il est dispo via une web app chinoise, et bien que Gilles ait développé un certain talent à dompter les prompts en chinois, ce sera peut-être plus simple avec le lien Github ici.

🔹 SkyReels vs Veo2 : match serré en génération vidéo

Développé par SkyworkAI, SkyReels V1 affine Hunyuan Video en enrichissant le dataset de 10 millions de clips. Il revendique 33 expressions faciales et 400 mouvements naturels ultra-réalistes. Optimisé multi-GPU, il est également dispo sur GitHub, Hugging Face et en app mobile testable via Fal.ai.

Et vous avez deux générations gratuites par jour sur la webapp, qui propose également un mode storyboard similaire à celui de Sora, ainsi qu’un mode “AI Drama” qui propose d’uploader un texte pour en générer un script, puis des personnages, puis des vignettes vidéo, comme dans Animatix, LTX Studio ou The Next Stories.

Un 1er test comparatif met SkyReels face à Veo2. Résultat ? La différence est subtile. Les deux modèles offrent des rendus étonnament proches. Votre avis ?

🔹 On n’arrête plus les chinois

Après Hunyuan et Step, On aura bientôt un nouveau modèle chinois de génération de vidéo open-source : WANX d’Alibaba.

On vous en dit plus très bien. Merci à Neb Sh pour cette info.

🔹 Les LoRas video sur base 3D de ComfyUI, Hunyuan & SkyReels

Une pipeline ComfyUI a été développée avec les modèles vidéo Hunyuan et Skyreels, en partenariat avec une plateforme collaborative réunissant les artistes de Kartel.ai. Ce workflow permet de capturer un personnage en 3D, puis d’entraîner un modèle LoRA vidéo sur cette base, pour garantir une cohérence visuelle entre les différents plans. Le résultat relayé par Lovis Odin nous a bluffés… et vous ?

🔹 Le nouveau style “Flares & Glares” de Krea

SlurpTV dévoile "Flares & Glares", un nouveau style sur Krea ai. Avec Gilles, on a voulu vous faire une proposition maison de notre meilleur cru de test. Cheers !

Version Krea Version Generative

🔹 ReferDINO & text-to-video-segmentation

ReferDINO permet de segmenter les éléments d’une video, uniquement à partir d’un prompt, sans sélection manuelle préalable. Il comprend les formes, les couleurs et les positions, ce qui permet de suivre les objets sans erreurs grâce à des masques précis et à un décodeur plus rapide et plus fiable que les précédents modèles. C’est sympa l’open source, mais encore une fois, le code est indisponible pour l’instant.

🔹 Pull to Extend de Rubbrband

La fonctionnalité “extend” arrive chez Rubbrband qui propose de générer la suite de votre video avec une manipulation aussi simple qu’en post prod : il vous suffit de cliquer et maintenir la touche shift, d’étirer la durée du clip et de prompter ce que vous recherchez pour prolonger la scène en question.

Adobe propose la même fonctionnalité dans Premiere Pro, que nous n’avons pas encore testée.

🔹 The Next Stories intègre Flux & MJ

Les français de The Next Stories ajoutent la génération d’images à leur plateforme, avec Midjourney et Flux intégrés directement. L’objectif : simplifier la création en centralisant les meilleurs outils d’IA. Gestion d’assets, interface intuitive et prise en charge multilingue sont au programme. D’autres modèles et la génération de vidéo, voix et musique suivront bientôt. A suivre…

🔹 L’app Pika, dispo sur iOS avec un nouvel effet

Pika lance son application officielle sur iOS : les générations de vidéo, effets et partage sont directement sur disponible sur mobile via l’App Store.

Sinon, leur dernier effet en date s’appelle PikaSwap et permet de remplacer des objets, des éléments ou des scènes dans une vidéo en téléchargeant une image (ou en sélectionnant par brush) puis en décrivant ce que vous voulez remplacer. La démo a donné tellement envie à Caro, qu’elle a tenté un swap d’avatar à l’édito de GENERATIVE (le lipsync n’est visiblement pas prévu, du coup son avatar tire un peu la tronche).

Au fait : la chaîne YouTube est Live les gens !

🔹 RigAnything : rigging 3D instantané avec l’IA

RigAnything génère un squelette animé en quelques secondes, sans template ni ajustements. Compatible avec n’importe quel modèle 3D, il automatise tout, rendant le workflow plus rapide et efficace. Un game changer pour l’animation 3D ?

🔹 BMW réinventé par l’IA : du classique au futur électrique

neur0fy présente cette vidéo de review des modèles iconiques de la Bayerische Motoren Werke, grâce à l’IA. Très sympa.

🔹 Combo Blender & IA

Ce workflow combine le viewport de Blender, une image et la fonctionnalité Pikaddition de Pika pour intégrer des personnages sans modélisation. Pas encore dispo en plug-in aujourd’hui, l’IA pourrait rapidement être directement intégrée pour animer automatiquement dans des outils 3D comme Blender, Trip, Rodin ou Vizcom.

🔹 Veo2 : test Text-2-Video

László Gaál dont on vous parlait récemment, teste ici 2 modèles en Text-to-video :

• Veo2 en ajoutant progressivement des objets dans une vidéo 100 % générée à partir de texte. L’IA gère étonnamment bien la cohérence visuelle malgré la complexité de certaines scènes.

🔹 MiniMax Director débarque sur Freepik

Après Krea ai la semaine dernière, MiniMax Director dont on parlait ici arrive chez Freepik avec son apport de contrôle accru sur les mouvements de caméra en génération vidéo : on entre un prompt, choisit son effet de caméra et on obtient “un peu + ce qu’on veut”. Et c’est déjà beaucoup.

🔹 Hunyuan de Tencent : génération vidéo IA en local

Autre test sur le modèle Hunyuan de Tencent montre qu’il est possible de générer des vidéos IA localement sur un GPU grand public de moins de 5 ans. Une avancée qui rapproche la création vidéo de l’open source. Ici, l’expérimentation inclut un LoRA custom pour simuler un grain 16mm, et un format 4:3 inspiré du film Ida (2013).

Bravo (encore une fois) à László Gaál pour cette très belle vidéo :

🔹 Storyblocker V2 : l’IA pour la production virtuelle

Storyblocker facilite la création de scènes 3D en temps réel avec text-to-3D, video-to-video, des caméras virtuelles et de la capture de mouvement. On peut ici composer, styliser et animer sans outils complexes depuis le storyboarding jusqu’à la prévisualisation. Merci à Warren Grange et Maxime Favero pour le relai. Pour vous faire une idée, c’est sur storyblocker.

🔹 TikTok voyage dans le temps avec l’IA ⏳

Le compte Time Traveller POV utilise l’IA pour créer des vidéos immersives qui plongent les spectateurs dans différentes époques. Résultat : 419K abonnés, 7,1M de "likes" et des millions de vues. Merci à Benjamin Benoliel pour ce partage !

🔹 Mon dernier film pour le Prompt Club

Pour ma participation à la session “CHAOS” du Prompt Club, je voulais un grand écart facial utopie-dystopie, soutenu par un décalage entre la voix off et les images (dans la 2nde partie), créant une distance ironique.

Pour cette voix off clé, je me suis inspirée de celle d’Alan Watts pour la générer avec Eleven Labs. Les vidéos ont toutes été faites en text-to-video, à 70% avec Sora (avec lequel je me suis réconcilié ces 2 dernières semaines), 25% avec Veo 2. Il y a également 2 plans Firefly video, quelques plans Hailuo AI ainsi qu’un unique plan image-to-video animé avec Kling.

La musique est générée avec Riffusion et les bruitages avec ElevenLabs et mmaudio.

🔹 Le clip expérimental Uncanny Harry avec Veo2

Le clip non officiel de Ryan Phillips a.k.a. Uncanny Harry, sur "YOUR NEW MORNING ALARM" de Marc Rebillet (musicien et performer franco-américain connu pour ses improvisations musicales électro-funk, son humour décalé et ses performances en live, souvent en peignoir). Au final, une vidéo dynamique aussi percutante qu’un café colombien serré avec un Redbull.

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇