Summer Break

Salut les juilletistes et la Aoûtiens, bienvenue dans cette nouvelle édition de GENERATIVE, la newsletter consacrée à l’actualité des outils créatifs d’intelligence artificielle générative.

A l’heure où vous lirez ces lignes, je coulerai des vacances méritées (de mon point de vue) dans les régions du Tamil Nadu et du Kerala, dans le sud de l’Inde. Cette édition est donc la dernière avant l’édition de la rentrée, fin août.

Evidemment, si jamais OpenAI sort Sora ou chatGPT-5 le 1e août, si Runway ajoute le image-to-video à Gen-3 au milieu de l’été, si la v7 de Midjourney débarque sans prévenir alors là oui, je ferai une édition spéciale !

Sans plus attendre, voici le sommaire :

Les (très nombreuses) news de la semaine

Et toi tu fais quoi avec l’IA ? L’interview de l’artiste IA Matthieu Grambert

Les news de la semaine

Paul, Hok and the clouds

On démarre avec cette belle vidéo du talentueux réalisateur californien Paul Trillo, à qui l’on doit déjà le fameux clip e plan séquence réalisé avec Sora. Il revient avec ce teaser d’une vidéo plus longue à venir.

Brisant le mythe du one-man-crew qui prompte en caleçon tout seul la nuit dans sa chambre, Paul a dévoilé la liste technique du film :

Hok (choreographer / co-director / dancer) hokuto konishi

Erica Klein (dancer)

Brad Tucker (Lead hashtag#ComfyUI Animator) Brad T.

Dave Lynch (ComfyUI animator)

Bill Dorais (ComfyUI animator) Bill Dorais

Souki Mansoor (DP) Souki Mansoor

Cal Laird (editor) Cal Laird

Additional animation support:

Nathan Shipley Danny Kamhaji

Il fallait probablement tout ce beau monde pour accoucher de ce petit bijou dont les animations font étalgae d’une étonnante précision.

Mini is the new Large

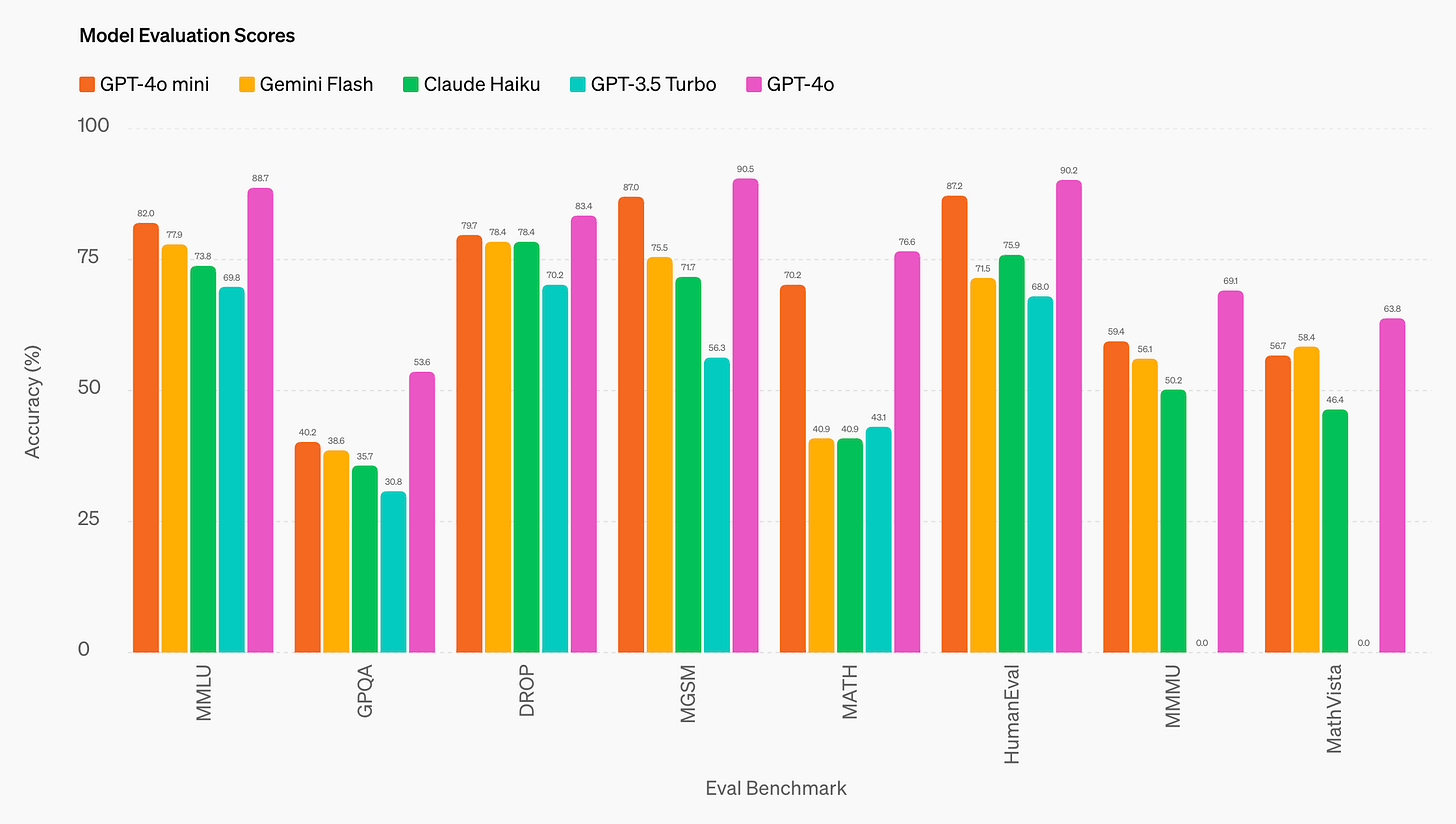

OpenAI vient de lancer son nouveau modèle, GPT-4o mini, qui surpasse les petits modèles comme Gemini Flash et Claude Haiku en matière de raisonnement, de mathématiques et de codage. Avec une fenêtre de contexte de 128 000 tokens et une prise en charge de 16 000 tokens de sortie par requête, GPT-4o mini est optimisé pour les applications complexes telles que les chatbots de support client et l'extraction de données. Il intègre également des fonctionnalités de sécurité avancées, notamment une résistance aux jailbreaks et aux injections de prompts, garantissant une utilisation fiable et sécurisée dans diverses applications.

Google vids

Google Vids, un nouvel outil de création vidéo alimenté par l'IA, fait son apparition dans Google Workspace. Il permet aux utilisateurs de créer des vidéos à partir de simples prompts et de modèles et de médias préexistants. L'outil offre des fonctionnalités de personnalisation comme l'ajout de médias, l'enregistrement de voix off et le réglage de la durée des scènes. Actuellement disponible pour un nombre limité d'utilisateurs de Workspace Labs, Google Vids est en cours de déploiement progressif.

Prompte moi ce que tu veux écouter

YouTube Music lance de nouvelles fonctionnalités d'IA, notamment la recherche par son et une radio conversationnelle basée sur l'IA. La recherche par son permet aux utilisateurs de trouver une chanson en la fredonnant ou en la jouant. La radio conversationnelle, en test aux États-Unis, génère des playlists personnalisées à partir de descriptions textuelles. Je serais bien curieux de tester, et vous ?

D’abord on vole, ensuite on légifère (ou pas)

Selon la bonne vieille habitude qui consiste à entrainer des modèles d’IA générative sur “tout ce qu’on trouve sur le net”, Amazon, Google, Meta et X auraient secrètement utilisé des vidéos YouTube pour entraîner leurs modèles d'IA sans le consentement explicite des créateurs. De quoi donner de la matière aux prochains procès intentés contre les géants de la tech.

Haiper 1.5

Le générateur de vidéo Haiper sort sa version 1.5, accessible gratuitement. On peut y générer des vidéos de 8 secondes à partir de texte ou d'images, faire du style transfer et de l’upscaling jusqu'à 1080p. Les keyframes seront bientôt disponibles. Bien que l'interface soit intuitive, il est regrettable que cette nouvelle version sorte après Luma AI, Gen-3 et Kling, qui lui sont supérieurs.

Sur mes tests ci-dessous issus d’images Midjourney, on voit un aliasing bizarre sur la peau du personnage (il faut dire que la compression est très forte avec des fichiers vidéo dont le poids est inférieur à 1Mo)

Et un manque de cohérence spatiale sur ce clip :

Bref, je l’ai déjà rebaptisé “Le Luma Dream Machine du pauvre”.

Adobe toujours sur le front de l’IA

Firefly propose en bêta un nouvel outil Illustrator appelé Mockup.

Il utilise l’IA pour scanner les images et trouver les bordures. Ensuite, vous pouvez faire glisser vos images vectorielles sur l’objet et obtenir de très bonnes maquettes de produits.

Ainsi, il devient possible d’utiliser Midjourney pour créer des maquettes de produits « uniques » avec des possibilités infinies pour l’avenir des maquettes de produits dérivés/produits.

Lipsync everywhere

L’application DomoAI a mis a jour son lipsync. Le youtuber Pierrick Chevalier a fait une courte vidéo pour tester la fonctionnalité. Ça semble fonctionner pas mal, mais globalement, j’avoue avoir du mal à voir autre chose que des “filtres after effects” dans ce type d’app “video-to-video”

Will AI kill Hollywood ?

Le CEO de Runway, Cristobal Valenzuela et Jake Aust, le Chief Innovation Officer de Runway ont récemment répondu à une interview pour Fortune Magazine sur le sujet :

”Will AI kill Hollywood ?”

Voici les points clés abordés dans l’interview :

Évolution technologique à Hollywood : L'IA, comme les technologies précédentes (son, couleur, CGI), est perçue comme un outil qui apportera des changements mais ne mettra pas fin à Hollywood. L'industrie s'est historiquement adaptée aux nouvelles technologies.Intégration des artistes et de la technologie : Les intervenants soulignent que Hollywood est dirigé par des artistes et une touche humaine. Les outils d'IA devraient compléter plutôt que remplacer la créativité humaine.

Préoccupations et opposition : Les acteurs et les scénaristes s'inquiètent de l'impact de l'IA, notamment en ce qui concerne les ressemblances numériques et la sécurité de l'emploi. Les intervenants soutiennent que les outils d'IA doivent être d’abord expérimentés pour comprendre leur potentiel et leurs limites.

IA générative dans la production : Les outils d'IA sont utilisés pour visualiser des idées créatives dès le début de la production, aidant ainsi les cinéastes indépendants et les grands studios. Ces outils aident aux étapes de présentation et de développement en fournissant une représentation visuelle des concepts.

Perspective éducative : La discussion souligne l'importance d'enseigner l'adaptabilité et l'adoption de nouveaux outils dans les écoles d'art. Les futurs artistes devraient voir l'IA comme un nouveau moyen de créativité plutôt qu'un remplacement des méthodes traditionnelles.

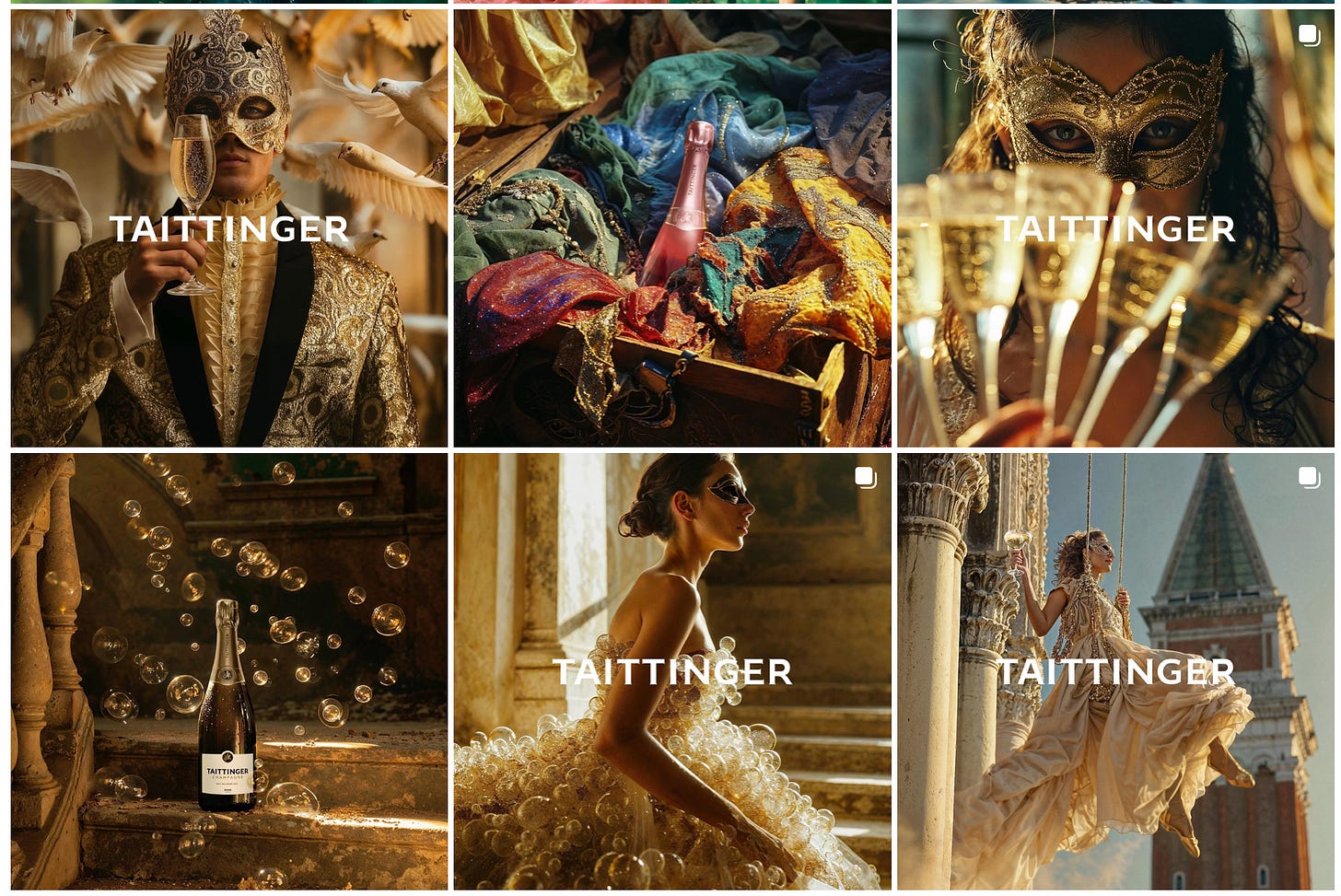

Dans “Taittinger” il y a AI

La DA et A.I. Artist Floriane Bont a signé la dernière campagne IA de Taittinger, sous l’égide de l’agence IA Detroits Talents.

La guerre au deepfakes est déclarée

Pindrop, une entreprise spécialisée dans la détection des deepfakes, a obtenu un prêt de 100 millions de dollars pour développer ses solutions de sécurité. Ces fonds permettront d'améliorer et d'étendre leur technologie, essentielle pour lutter contre la prolifération des contenus vidéo et audio manipulés qui peuvent causer d'importants préjudices.

Microsoft Designer

Microsoft élargit l'accès à son application Designer propulsée par l'IA, maintenant disponible sur iOS et Android. Conçue pour rivaliser avec Canva, cette application intègre des fonctionnalités d'intelligence artificielle pour faciliter la création de designs graphiques, notamment pour les réseaux sociaux, les présentations et autres usages professionnels, sans nécessiter de compétences en graphisme.

Luma is still here

Alors que tous les yeux sont braqués sur Gen-3, certains créateurs nous rappellent qu’il ne faut pas encore enterrer Luma Labs Dream Machine :

Et puisqu’on parle de Luma, une vidéo a attiré mon attention cette semaine. Les effets de ralentis sont assez incroyables.

Après avoir réfléchi au workflow utilisé pour réaliser cet effet, j’ai retrouvé sur le net le récit le méthode utilisée par l’auteur de la vidéo :

"Tout d'abord, j'ai recherché en ligne toutes les photos disponibles du combat et j'ai cherché des moments où les photos étaient prises sous différents angles au même instant. Il est rare que deux photos soient prises exactement au même moment, mais si elles sont suffisamment proches, cela fonctionne. On peut améliorer une photo avec Photoshop : par exemple, si dans une photo le bras est plus proche du visage que dans l'autre, je peux utiliser Photoshop pour "corriger" cela, c'est-à-dire rapprocher ou éloigner le bras afin d'avoir "la même photo" sous différents angles.

J'ai également utilisé Photoshop pour bien centrer les combattants, utilisant le "remplissage génératif" pour compléter le cadre si nécessaire, et éliminer toute distraction qui pourrait interférer avec la génération.

Par exemple, dans certaines générations, il y avait un arbitre en arrière-plan, et LUMA se concentrait sur l'arbitre, ce qui donnait de mauvaises générations.En supprimant l'arbitre, le problème était résolu. La même chose peut se produire avec le public ou d'autres éléments que LUMA pourrait essayer d'animer (nous ne voulons pas cela; nous voulons qu'il se concentre uniquement sur les combattants).

Certaines vidéos ont été réalisées avec une seule image et d'autres avec deux images en utilisant l'option End Frame (0:08, 0:16, et 0:24, par exemple). Je crois que ce sont les segments les plus percutants.

J'ai remarqué que LUMA fonctionne très bien pour les prises de vue BULLET TIME, tant pour les prompts avec une seule image que pour les prompts avec deux images (END FRAME).

Prompts avec une seule image : J'ai fait divers tests, et certains prompts qui ont donné de bons résultats étaient : "sculpture en cire de combattants, prise de vue à 360 degrés" "combattants en sculpture immobile, prise de vue bullet time"

-> prompts indiquant que le combattant est immobile : "sculpture en cire", "statue de cire" -> prompts pour le mouvement de la caméra : "prise de vue à 360 degrés", "prise de vue bullet time"

Prompts avec deux images (END FRAME) : La même chose que le cas 1, mais cela a fonctionné dans certains cas même sans indiquer le mouvement de la caméra (LUMA a reconnu par lui-même qu'il devait faire un ARC SHOT pour finir à l'image de fin).

Même avec les prompts corrects qui ont donné de bonnes générations, j'ai essayé en moyenne 3 ou 4 fois pour obtenir une bonne prise. Dans de rares cas, j'ai obtenu une bonne génération du premier coup.

"prise de vue à 360 degrés" semblait mieux fonctionner que "arc shot" ou quelque chose de similaire. Je pense que le premier est plus exagéré, et même si l'arc shot n'est que de 90 degrés, par exemple, 360 degrés a plus d'impact dans le prompt (ou c'est peut-être juste mon biais).

Sora toujours là

Des vidéos de Sora continuent d’être publiées chaque semaine, évitant que notre impatience collective ne se transforme définitivement en désillusion

Kling Kling Boum

Le générateur de vidéo chinois Kling continue lui aussi à faire parler de lui avec plusieurs vidéos notables cette semaine.

DOCU IA

Un court-métrage documentaire entièrement réalisé avec Kling met en lumière le muqam, musique traditionnelle d'Asie centrale. Ce film se distingue par sa qualité narrative et technique, avec une attention particulière portée à la musique et aux détails visuels. La consistance des gestes des mains du musicien et le maintien des traits du personnage principal sont assez remarquables.

Merci à Elisabeth Gravil pour cette découverte… et pour le sous titrage en français.

Me, Myself and I

L’une des vidéos virales de la semaine, c’est celle-ci, réalisée avec Kling. Anachronie, voyage temporel, je est un autre, naturel des personnages, apprêtez vous à entrer de plain-pied dans la vallée de l’étrange :

Il y a même eu une version bis, pour ceux qui préfèrent le foot au cinéma :

Kling est en train de s’imposer comme le meilleur image-to-video du marché. Et ce n’est pas Mona Lisa qui dira le contraire.

Et Gen-3 ?

Runway est toujours dans la place, j’en veux pour preuve cette petite boutique des horreurs métamorphosées de fort belle facture. Je sens qu’avec davantage de contrôle sur les outputs, l’IA va grandement accélérer de nombreux process VFX.

Dubitt

L’app française de traduction multilingue Lipitt a testé sa technologie sur un extrait du dernier Pixar. Pensez vous que ce type de démonstration annonce la fin du doublage au cinéma ?

Spec Dior AI

Savez vous ce que signifie “Spec commercial” (ou “Spec Ad”) ? En français on dit “fausse pub”. Il s’agit d’une publicité non sollicitée par une marque, qu’un réalisateur entreprend de son propre chef pour construire sa bande démo. Ce n’est pas nouveau, cela existe depuis la démocratisation du matériel de prise de vue il y a un peu plus de 20 ans. Et logiquement, le phénomène s’amplifie avec les récentes avancées de la vidéo IA. Le problème fréquent avec les specs ads (et je le sais d’expérience), c’est que les wanabee Directors passent souvent à côté des ingrédients d’une bonne pub (script efficace, découpage au rasoir, message impactant, le tout pas trop long et en cohérence avec l’ADN de marque). La dernière AI Spec AD que j’ai vue passer est pour Dior. Qu’en pensez-vous ?

AI VLOG

Parfois je m’interroge:

- Qu’est-ce qui est le plus bizarre ? Les vidéos IA ou les gens qui font des vidéos IA ?

- Suis-je déjà trop vieux pour comprendre ?

Voilà à peu près ce qui m’a traversé l’esprit lorsque je suis tombé sur ce “Vlog IA”, dans lequel un personnage généré “parle” face caméra pour raconter un Tokyo qui n’existe pas tel qu’il est présenté.

Le script a été écrit par Google Gemini Advanced. Les clips générés avec Runway Gen-3. La consistence du visage a été faite au montage, après les générations (avec Facefusion ?)

Le lipsync a été réalisé avec le LipSync feature de Runway. Les voix ont été faites elles aussi avec Runway (dommage que le créateur n’ait pas utilisé ElevenLabs pour de meilleurs résultats). Et la musique générée par Suno.

Question de boomer : Y a t-il un public pour ça” ?

Video Face Swap

RenderNet AI a lancé la semaine dernière VideofaceSwap, un outil permettant d'échanger les visages dans des vidéos. Cette technologie pourrait révolutionner la création de contenu vidéo, notamment sur TikTok, en permettant l'insertion de visages d'influenceurs dans des vidéos générées par l'IA. Mais son potentiel ne s'arrête pas là, elle pourrait également assurer une cohérence visuelle des personnages dans les vidéos générées par l'IA. Voici une vidéo avec des exemples issus des vidéos de Ludovic Carli, interviewé récemment par ici.

Le monde de Nemo

Mistral AI et NVIDIA ont lancé Mistral NeMo 12B, un LLM destiné aux entreprises. Ce modèle excelle dans les conversations, les mathématiques, le raisonnement, la connaissance du monde et le codage, et se distingue par une fenêtre contextuele de 128 000 tokens, permettant de traiter des informations complexes de manière plus cohérente. Il est conçu pour fonctionner sur une seule carte graphique NVIDIA, offrant une haute efficacité et un faible coût de calcul. Les entreprises peuvent facilement intégrer Mistral NeMo dans leurs applications commerciales grâce à sa licence ouverte.

Mistral AI précise que le modèle est conçu pour des applications multilingue. Il excelle particulièrement en anglais, français, allemand, espagnol, italien, portugais, chinois, japonais, coréen, arabe et hindi.

AI Mocap

Le savais tu ? L’IA s’apprête à révolutionner la motion capture, cette technologie qui consiste à enregistrer les mouvements d’un comédien pour les dupliquer sur un personnage 3D. C’est cette technologie qui a permis d’animer Gollum, King Kong (pas la version 1933 hein !), les Na’vi d’Avatar, etc…

La société Move AI annoncé une nouvelle techno qui permet la capture en temps réel, et sans combinaison truffée de capteurs.

Deepfake era

Et pour finir, la question à 1000 roupies (je suis en Inde, tu te souviens ?) :

Cette vidéo virale qui a dépassé les 10 millions de vues a t-elle été générée ?

Sommes nous déjà entrés dans une ère où certaines générations sont impossibles à distinguer de la réalité ?

Et toi, tu fais quoi avec l’IA ?

Cette semaine, j’interviewe l’artiste IA Matthieu Grambert.

Salut Matthieu, peux-tu te présenter ?

Je suis Matthieu j’habite à Paris et je suis freelance dans le domaine créatif. J’utilise les intelligences artificielles depuis 2 ans.

Comment as-tu découvert les outils d'intelligence artificielle générative ?

J’ai découvert les outils d’IA après un long burn out / dépression après avoir quitté mon entreprise, et j’ai tout de suite plongé dedans en aout 2022, j’ai trouvé ça « game changer » dès le début et il m’a pas fallu beaucoup de temps pour comprendre où ça allait aller dans les autres domaines que l’image.

Comment ces outils d'IA ont il fait évoluer ton processus créatif et tes workflows ?

Il n’y a pas réellement eu de workflow / de processus artistique vu que je n’étais pas sur un métier créatif avant, mais j’avais la volonté de me diriger vers ça. Donc ça m’est juste tombé dessus au bon moment et j’ai exploré pendant des centaines d’heures en format image comme vidéo. Étant quelqu’un plus dans les idées et les concepts, c’était parfait pour moi.

Comment s'est passée la transition vers la vidéo IA ?

J’ai démarré la vidéo IA dès le début, je savais que ça finirai par se stabiliser et qu’une personne seule finirait par équivaloir un studio créatif puis un studio hollywoodien. Je m’attendais juste pas à une progression aussi rapide, j’attendais plus ces outils autour de 2028-2030.

Aujourd'hui, quels sont les outils d'IA que tu utilises le plus ?

Midjourney.

Où puises-tu ton inspiration ?

Mon inspiration est un mix de fashion et de cinéma je pense. Je viens de l’écriture, donc je suis assez drivé par ce que je vis et/ou les émotions / les histoires.

Aussi parfois je me laisse juste porter par l’IA et ses capacités. J’aime l’abstraction mais je suis trop control freak pour m’y laisser aller pleinement, j’ai besoin de sentir que c’est mon travail et que je dirige l’IA, sinon je sens que ce n’est pas moi qui a produit, d’où une certaine précision dans l’éditing / les plans etc.

C’est pour ça qu’au final j’épouse assez peu l’AI art pur qui consiste à faire des choses complètement random, et c’est aussi pour ça que je reste dans quelque chose de super réaliste (aussi car j’ai besoin de croire en ce que je vois pour qu’une émotion s’en dégage). Mais j’essaye toujours d’ajouter un peu de surréalisme, aussi par peur du backlash sur les métiers. Si trop réaliste = quelqu’un peut le faire en filmmaking traditionnel = gens pas contents.

Quel serait ton "dream project" ?

Pas vraiment de dream project, j’ai eu quelque projets avec des marques de luxe, c’est déjà très chouette. Peut-être éventuellement des clips pour des artistes que j’apprécie, ça pourrait être cool.

Selon toi, quels sont les avantages et les limites de l'utilisation de l'intelligence artificielle générative dans le domaine artistique ?

Il n’y a pas de limites pour moi à l’usage de l’IA dans le domaine artistique, si ce n’est la limite psychologique qui est celle de se sentir écrasé par l’infinité de possibilités. J’ai de plus en plus de mal à me lancer dans quelque chose de précis car les outils sont tous éparpillés pour le moment, en plus d’évoluer à une vitesse infernale. C’est un peu ébouriffant, et puis tout est de plus en plus worthless.

Si tout le monde est artiste il n’y a pas d’art. La rareté crée l’envie. D’où aussi le fait que je produise aussi peu, pour essayer de pas lasser. Bon et par flemmardise aussi souvent, car j’arrive sur un truc avec quelque chose de tellement précis en tête que je finis par me lancer dans quelque chose d’autre de plus simple qui me prendra moins de temps lorsqu’il y a une nouveauté qui sort.

Parce que sinon j’ai vite tendance à m’enfermer des jours / semaines durant car trop perfectionniste / control freak quand je suis vraiment lancé dans un projet sérieux, et j’ai de moins en moins le temps pour ça donc je préfère ne rien faire que faire mauvais.

Je trouve qu’on a une responsabilité à faire des choses quali et pas balancer de l’image à profusion, les réseaux sociaux n’ont pas vocation à servir de poubelle car ça prend de l’algorithme à des artistes traditionnels qui en ont besoin pour en vivre. Donc j’essaye d’être exigeant parce que je sais que ce que je poste a des implications derrière. Plus il me manque des compétences en animation traditionnelle et à chaque fois je dois apprendre ce dont j’ai besoin pour X ou X plan et ça prend un temps fou on top of that.

Selon toi, quels effets aura l'IA générative sur le futur de l'Art ?

J’ai du mal à entrevoir un avenir pour les artistes, pour moi les 2D arts dit passifs vont dégringoler au fur et à mesure pour laisser émerger des immersive arts en réalité virtuelle dans lequel on pourra évoluer.

Après, tout cohabitera peut-être aussi. Les arts traditionnels ne disparaitront pas, tout comme la peinture n’a pas disparu à l’arrivée de la photo. C’est un gros trou noir sur lequel il est difficile de se projeter, mais c’est un gros pavé, bien plus que l’arrivée de la photo. Cette fois tout va être impacté, image vidéo 3D. On va arriver à du world building, qui couplé à l’AR pourra être dingue. Mais qu’est-ce qu’on créera là-dedans quand l’AI peut générer une civilisation digitale entière ? Le futur est sans doute entertainment, mais avec toujours une part d’art possible.

Quelles sont les avancées que tu attends le plus pour le second semestre 2024 ?

Les avancées que j’attends le plus : controlnet sur Midjourney, davantage de contrôle pour la vidéo et l’arrivée des modèles 3D.

Cette édition est terminée, merci de l’avoir lue jusqu’ici !

Je vous souhaite un bel été et vous donne rdv à la rentrée.

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇

Merci et bonnes vacances !!

Bonnes vacances ! (Et merci pour cette riche édition :-) )