Sora est là (ou presque)

Salut les excités de l’innovation, les stakhanovistes de la news quotidienne, les spéculateurs technologiques, les futurs Spielberg du néo-digital, et bienvenue dans cette 88e édition de GENERATIVE, la newsletter qui pédale à ta place sous l’eau par temps de brouillard épais dans les marécages gluants de l’actualité explosive des outils créatifs d’intelligence artificielle générative.

Cette semaine est une édition particulière.

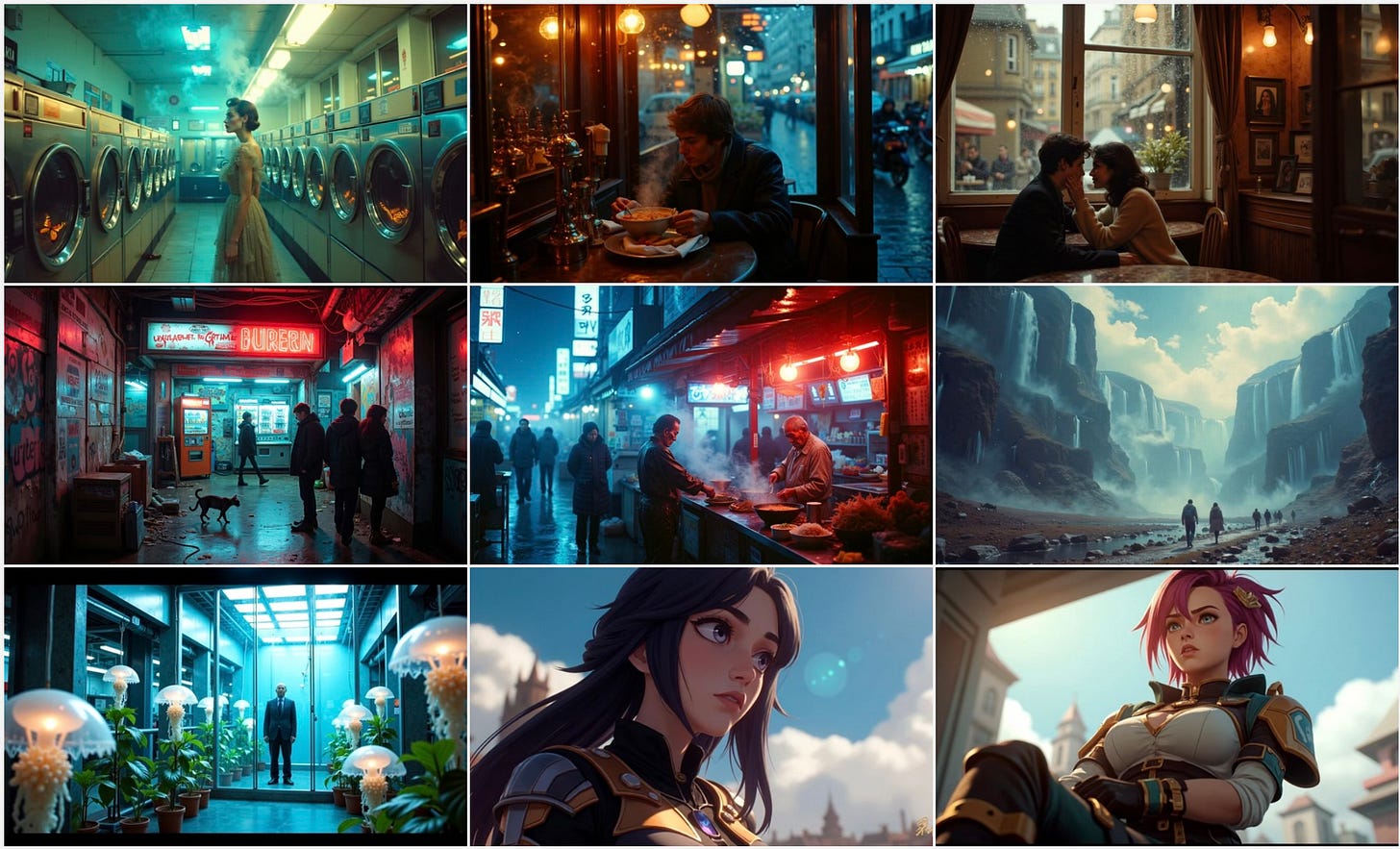

Sora est sorti. Si, si.

(Made with Sora)

On vous raconte tout en détails.

Mais sans plus attendre, le sommaire :

Les news de la semaine

Les vidéos de la semaine

Le méga dossier SORA

🔹 PIka 2.0

Pika Labs, ex-challenger de Runway, confirme son pivot vers les réseaux sociaux avec cette nouvelle version qui délaisse la course à la qualité visuelle (par rapport à la concurrence) au profit du fun, du MEME generating et du viral content.

Mes enfants vont adorer.

🔹J’en ai cauchemardé, Elon l’a fait

X a dévoilé Grok 2, un nouveau modèle de génération d’images dépourvu de toute censure. Un bon résumé serait : “n’importe qui peut désormais faire n’importe quoi”.

Alors que des milliers de personnes autour du globe militent et se mobilisent pour une “IA responsable”, Elon Musk invente l’IA irresponsable.

🔹 MiniMax et son upgrade discrète

La bataille des modèles génératifs vidéo s’intensifie pour 2025 ! MiniMax propose une interface améliorée, assez inspirée de celle de Runway Gen-3 (une visite video relayée par Brendt Petersen)

2 nouveaux modes : : Immersive (comprendre intense !) ou Quick Create pour des créations rapides.

Génération multi-vidéos en un clic : bien pratique pour gagner du temps

Sélection multiple et historique pour collecter, télécharger ou organiser son espace de travail en un clic

Génération de dialogues avec diversités des voix, langues et émotions

🔹 Le Son à la Carte avec MultiFoley d’Adobe

Adobe et l’Université du Michigan lancent MultiFoley, un outil générant des effets sonores à partir de prompt, d’échantillons audio ou de vidéos. Si la génération semble simple et la synchronisation correcte, la qualité, elle, paraît perfectible.

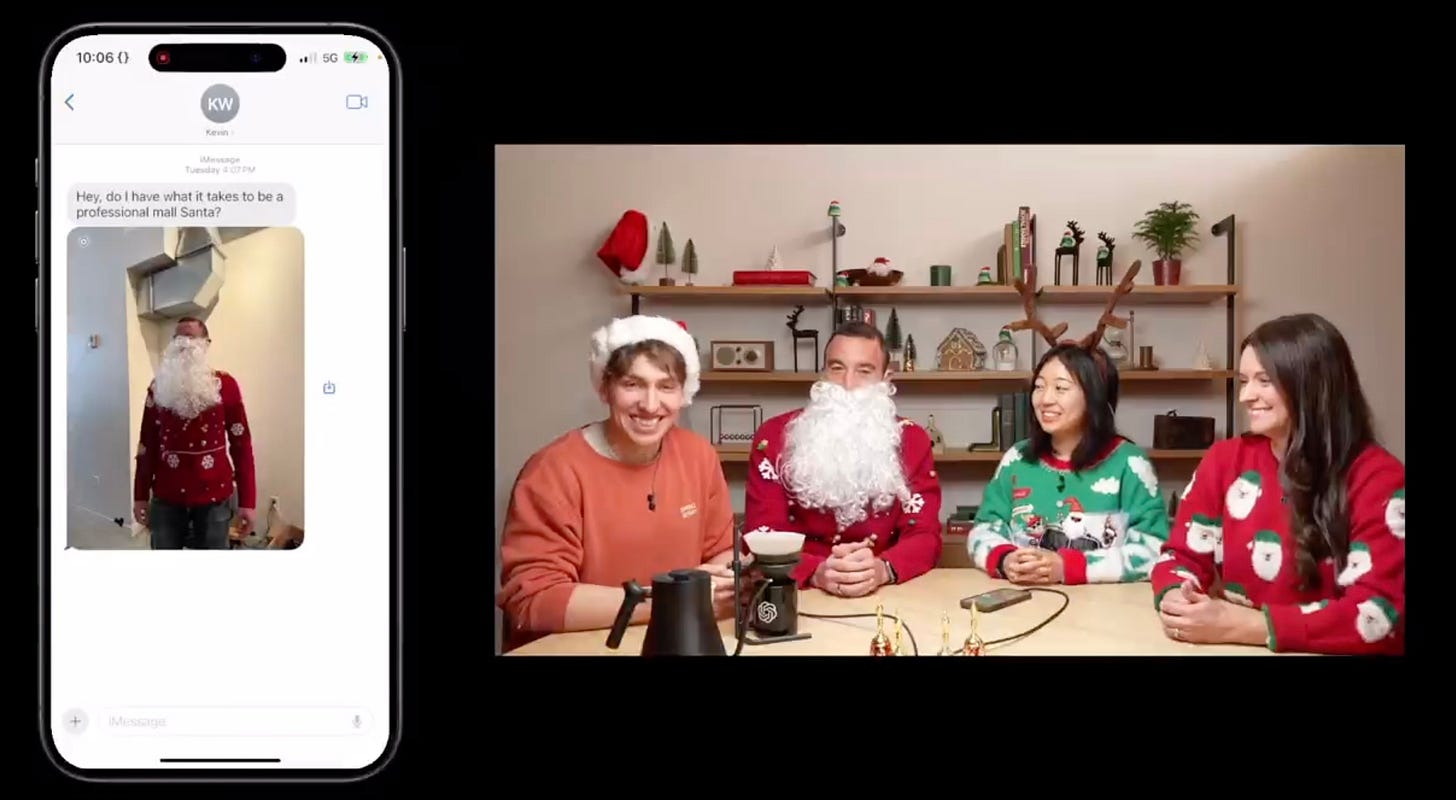

🔹 ChatGPT passe à la caméra

OpenAI franchit une étape avec l’intégration vidéo dans ChatGPT. Concrètement, chatGPT est maintenant capable de “voir” ce qui se passe sur l’écran de votre device ! Démonstrations marquantes : identification faciale, assistance vidéo ou rédaction avec images. Impressionnant.

🔹 Conversational AI, l’agent d’ElevenLabs

ElevenLabs lance Conversational AI, un agent vocal intelligent et personnalisable, intégrable via une ligne de code. Côté fonctionnalités, on retrouve les features classiques : config du nom, du rôle, voix pré-enregistrées ou personnalisées, paramétrages de la base de connaissances (textes, fichiers, web) mais également la possibilité d’utiliser son propre modèle LLM.

Côté usage, ElevenLabs propose un site interactif et permet de créer des personnages pour les films ou le gaming. Côté suivi, un historique, des résumés et des datas peuvent être extraites. Et ils ont même prévu une assistance client 24/7.

ElevenLabs fait un pas de plus vers une suite complète… A suivre !

🔹 Concours “ Voice Your Character” de ElevenLabs x Hedra

D’ailleurs, vous pouvez participer à ce concours pour tenter de remporter 4 000 $ en vous inscrivant ici : VoiceYourCharacter et en suivant les étapes suivantes :

Créer une voix unique avec ElevenLabs.

Animer un personnage parlant via Hedra.

Publier sur X avec #VoiceYourCharacter en tagguant Hedra & ElevenLabs.

🔹Viggle V3 en action

Vous rappelez vous de Viggle ? Il s’agit d’un outil IA assez doué pour l’animation. La V3 vient de sortir et améliore la qualité vidéo en réduisant le “scintillement” et en rendant les personnages plus nets. Cela permet des modifications ciblées, comme remplacer un fond ou appliquer des effets spécifiques, ce qui est notamment utile pour le montage et les effets spéciaux.

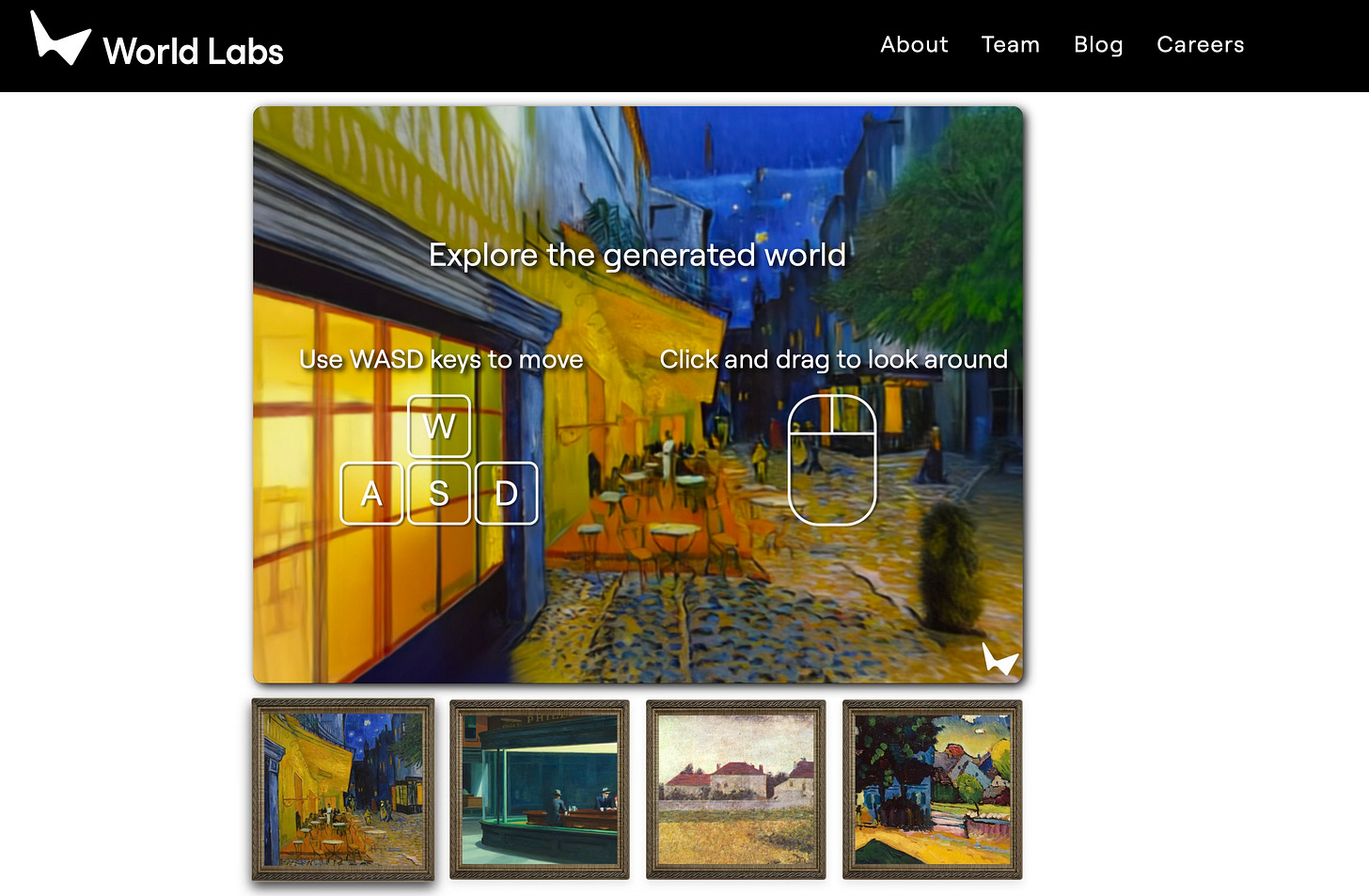

🔹 World Labs : Une image, un monde en 3

World Labs permet de convertir une image en un environnement 3D interactif. On peut naviguer avec une caméra en temps réel et appliquer des effets sans modifier la scène, dont ceux de netteté de focal, de zoom, de profondeur… Ce qui est plutôt utile pour les films, le gaming ou des simulateurs. Si les démos sur le site sont un peu brusques, l’immersion au coeur des peintures classiques est plutôt intéressantes.

🔹 Google Deepmind et le Motion Prompting

Google DeepMind introduit Motion Prompting, un outil de contrôle vidéo par tracés dessinés. Il s’agit pour l’utilisateur de définir les trajectoires qui guideront les mouvements d’objets et caméras (ce qui nous rappellent étrangement les motions brushs de Kling, car contrairement à ce que laisse supposer la vidéo, il ne s’agit pas de temps réel).

Dans la pratique, les animations paraissent fluides. A voir s’il est possible d’obtenir les résultats escomptés sans que cela ne demande trop de temps ni trop de technique.

🔹Letz.AI et son nouveau mode Sigma

On vous parlait de la V3 de Letz AI dans notre édition 75, voici son nouveau mode Sigma pour la génération d'images. Annoncé comme 2x plus rapide, 50 % moins cher, c’est surtout la qualité des rendus de peaux, les gros plans, le grain de film, et l'artistique qui sont plutôt bons. On note aussi un bon point pour des ratios flexibles (jusqu’à 3:8). Côté porte-monnaie, nous sommes à 9,99€ par mois pour 5000 crédits, soit ~500 images V3 Sigma images contre ~250 images de la V2…

Tenté(e)s ? c’est par ici : LetzAi

🔹La minute Open Source de la semaine

LTX, modèle vidéo open source connu pour sa rapidité mais critiqué sur la qualité, (et dont nous parlions dans cette édition-ci), évolue grâce au STG node (Spatiotemporal Skip Guidance). Ce nouveau mécanisme dont nous parle Luka Tisler améliore la qualité des vidéos générées par diffusion. Les résultats restent perfectibles mais marquent une avancée. L’innovation en open source continue de réhausser le niveau. Rattrapera t-il bientôt celui des leaders du marché ? A suivre !!

🔹 KREA et sa nouvelle fonctionnalité EDIT

Krea sort Editor qui permet plusieurs modalités intéressantes :

l’édition par calques pour revenir facilement à chaque étape, comme dans Adobe ou Procreate ;

l’inpainting & le blend ;

le contrôle d’objets pour les redimensionner sans perte de qualité.

🔹Trellis, le modèle 3D Pro

Trellis 3D est un modèle génératif 3D qui permet de créer des assets 3D de qualité à partir d’une simple image ou photo. Il se base sur 2 technologies avancées : l’une appelée “Structured Latent” qui simplifie les données complexes tout en préservant les relations clés entre 2 éléments, l’autre appelée “Rectified Flow Transformers” qui optimise l'apprentissage des modèles pour une meilleure évolution des données. Dans les faits, ça fonctionne incroyablement bien.

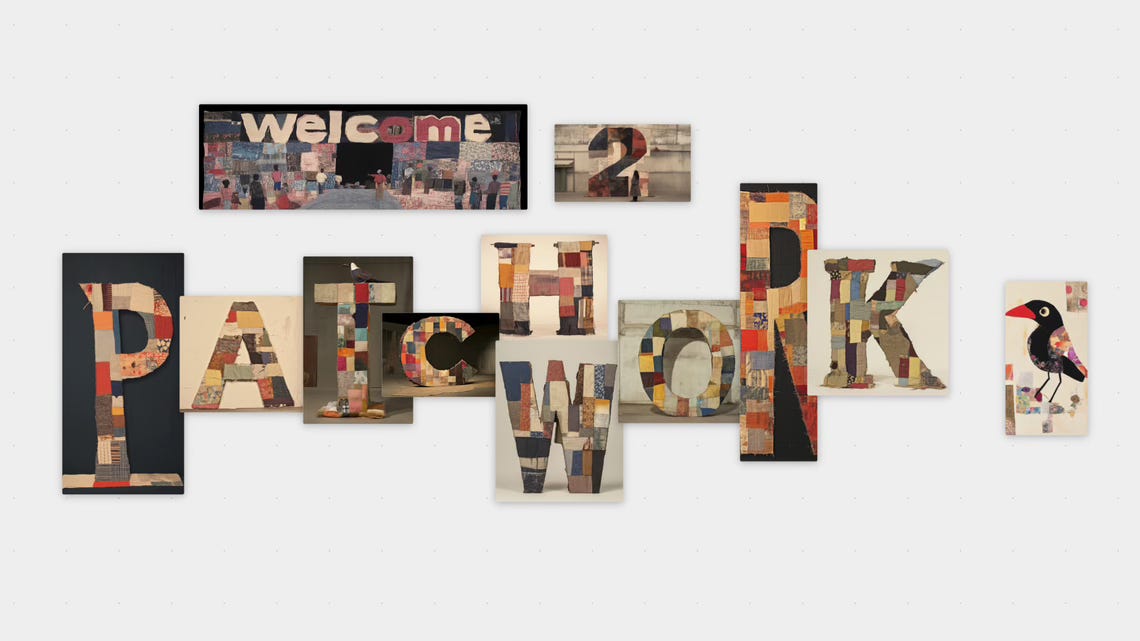

🔹Midjourney nous fait son patchwork

Patchwork est un nouvel outil collaboratif de Midjourney. Il permet :

Une navigation intuitive entre différents univers créatifs ;

La création de personnages, lieux, objets directement sur l’espace commun ;

Une organisation flexible des éléments pour structurer la toile ;

Une collaboration en temps réel avec d’autres utilisateurs sur le même espace créatif.

🔹Flow State : L’Usine à Idées de Leonardo

Leonardo lance Flow State, un outil de génération d’images continue et personnalisable aux multiples nouvelles fonctionnalités :

- Une génération plus rapide et surtout illimitée depuis un unique prompt ;

- Des styles ajustables et la fonction "More Like This" pour affiner les visuels générés.

Un outil premium qui permet une exploration visuelle intéressante pour booster la créativité. Seul bémol, les images sont à stocker manuellement dans les favoris (et oui c’est comme les antibiotiques, ce n’est pas automatique !)

🔹 Le contenu IA Coca-Cola de la semaine

Coca-Cola lance "Create Real Magic", une campagne IA où l'on échange avec un Père Noël inspiré de l’iconique "Sundblom Santa" (celui que vous voyez en miniature). Réalisé entre autres avec Accenture, OpenAI, Leonardo.AI et Universal Music, l’IA crée une boule à neige musicale et personnalisée, pleine de nostalgie mais pour des fêtes un peu plus interactives. Ho Ho Ho !

🔹Act-One v2 : Ainsi soit la vidéo

En fin de semaine dernière Runway a sorti une mise à jour d’Act-One qui permet désormais de dupliquer l’acting d’un comédien sur n’importe quelle vidéo.

Regardez :

🔹 Quand la Defender Rêve en IA"

Land Rover a lancé une pub hybride pour son Defender, combinant IA et tournage classique. Les scènes sans voiture ont été créées avec Runway et MidJourney. L’artiste IA Janos Deri a eu le privilège de collaborer avec l’excellent réalisateur Ben Tricklebank, en plus d’une tripotée d’artistes VFX.

Une belle démonstration d'efficacité mêlant workflow traditionnel et outils d’intelligence artificielle avec un 50/50 !

🔹 “FRACTURE” : mon dernier film IA

Une fois n’est pas coutume, un de mes films IA figure dans les pépites de la semaine. Il s’agit de ma contribution tardive à la première session du “Prompt Club”, ce collectif de réalisateurs IA que j’ai fondé au mois d’octobre dernier.

Je suis parti d’une idée que j’avais eue en 2018. J’ai généré des dizaines et des dizaines d’images et autant de clips vidéo, passé beaucoup de temps sur le montage et le son, et choisi une musique humaine plutôt qu’une musique IA. Voilà le résultat :

Sora est là

Depuis le 15 février 2024, date de sortie de LA vidéo de démo de Sora qui m’a fait littéralement tomber de ma chaise. A l’époque les Boss du AI video game s’appelaient Runway Gen-2 et Pika Labs, deux noms qui évoquent l’antiquité.

Avec ferveur, nous étions sur l’autre rive du Golfe d’Aqaba, attendant patiemment que la mer rouge s’ouvre en deux pour laisser passer l’élu. Ayant perdu la foi, d’aucuns avaient l’avaient rebaptisé “Arlésienne” et s’adonnaient à des jeux de mots répétés : “Qui vivra Sora”.

Alors que la lueur d’espoir vacillait, OpenAI a frappé tel la foudre lundi dernier à 19h heure de France. Dans une vidéo live, Sam Altman et son équipe annonçaient la sortie de Sora, en faisaient la démo en direct live sur YouTube et nous informaient qu’après 10 longs mois d’attente, L’OUTIL ÉTAIT DISPONIBLE SUR www.sora.com.

Une bonne nouvelle en appellant parfois une mauvaise, nous apprenions dans la foulée que Sora était disponible dans 60 pays, mais pas en Europe.

Dans la seconde suivante, votre serviteur double cliquait sur l’icône de son VPN préféré, se localisait aux Etats Unis (East Coast baby), se loggait à son compte OpenAI et… et… et ça ne fonctionnait toujours pas.

Ô rage, ô désespoir.

Avais-je donc passé toute l’année 2024 que pour vivre cette infamie ?

Sur le net, certaines rumeurs calmaient mes ardeurs. OpenAI avait annoncé qu’ils banniraient les comptes qui tenteraient de contourner les restrictions géographiques à l’aide d’un VPN.

Notre seule option étant de prendre notre mal en patience, nous avons écumé les internets avec Caroline Thireau, pour vous restituer la substantifique moëlle de TOUT ce qu’il faut savoir sur Sora.

Accrochez vos ceintures, c’est dense.

Tout ce qu’il faut savoir

Dispo dans 60 pays (hors Europe) sur www.sora.com

Accessible via un compte ChatGPT Plus/Pro

Le plan à 20$/mois donne droit à 50 générations/mois en 1280x720 pixels d’une durée maximale de 5 secondes.

Le plan à 200$/mois donne droit à 500 générations/mois en 1920x1080 pixels, jusqu’à 20 secondes, et disponible en formats grand écran, vertical et carré.

CAPACITÉS :

Texte-to-Vidéo

Image-to-Vidéo

Video-to-Video

Fonctionnalités Video-to-Video :

Remixage de Styles

Extension vers l'avant + vers l'arrière

Fusion

NOUVELLE INTERFACE CRÉATEUR :

Similaire à celles d'autres outils video AI

Ratios d'image : 16:9, 1:1, 9:16

Résolution : 480p, 720p, 1080p

Durée des vidéos : 5s, 10s, 15s, 20s

Préréglages : Divers styles de préréglages

STORYBOARD MODE :

Une fonctionnalité innovante qui vous donne la possibilité de décrire plusieurs actions à travers une séquence vidéo. C’est assez dingue :

SÉCURITÉ ET TRAÇABILITÉ

Toutes les vidéos incluent des métadonnées C2PA (Coalition for Content Provenance and Authenticity), garantissant leur origine.

Pour renforcer la transparence :

• Les vidéos incluent un filigrane visible par défaut, effaçable pour les utilisateurs de ChatGPT Pro.

• Un moteur de recherche interne permet d’identifier si une vidéo a été générée par Sora.

ACESSIBILITÉ

Sora est disponible globalement, sauf en Europe, Suisse et Royaume-Uni.

Cependant, il est possible d’y accéder via un VPN. (À vos risques et périls : OpenAI a annoncé tracker et menacer de ban les comptes qui enfreignent les restrictions géographiques à l’aide d’un VPN)

QUELQUES RÉFLEXIONS BASÉES SUR DES RETOURS UTILISATEURS

Sora n'est pas "facile"

Il nécessite une certaine réflexion conceptuelle

Le prompting est plus complexe que chez les concurrents

Il n’est pas parfait (encore quelques bugs)

Le modèle actuel est un modèle “Turbo” différent du modèle présenté en février

Ce n'est pas une “solution en un clic”

La qualité est très impressionnante

Certaines générations ne sont pas réalisables chez les concurrents

Test Image-to-Video par Rory Flynn

Un exemple en Text-to-video par Pierre Zandrowicz a.k.a Cinem.ai

Quelques exemples text-to-video par Tianyu Xu

Une comparaison entre Sora et Minimax par Jesus Castro. Minimax se défend pas mal du tout et Sora semble refuser de reproduire des visages de personnalités.

Un exemple de prompt à rallonge caractéristique de Sora, proposé par Dave Clark

”A cinematic close-up of a silverback gorilla’s face, its intense and intelligent eyes staring directly into the camera, capturing a sense of raw power and quiet wisdom. The texture of its fur is hyper-detailed, showing coarse, silver-tinged strands contrasted against the smooth, leathery texture of its nose and face. Scars and creases etched into its skin tell the story of its life in the wild, while faint droplets of water cling to its fur from the humid jungle air. The soft light filtering through the trees casts gentle highlights and shadows across its features, emphasizing the depth and contours of its powerful jawline and massive brow. In the background, hints of blurred green foliage provide a natural frame without detracting from the gorilla’s commanding presence. The mood is both intimate and majestic, captured with cinematic realism and shallow depth of field to isolate the gorilla’s expressive face in breathtaking detail.”

VIDEO-TO-VIDEO

La botte secrète de Sora, celle qui semblerait le placer nettement au dessus de la concurrence, est son mode video-to-video, uniquement accessible via l’abonnement pro à 200$ mensuels. Voici une démo réalisée par l’excellent Tim Simmons, de Theoretically Media :

La question que tout le monde se pose sur Internet c’est :

“cela vaut-il 200$ par mois ?”.

Il n’existe évidemment pas de réponse universelle à cette question. Les accros à l’open source diront que ce tarif est scandaleux, les hobbyistes trouveront ça très cher, les professionnels de l’audiovisuel diront que c’est très raisonnable au vu des performances.

Les vraies questions à se poser c’est :

1 - Qu’allez vous faire avec cet outil que vous ne pouviez pas faire avant ?

2 - Quand est-ce que ça sort en Europe Sacrebleu ?!

Pour clore ce dossier en beauté, on vous a fait un grand comparatif avec la quasi totalité des outils vidéo IA du marché. Let’s run !!

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇