Bonjour à toutes celles et ceux qui n'ont pas le temps où le goût pour la lecture prolongée de pavés disproportionnés, et bienvenue dans cette 82e édition de GENERATIVE !

J'ai beaucoup réfléchi ces derniers temps au format de cette Newsletter.

Depuis la première édition en avril 2023, j'ai fait le choix de tendre au maximum vers l'exhaustivité de l'information. Mais la récente accélération de l'actualité de l’IA générative questionne ce choix.

GENERATIVE est devenue très (trop ?) longue à lire, et plusieurs lecteurs m'ont signalé leur difficulté à la lire en intégralité.

C'est pourquoi nous essayons de vous proposer un format un peu plus compact. Au vu de l’actualité toujours aussi dense, je ne suis pas certain que nous y sommes parvenus avec cette édition. On continuera d’essayer dans la prochaine.

Merci à toutes celles et ceux qui prendront le temps de me donner leur avis en commentaire, sur cette direction.

C'est parti !

Sommaire :

🔹Les news essentielles de la semaine

🔹La vidéo de la semaine

🔹L’interview d’Ethan Safar, petit génie des GPTs

LES NEWS DE LA SEMAINE

🔹 RUNWAY ACT-ONE a.k.a. Fais ton film tout seul

Runway lance Act-One, un outil permettant de créer des animations expressives à partir de simples vidéos d’acteurs, sans avoir recours à des équipements complexes de “MoCap” (capture de mouvement).

Performances d’acteurs, capturées avec une simple caméra, pouvant être utilisées pour animer des personnages générés.

Act-One capte avec précision les micro-expressions et mouvements, et permet d’appliquer ces performances à des personnages générés, même avec des proportions différentes et en reproduisant fidèlement les intentions de jeu de l’acteur.

Performances d’acteurs & Animation de personnages générés.

Le modèle peut également être utilisé pour créer des scènes de dialogue impliquant plusieurs personnages joués par un seul acteur, ouvrant ainsi la voie à de nouvelles approches narratives. En plus de ces fonctionnalités, Act-One garantit des résultats cohérents dans différents angles de caméra. Inspiré de Live Portrait, cet outil sera progressivement accessible à l'ensemble des utilisateurs via la plateforme de Runway.

Scène de dialogue multi-caméras pouvant être créée à partir d'un seul acteur et d'une seule caméra.

L’avis de Gilles : j’avoue être très partagé. D’un côté, je trouve la tech spectaculaire. Et d’un autre, la perspective de cacher les acteurs derrière une surcouche d’IA m’angoisse. Plus besoin de makeup, de lumière, de décor, d’équipe technique. Il suffira d’un comédien filmé dans une cabine de doublage et l’IA s’occupera du reste.

Act One One dessine de manière très claire un futur anxiogène pour les professionnels de l’audiovisuel. A suivre…

🔹 Enfin du nouveau chez Midjourney !

Midjourney annonce le lancement d'un nouvel éditeur d'images externe offrant des fonctionnalités avancées de retouche et de retexturing. Les utilisateurs peuvent désormais télécharger, agrandir, recadrer et modifier leurs images via des commandes textuelles et une sélection par zones.

Pour assurer un déploiement progressif, ces nouvelles fonctionnalités sont initialement réservées aux utilisateurs ayant plus de 10k générations, ceux ayant un abonnement annuel et ceux ayant un abonnement mensuel depuis plus de 12 mois.

🔹 Ideogram Canvas : bonjour l’inpainting

Ideogram lance “Canvas”, une nouvelle fonctionnalité d’inpainting et d’outpainting de vos images, à la manière de ce que propose Photoshop. Bonus track : on peut uploader ses propres images. Il y a même un accès API pour les développeurs.

🔹 Eleven Labs Voice Design : just prompt it

ElevenLabs introduit Voice Design, une nouvelle fonctionnalité qui permet de générer des voix uniques à partir de simples prompts textuels. En quelques clics, il est désormais possible de créer des voix sur mesure, parfaitement adaptées aux personnages. Cette innovation offre une liberté créative inédite, dépassant l'utilisation de voix préexistantes. La vidéo de démo ci-dessous est signée Yigit Kirca :

🔹 Seelab V2 : une volonté de sur mesure pour les marques

La plateforme française Seelab lance sa V2. La proposition est de “simplifier la création de contenus alignés sur une identité visuelle”. Un système LoRA intégré permet de créer des modèles IA capables de reproduire personnages, produits ou styles. Egalement : interface améliorée, recherche historique, remplacement de fond, éditeur IA avancé, recadrage pour réseaux sociaux et upscaling d'images…

🔹 Stable Diffusion 3.5 : plus rapide, plus léger et…?

Après la déception Stable Diffusion 3, la version 3.5 essaye de corriger le tir. Plusieurs versions sont disponibles avec les modèles Large et Large Turbo (Vous pouvez les tester sur Hugging Face). Le modèle Medium suivra le 29 octobre. Que vau cette mise à jour par rapport à la concurrence qui a beaucoup progressé ?

On a testé pour vous et (spoiler) c’est pas mal du tout :

🔹 The Next Stories : une plateforme Tout-en-Un

La tendance actuelle est au all-in-one. Après krea.ai, ce sont les français de The Next Stories qui centralisent les meilleures IA génératives en une seule plateforme. Plus besoin de multiples abonnements coûteux : tout se trouve au même endroit. Lancement officiel le 1er novembre, avec accès prioritaire pour les inscrits ici : TheNextStories

🔹HAIPER 2.0 : peut mieux faire

”Haiper 2.0 est lancé avec des vidéos générées par l’IA plus qualitatives qu’avant. Grâce à un modèle Diffusion Transformer optimisé, il promet des vidéos dynamiques en haute résolution, des temps de génération réduits et une fluidité sans précédent.” Voilà pour le discours marketing. Dans la vraie vie, on a testé et…. c’est pas ouf.

🔹MOCHI 1 de GENMO : open source strikes back !

Genmo, pionnier de la video IA, revient avec Mochi 1, un modèle open-source de génération vidéo conçu pour offrir une bonne adhérence aux prompts. Accessible à tous, avec une limite de deux vidéos par jour, il permet de générer des vidéos en 480p, avec une version HD prévue d'ici la fin de l'année. Plus d’infos ici.

🔹ComfyUI se simplifie

ComfyUI, la plateforme de workflows sur mesure pour l'IA générative, va enfin devenir accessible à tous avec une version desktop prête à l'emploi. Fini les installations complexes : la version V1 apportera un support natif pour Windows, macOS (Apple Silicon) et Linux, avec une installation en un clic et un environnement Python préinstallé. Cela rendra l’outil plus accessible aux créatifs, notamment ceux sur Mac. (une info qui me met en joie!)

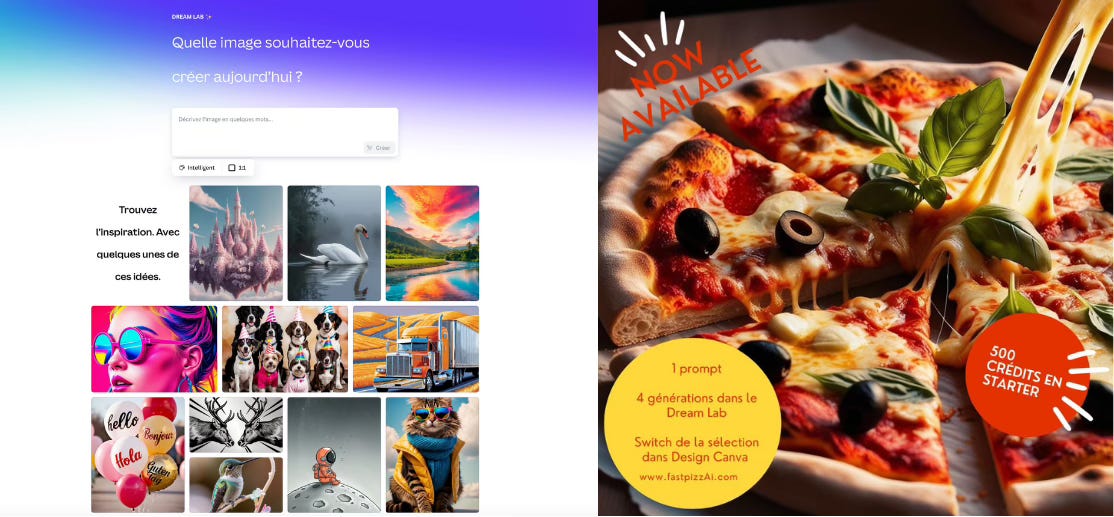

🔹CANVA x LEONARDO AI : la grande alliance

Canva intègre Leonardo.Ai via Dream Lab, offrant ses outils à 180 millions d'utilisateurs. Cette collaboration, lancée pendant "Droptober", allie les capacités créatives du premier à l'interface design du second.

L’avis de Karo : L'intégration de Leonardo.Ai dans Canva facilite la création par "click and drop", mais offre moins de contrôle sur les prompts et moins de fonctionnalités qu'un outil dédié.

🔹 SANA de NVIDIA : a new kid on the block

Non content de s’enrichir en vendant les pelles de la ruée vers l’or de l’IA générative, Nvidia s’invite à la fête de la génération d’images avec le modèle open-source SANA, co-développé avec le MIT et l'Université Tsinghua.

Ce modèle est capable de générer des images haute résolution (4096x4096) en quelques secondes à partir d'un prompt. Conçu pour être efficace et léger, il fonctionne même sur un GPU avec “seulement” 16 Go de RAM.

On a testé et… ça rappelle un peu le rendu de Google Imagen 2, un outil qui n’est pas resté dans les annales.

A tester ici : Sana de Nvidia

🔹TIMBALAND & SUNO : Big Love

Timbaland, producteur musical de renom partage son expérience avec Suno dans la série vidéo MUSE. Il explique comment la plateforme l'aide à retrouver la “pureté de la créativité” et sortira son nouveau single "Love Again" en avant-première sur Suno… De quoi relancer les débats sur les outils IA de génération musicale.

Last minute : Suno et Timbaland lancent un Concours de remix sur le nouveau titre "Love Again".

100 gagnants, sélectionnés par Timbaland, gagneront plus de 100 000 $ en prix en espèces, le gagnant de la 1ère place recevant 25 000 $.

Les 2 chansons gagnantes, également sélectionnées par Timbaland, verront leurs remix officiellement publiés aux côtés de l'original plus tard cette année.

Comment participer : Timbaland a mis en ligne des extraits de "Love Again" sur son profil Suno à http://suno.com/loveagain . Pour participer au concours :

1. Sélectionnez un stem

2. Transformez « Love Again » en un style musical différent en utilisant la fonction Covers de Suno.

N'hésitez pas à utiliser des outils Suno supplémentaires pour créer des remix magiques (ex. Extend, Replace Section, etc.)

3. Rendez votre chanson publique et votre remix sera soumis automatiquement !

Deadline : 8 novembre.

La video de la semaine

La vidéo de la semaine est aussi jolie qu’originale. Outils utilisés : Midjourney et Kling.

Credits: SpiraLuv_Creative

Et toi, tu fais quoi avec l’IA ?

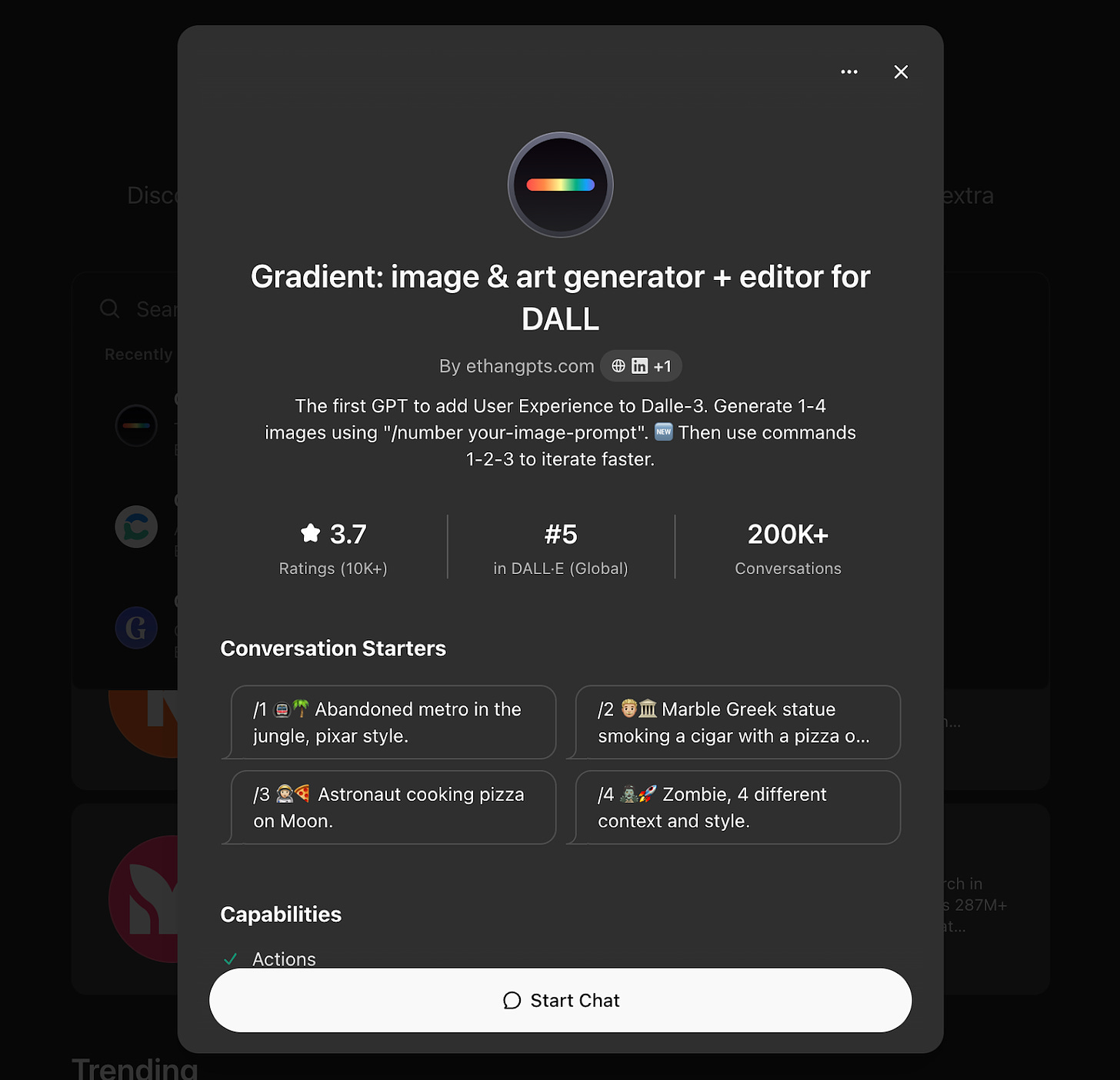

Cette semaine, j’ai le plaisir de publier une interview d’Ethan Safar que j’ai réalisée il y a plusieurs mois déjà. Ethan a eu la gentillesse de la mettre à jour avant publication.

✅ Bonjour Ethan, peux-tu te présenter brièvement ?

Bonjour Ethan Safar, 23 ans, créateur d’un GPT de génération d’image classé 5ème monde sur le Store d’OpenAI, sur plus de 3M d’applications existantes. Mon combat est presque devenu politique. Je me bat contre les colosses Américains: Canva (valorisé à $50Md), Adobe (valorisé à $400Md) et j’en passe.

A ce jour, +4M d’images ont été générées avec mon GPT “Gradient”, et 64.566 utilisateurs ont été actifs sur les 30 derniers jours, et me font confiance.

Pour accéder à la version complète, voici le lien : https://ethangpts.com/

✅ Peux-tu nous parler de ta découverte des GPTs ?

Je suivais les travaux d’OpenAI déjà depuis Février-Mars 2022.

Dès qu’ils sortent DALL·E 2, j’accède à la bêta fermée en avant première. Je sentais déjà cette magie que le monde n’était pas prêt à découvrir.

Je découvre le playground d’OpenAI sur lequel ils sortent les accès par API à leur modèle GPT-3.5. C’était la première fois que j’ai pu parler avec un “robot” qui répondait comme un “humain” et qui semblait “intelligent”. J’y vois un futur changement sociétal fort.

C’est pourquoi je décide de les intégrer dans une interface web: Je venais de créer une ébauche de ChatGPT, 6 mois avant la sortie de ChatGPT.

…Et le 6 novembre 2023, Sam Altman, annonce un lancement imminent de leur Store d’applications AI.

Cela a représenté pour moi, une opportunité exceptionnelle.

180 millions d’utilisateurs mensuels. Quiconque arrivait à se rendre visible, allait pouvoir acquérir un trafic monstrueux.

“Jamais deux sans trois” je me suis dit, et c’est comme ça que j’y retourne le 22 décembre 2023.

✅ Peux-tu nous raconter comment tu t'es lancé dans la création d'une centaine de GPTs ? Quel a été ton process ?

Pour déjà comprendre le contexte: En décembre 2023, en 2 ans je n’avais pris que 4 jours de vacances, car trop occupé sur ma startup. Je décide de faire un break. 12 jours. Je n’allais sûrement pas reprendre de vacances de sitôt, donc c’était pendant ces 12 jours ou jamais. J’ai donc décidé que cela serait pendant ces vacances.

Le temps était court pour créer ces applications. Il était nécessaire que je sois efficace. J’étais dans l’urgence. Le Store d’OpenAI pouvait sortir d’une minute à l’autre. J’ai donc pris mon 1er jour complet pour mettre en place ma stratégie pour les 11 jours suivants.

Nous n’avions aucun historique, aucune data, c’est pourquoi :

1- J’ai donc étudié autant que possible ce qui existait

2- J’ai testé 10 stratégies différentes en parallèle pour récolter mes propres datas et adapter mon plan.

3- Déployé plus de 100 applications pour aller tester 100 niches différentes, et ainsi augmenter mes chances d’en avoir une qui soit utilisée et devienne populaire.

✅ Quels ont été les plus grands défis rencontrés lors du développement de ces GPTs ?

Le manque de temps qui me contraignait à ne pas gaspiller la moindre minute. Le manque d’outils (et de données) pour suivre le comportement des utilisateurs.

Le manque d’historique d’applications qui avaient bien marché.

✅ Comment penses tu que tu as fait pour devenir Top 5 Monde et Numéro 1 Europe ? (sur +3M d’applications)

Vaste question. Mais si je devais donner quelques éléments qui m’ont permis d’y arriver, je dirais :

1- J’ai travaillé au maximum de mes capacités pendant le rush des 12 jours.

2- Je remettais en questions ce que je savais en permanence.

3- Le test and learn rapide est le meilleur moyen d’apprendre.

4- Une meilleure compréhension même infime, vous donne un unfair advantage, et vous fait passer devant tout le monde.

Si je devais être honnête, je dirais que c’était en réalité assez simple. Ça ne m’a pas demandé beaucoup d’efforts en comparaison avec les résultats obtenus.

✅ Pourquoi cela ?

Parce que c’est mathématique. 180M de personnes dans le monde utilisent ChatGPT tous les mois. Vous vous rendez visible sur leur plateforme, vous aurez des gens qui utiliseront votre app. S’ils aiment, ils reviendront. De nouveaux vont venir essayer. Votre application croît. Vous écoutez les retours et améliorez votre app en même temps. Et un matin, vous vous réveillez comme d’habitude, et vous faites déjà partie des meilleurs.

✅ De manière simple et didactique, quels conseils donnerais tu à celles et ceux qui veulent créer leurs propres GPTs ?

Pour ceux qui souhaiteraient commencer à créer leurs GPTs, je leur conseillerais :

Commencer par utiliser des GPTs existants qui sont populaires.

Comprendre ce qui fait leur force ainsi que leurs faiblesses.

Utiliser ce savoir pour "sentir" comment créer ses GPTs.

Adopter l’approche Startup et déployer de petites applications rapidement, et aller tester son hypothèse de marché le plus vite possible.

Lorsque des signes simples de traction ont été trouvés, améliorer l’expérience utilisateur pour en faire un vrai produit qui accélèrera la croissance de l’application.

Et pour ceux qui souhaiteraient aller plus loin, envoyez moi un message sur Linkedin je serais ravi de pouvoir vous aider.

✅ D'une manière générale, quel est ton rapport personnel aux outils d'IA générative et comment les utilises tu dans ton quotidien ?

J’utilise quotidiennement ces outils. Dans la vie pro ou perso.

Par exemple, j’ai créé un GPT que j’ai appelé “The Ultimate Startup Board” (https://chatgpt.com/g/g-slbE37t9P-startup-board-startup-pitch-business-vcs). C’est une application qui simule le mode de pensée des entrepreneurs à succès Sam Altman, Steve Jobs, Elon Musk, Jeff Bezos et Mark Zuckerberg. Dès que j’ai une question stratégique, je leur demande. Ils m’aident à réfléchir et à brainstormer.

Ou encore, j’utilise un GPT pour m’aider à la rédaction de mes posts LinkedIn afin de gagner du temps. (https://chatgpt.com/g/g-dAS9GbA5U-nolinkedin-post-copywriter-writer-expert)

✅ En regardant vers l'année 2025, quels développements majeurs anticipes-tu dans l'utilisation de l'IA générative ? Y a-t-il des avancées technologiques spécifiques que tu attends avec impatience ?

La robotique. Le spatial. La santé.

Je ne saurais dire si c’est une bonne idée ou pas de “l’attendre avec impatience”, mais comme elle arrivera et que ça n’est qu’une question de temps, j’aimerais pouvoir faire partie des premiers à discuter avec l’AGI.

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇