Salut les Laurent, les Laurence, les Laura, les Laurettes, les Lawrence et les autres. Cette semaine, nous vous parlons de news, encore et toujours : une semaine sans news en IA générative c’est comme un morceau de funk sans basse, un Jedi sans sabre laser ou un texte de chatGPT sans le mot “crucial” : ça n’existe pas.

Nous vous parlons également des LoRA, très en tendance depuis que Flux 1.0, modèle open source présenté dans l’édition de la rentrée, s’est répandu sur Internet comme une vidéo deepfake de Donald Trump.

Il y en a partout.

On vous explique ce que c’est et tout ce qu’on peut faire avec, à commencer par des avatars. Non, cette newsletter n’est pas en train de virer au culte de la personnalité mais j’avoue beaucoup m’amuser avec ces outils.

Au sommaire :

Les (nombreuses) news de la semaine

L’ère des LoRA

Les vidéos IA de la semaine

Au fait…

On me dit souvent que si on associe volontiers mon nom à l’IA générative, on ne sait pas précisément ce que je fais avec cette technologie.

Je forme des profils communicants et créatifs aux outils d’IA génératif (ChatGPT, Midjourney, Flux, Runway, Kling, génération de voix et de sons).

Je créé également des contenus visuels (image, vidéo, sons) avec l’IA.

Les news de la semaine

Un nouveau chatGPT !

OpenAI dévoile ses nouveaux modèles "o1 Series". Ces modèles, nommés "o1-preview" et "o1-mini", sont conçus pour réfléchir avant de répondre, améliorant significativement les performances en mathématiques, physique et programmation. Ils se distinguent des modèles GPT précédents par leur capacité à raisonner de manière autonome, offrant une réflexion plus approfondie et une meilleure adhérence aux directives de sécurité, tout en étant accessibles via ChatGPT Plus et diverses API.

Le modèle est disponible pour tous les abonnés payants.

L’IA Video arrive chez Adobe !

À l'approche d'Adobe Max, la conférence annuelle d’Adobe sur la créativité, la firme de San José annonce un aperçu de Creative Cloud 2025 avec un nouveau modèle de génération de vidéo IA : Adobe Firefly Video.

Au menu: text-to-video et image-to-video. Le lancement est imminent, avec une inscription déjà ouverte pour la liste d'attente.

Regardez la démo, Adobe Firefly Video semble prometteur :

Uncanny Valley 3.0

HeyGen annonce leur nouvel Avatar 3.0. La nouveauté c’es que les expressions faciales et le ton de la voix des avatars sont générés de manière dynamique pour correspondre parfaitement au script.

La recherche dans Google Photo devient plus intuitive

Google ouvre un un accès anticipé à Ask Photos, une expérience de recherche conversationnelle alimentée par Gemini, pour certains utilisateurs aux États-Unis.

Les utilisateurs pourront effectuer des recherches dans leurs albums photos en utilisant un langage courant. Par exemple, vous pouvez rechercher des photos spécifiques de manière naturelle et descriptive, comme "Alice et moi en train de rire", "Kayak sur un lac entouré de montagnes" ou "Emma en train de peindre dans le jardin".

Ideogram intégré à Remix AI

Remix AI c’est le Instagram de l’IA générative : vous pouvez créer, partager, liker, admirez ou même “remixer” des créations. Ideogram est désormais intégré à l’app.

Getty Images x Hugginface

Getty Images, connue pour permettre le partage, la découverte et l'achat de contenus visuels de photographes et vidéastes du monde entier, a annoncé mettre à disposition des images de sa bibliothèque en tant que données ouvertes sur Hugging Face.

Bien qu'il existe de nombreux jeux de données visuelles sur Hugging Face, Getty revendique “une sélection soignée sans infographies excessives et contenu NSFW, aucune image de célébrité indésirable, aucune marque déposée, produits ou personnages, ou personnes ou lieux identifiables dans les données d'entraînement”, ainsi que des des informations détaillées sur les droits d'utilisation.

Roblox va permettre de générer des environnements 3D

Roblox prévoit de déployer un outil d'IA générative qui permettra de créer des scènes 3D entières à l'aide de prompts.

Une fois qu'il sera opérationnel, les développeurs de la plateforme pourront simplement écrire "Générer une route dans le désert", par exemple, et l'IA en créera une. Les utilisateurs pourront également modifier les scènes ou élargir leur champ d'action, par exemple en transformant une scène diurne en scène nocturne ou en remplaçant le désert par une forêt.

Read my lips

Le site https://www.readtheirlips.com/ permet d’uploader une vidéo d’une personne qui parle, sans le son, et de trasncrire le contenu de son discours :

Dans la pratique, ça fonctionne un peu moins bien selon cet utilisateur Twitter :

Kling Standard vs Kling Pro

A celles et ceux qui se demandent si l’abonnement à Kling Pro vaut le coup / le coût, cet utilisateur propose une réponse en video.

TLDR : meilleures animations, définition et cohérence avec la version pro :

Letz AI V3

L’excellente plateforme Letz.ai a sorti un version V3 qui introduit une amélioration notable en matière de photoréalisme et de styles artistiques, offrant des images plus réalistes et un contrôle accru des détails. Elle comprend également une interprétation plus intelligente des prompts en langage naturel. Toutefois, produire avec V3 coûtera plus cher, environ 50 crédits par image, contre 30 pour la version précédente.

Emotions synthétiques

Hailuoai Minimax dont je vous parlais récemment s’affirme progressivement comme ce qu’il se fait de plus proche de Sora à l’heure actuelle. Dans la vidéo ci-dessous, Minimax est mis à l’épreuve de la reproduction des émotions humaines.

Bien qu’imparfait, le résultat est troublant, je ne m’attendais pas à ça aussitôt.

Qu’en pensez-vous ?

Sora strikes back !

Comme nous, OpenAI doit commencer à sentir le souffle rauque de ses concurrents derrière la nuque de Sora, et a publié il y a quelques jours une vidéo réalisée par l’artiste Londonien David Sheldrick, pour rappeler qui était le patron. Quelques plans impressionnants. D’autres moins, la faute à beaucoup d’éléments à gérer dans l’image.

Alors Sora, tu sortiras un jour ? (Shut up and take my money)

Une autre vidéo Sora nous vient de Niceaunties, un artiste basé à Singapour. Un très court métrage surréaliste pour lequel la vidéo IA semble particulièrement adaptée, regardez :

Real Time Flux

La plateforme krea.ai dont on pense beaucoup de bien ici, propose désormais Flux en real time.

Pour la fraise ça fera 2K

Avec l’arrivée de son nouveau modèle appelé Strawberry “o1” (cf 1ère news), OpenAI pourrait proposer un abonnement Chat GPT Premium à 2000$ … sans que l’on sache encore s’il s’agit d’un tarif mensuel ou annuel . Clairement pas accessible à tout le monde. Le début d’une IA à 2 vitesses ?

Petit interlude

NOVA-2 ULTRA BON

La startup française Sezam a sorti sa version personnalisé de Flux. Baptisé Nova, il se décline en deux versions :

1️⃣ Nova-2 Ultra : génère des images photoréalistes avec un excellent niveau de détails, le tout avec une résolution 3K. Tout comme Flux, le modèle revendique une excellente compréhension des prompts, même lorsqu'ils sont longs et descriptifs.

2️⃣ Nova-2 Fast : Moins quali mais ultra-rapide, il génère des images et du texte en 5 secondes chrono tout en offrant une excellente interprétation des prompts.

Sezam m'a donné un accès à Nova-2 dès lundi dernier, j'ai eu le loisir de tester le modèle en profondeur et je dois avouer que j'ai été impressionné au point de proposer un quizz comparatif vs Midjourney 6.1 sur Linkedin.

”ON VERRA ÇA EN POST-PROD”

La plateforme Reshot.ai propose une technologie qui permet de modifier les expressions faciales de vos photos en temps réel. Regardez :

Et en pratique, c’est super efficace :

RUMEUR

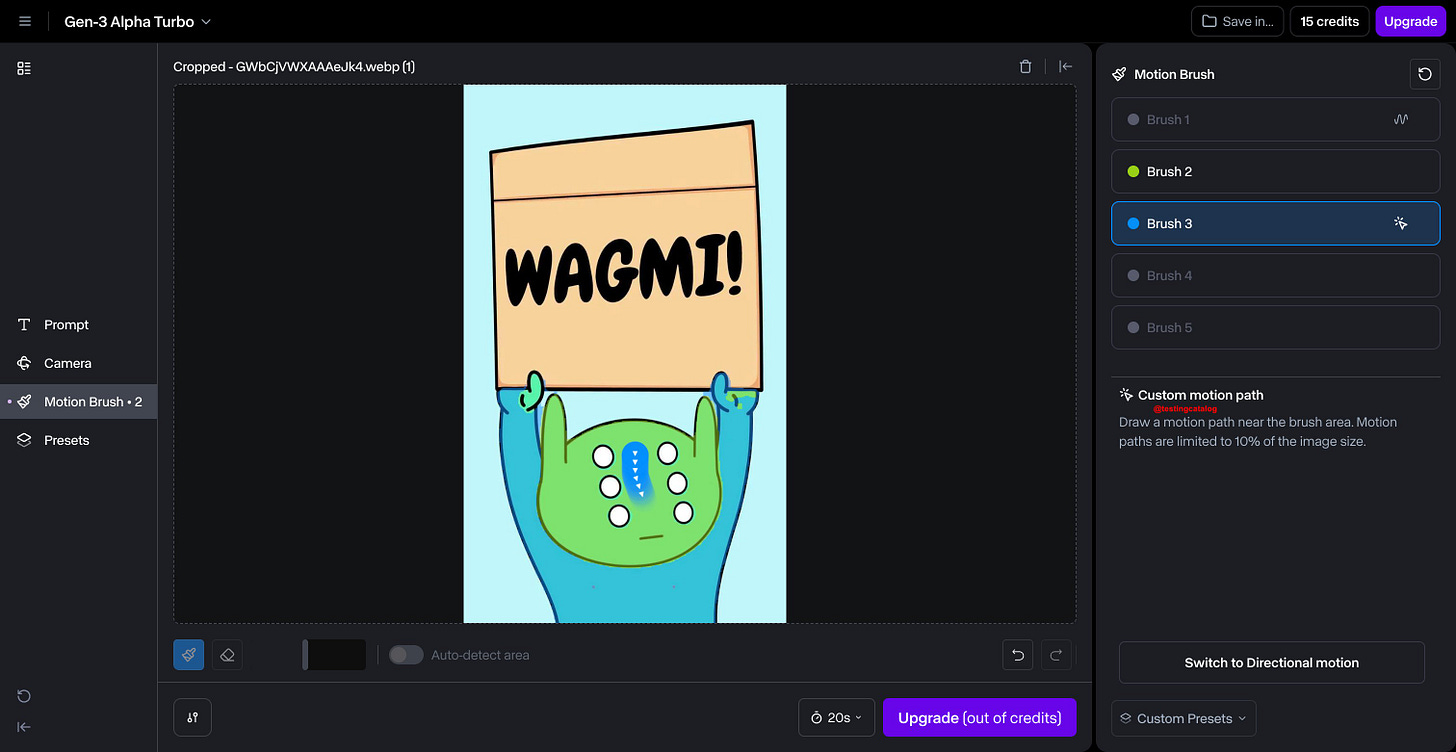

Runway serait sur le point de publier sa fonctionnalité Motion Brush pour Gen3 avec un “Custom Motion path”. En clair, les utilisateurs pourront spécifier une direction personnalisée pour une zone sélectionnée dans Motion Brush.

Peinture animée

Une tendance actuelle sur les réseaux est d’animer des peintures célèbres avec des outils de génération de vidéo IA :

TESTEZ VOTRE FAST-PROMPTING

Testez vos compétences de fast-prompting avec « Riddle me This ! » une plateforme ludique qui propose du reverse-prompting :

Le principe : Vous voyez une image, vous rédigez un prompt qui correspond cette image.

Attention : faites des prompts courts ! Et à moins d’être 100% débutants, n’y voyez pas un outil pédagogique. C’est surtout un divertissement.

Bonus : vous pouvez créer vos propres quizz, voici le mien :

https://riddlemethis.xyz/play/a8eba9c

P.S. J'ai fait 410 points sur le quizz Lord of The Rings du 6 septembre !

Le Deepfake de la semaine

Askip, “it was very Messi in the eighties”

L’ère des LoRA

Je sais que vous avez remarqué les photos de moi dans les les dernières éditions.

Tantôt sous l’eau, tantôt en train de manger du popcorn, tantôt dans les nages…

Un Lo Quoi ?

LoRA, ou Low-Rank Adaptation, est une technique astucieuse pour adapter de grands modèles de langage pré-entraînés à des tâches spécifiques sans avoir à réentraîner l'ensemble du modèle. LoRA se concentre sur l'adaptation de certaines parties spécifiques pour obtenir des résultats précis.

Comment ça marche ?

Modèle de base : Vous partez d'un modèle pré-entraîné capable de générer une grande variété d'images (exemple FLUX 1.0)

Adaptation ciblée : LoRA ajoute de petits modules d'adaptation à ce modèle de base. Ces modules apprennent à modifier subtilement le processus de génération pour produire des images correspondant à un style, un sujet ou une caractéristique spécifique.

Entraînement léger : L'entraînement de ces modules LoRA est beaucoup plus rapide et nécessite moins de ressources que l'entraînement complet du modèle de base.

Exemples d'applications

Création de personnages uniques : Générez des portraits de personnages spécifiques (vous ou un personnage imaginaire)

Reproduction de styles artistiques : Imitez le style de Van Gogh, Picasso, etc…

Génération d'images cohérentes : Créez des séries d'images qui partagent une esthétique commune.

En résumé, LoRA est un outil très puissant pour pallier une des faiblesses de l’IA générative : le contrôle.

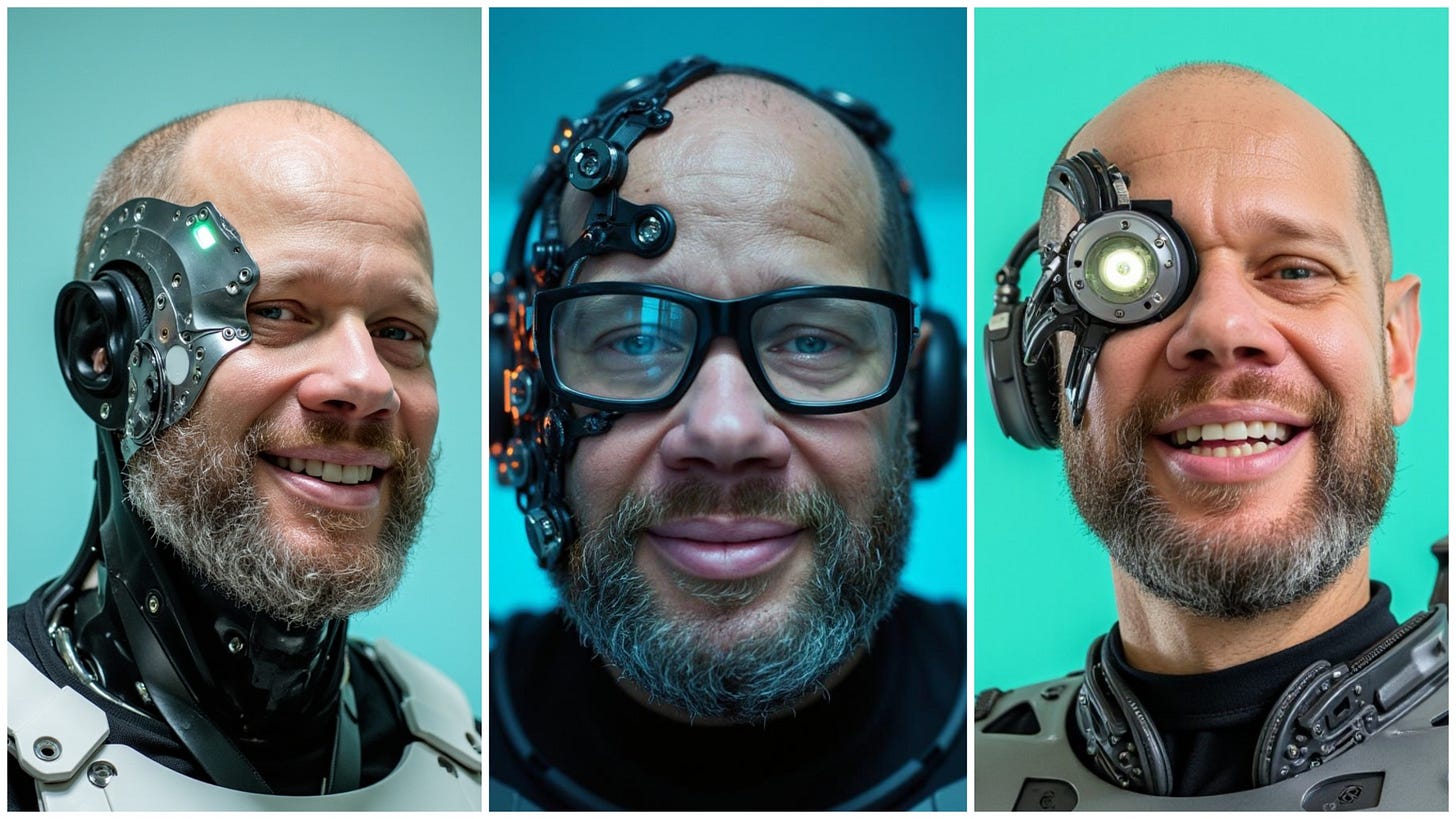

Plusieurs plateformes proposent d’entrainer se propres LoRA sur les visuels de son choix. J’ai choisi d’en tester 3 avec des photos de moi, dans l’objectif de me constituer une armée de clones virtuels.

J’aborderai Fal.ai, Astria.ai et Replicate.com.

Sachez que vous pouvez également utiliser d’autres platfortmes comme civit.ai ou TheFluxTrain

Pour faire vite car je sais que ton temps est compté, les 3 plateformes proposent peu ou prou les même fonctionnalités mais je préfère utiliser fal.ai pour 2 raisons :

- Qualité des outputs

- Générations hyper rapides

Astria se distingue par des générations super quali, mais plus lentes.

Replicate est légèrement en-dessous dans mes tests : il lisse un peu trop la peau et à tendance à vous faire des sourires d’enfants de maternelle.

Sur Fal.ai, tout commence à partir de la homepage. Cliquez sur “Train a Flux LorA”

Ensuite vous uploadez une quinzaine de photos de vous (des selfies suffisent). Vous pouvez même zipper vos photos pour gagner du temps.

Vous définissez un “trigger word”, vous mettez une pièce dans la machine (2$ sur Fal.ai) , vous cliquez et vous allez faire un tour le temps que ça mouline (quelques minutes sur Fal.ai, 1h environ sur les autres les plateformes).

Une fois que c’est prêt, vous promptez en utilisant le “trigger word” pour activer la LoRA. Sinon, vous obtenez une génération Flux “normale” avec des personnages random.

J’avoue avoir bien rigolé.

Sur Astria.ai, vous pouvez également définir un style visuel, par exemple “Animated” :

Comme vous pouvez le constater :

- la qualité est excellente

- je ressemble un peu plus à Benicio Del Toro qu’à Donald Trump

- les possibilités sont infinies pour vos avatars

Vous pouvez même refaire vos photos de profil Linkedin sans sortir de chez vous :

N’oubliez pas de sauvegarder les images qui vous plaisent, je ne pense pas que la plateforme les enregistre quelque part.

Mais je sens déjà poindre LA question des professionnels du marketing de grands groupes ou de startups : “Est-ce qu’on peut faire la même chose avec des visuels produits ?”

Excellente question Jean-Kevin, merci de l’avoir posée.

Nous nous pencherons sur cette question dans l’édition de la semaine prochaine !

Alors, les visages c’est bien joli, mais c’est quoi le next level ?

Le next level, c’est ajouter de la vidéo pardi !

Et là, on entre dans le territoire du deepfake.

Les vidéos IA de la semaine

La petite bombe de la semaine nous vient de Singapour. Le jeune réalisateur Huang Lu nous a sorti un “banger” comme dirait Antoine. Une séquence de tension de 45 secondes, digne d’une production hollywoodienne, entièrement réalisée en text-to-video avec Minimax.

Deux choses frappent ici : la cohérence entre les plans (même si vous verrez les différences en comparant des screenshots) et la qualité du découpage. Le spectateur est plongé dans une séquence de tension dès les premières secondes, ça fonctionne hyper bien. Mention spéciale au sound design au petits oignons :

La 2e vidéo est en phase avec l’actualité internationale et met en scène Donald Trump et Kamala Harris, les deux candidats à la présidence des Etats Unis qui ont débattu mardi soir.

Réalisée par Meta Puppet, elle vaut le visionnage :

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇

Hi there, I am the creator of thefluxtrain.com , thank you for mentioning us.