LA CENTIÈME !!

Bienvenue à toi lectrice, lecteur, dans cette 100e édition de GENERATIVE !

Lorsque j’ai lancé cette newsletter en avril 2023, j’étais loin de me douter qu’il y en aurait un jour 100 éditions, ni que vous seriez plus de 6000 à nous lire chaque semaine.

Merci à vous pour votre fidélité et votre confiance renouvelée.

Cette semaine, comme à peu près chaque semaine depuis des mois, une avalanche de news compilée avec l’aide de ma fidèle camarade Caroline Thireau.

Pour rappel, si vous voulez apprendre la génération d’images et de vidéos avec moi, je vous propose une session de formation les 19 et 20 mùars à Paris, vous pouvez vous inscrire ici :

https://road-cream-7fa.notion.site/196826eb18dc80c49e64c3aad6449642

Sans plus attendre, accrochez vos ceintures, c’est parti pour la centième !

🔹 Runway : Restyled First Frame

Runway Gen-3 Alpha a ouvert Restyle Video en early access : vous pouvez appliquer un style à une vidéo grâce à une image clé appelée ici “input frame”. Le rendu mélange texture et style de l’image d’entrée avec une modulation possible du degré de transformation (générés avec vos différents outils habituels comme Midjourney, Magnific ou autres…). Cette technique permettra d’uniformiser l’ensemble d’un clip même si les premiers testeurs nous signalent des changements parfois trop radicaux et quelques artefacts. Voici la démo officielle :

Des tests de Ludovit Nastisin ensuite, qui nous montre les limites avec de l’illustration / sketch :

Ici, ceux de Leo kadieff qui dévoile davantage de potentiel :

Et enfin, pour les adeptes du “tout local”, voici un exemple de Arminas Valunas qui passe par ThinkDiffusion sur ComfyUI pour générer son “first frame”, un LoRa Pop Art avec le modèle SDXL et Controlnet, avant d’utiliser cette nouvelle fonctionnalité dans Runway.

🔹 Luma Ray 2 s’étoffe

Luma Dream Machine intègre 3 nouvelles fonctionnalités à Ray 2 :

- ses légendaires Keyframes pour un meilleur contrôle sur les générations image par image

- l’Extend par tranche de 5 sec.

- l’effet Loop à activer (à vous de voir ce à quoi ça peut vous être utile!)

Dispo dès maintenant.

🔹 Freepik Colors

Freepik permet de générer des images avec votre propre moodboard en choisissant votre propre palette de couleurs à l’aide des codes hexadécimales ou de moodboards préétablis. Un bon point pour la cohérence colorimétrique !

🔹 Idéogram 2a

Idéogram 2a arrive avec une génération d’images et de texte ultra-rapide : 10 secondes, voire 5 avec la version Turbo. La bonne nouvelle, c’est aussi la baisse de prix de 50 % sur le site en direct. Intéressant quand on sait que sur Freepik qu’ils ont rejoint la semaine dernière (dont nous parlions ici), les générations Ideogram coûtaient le double par rapport aux autres modèles.

🔹 Magnific AI & son Mystic Structure Reference

Magnific AI dévoile Mystic Structure Reference, un outil qui permet de garder une structure précise lors de la génération d’images ce qui offre une flexibilité totale entre différents styles.

🔹 Freepik & son AI Sound Effect Generator

Nouvelle fonctionnalité Freepik pour prompter des bruitages pour vos vidéos

🔹 LTX Studio

LTX apporte des nouveautés sur sa version 0.9.5 : les très attendues keyframes pour contrôler les images de début et fin, une meilleure résolution, des séquences plus longues et licence commerciale pour les projets pro. Disponible sur ComfyUI.

Des son côté, LTX Studio sort de sa béta et lance son service de plateforme complète de création vidéo.

🔹 Le new kid de la semaine : DiffRhythm Ai

DiffRhythm génère des morceaux de 4 minutes avec voix en moins de 10 secondes. Ce modèle poids léger (<2.5GB) concurrence directement Suno et Udio sur la génération musicale.

🔹RenderNet

RenderNet AI dévoile une future fonctionnalité qui intègrera des photos de produits réels dans des contenus IA. Les marques sur Amazon ou Shopify pourront associer objets physiques et personnages virtuels en images comme en vidéos. On attend maintenant une sortie officielle.

🔹 Finegrain

Une nouvelle fonctionnalité permet d’allumer les lampes sur n’importe quelle photo avec un réalisme bluffant. Ombres, reflets et lueurs semblent s’adaptent naturellement, comme si la scène était réellement éclairée. Envie de tester ? Plus d’info sur ce Discord.

🔹Hunyuan se met à l’image to video

Hunyuan a lancé un nouveau modèle AI Image2Video open source. Ce modèle offre des contrôles avancés, une résolution en 720p, ainsi qu'une fonctionnalité LoRA pour personnaliser vos contenus.

🔹ElevenLabs under control

ElevenLabs ajoute des contrôles de vitesse vocale à son Studio, au text-to-speech (TTS), aux IA conversationnelles et dans son API. Pas encore optimal, il vous faudra ajustez le rythme mot par mot pour plus de naturel dans les dialogues…

🔹 Hedra Studio : IA vidéo tout-en-un

Hedra Studio lance Character-3, premier modèle omnimodal en production qui combine génération de texte, image et audio. La plateforme prévoit ainsi de pouvoir générer facilement des séquences complètes. Sur cette démo, on voit de nets progrès par rapport à la version précédente, mais l’impression globale manque encore un peu de naturel, qu’en pensez-vous ?

🔹Staircase Studios AI

Staircase Studios AI dévoile les 5 premières minutes de The Woman with Red Hair, un film sur Johanna "Hannie" Schaft, résistante communiste néerlandaise. Produit par Pouya Shahbazian (Divergente), écrit par Michael Schatz, il combine IA et voix d’acteurs réels. Un premier projet d’une série de 30 films à venir.

🔹Quand Krea fait du Pika

Si vous avez un abonnement Krea, sachez que les différentes fonctionnalités Pika y sont disponibles : change region, add elements, frame interpolation, mix images…

🔹Letz Ai

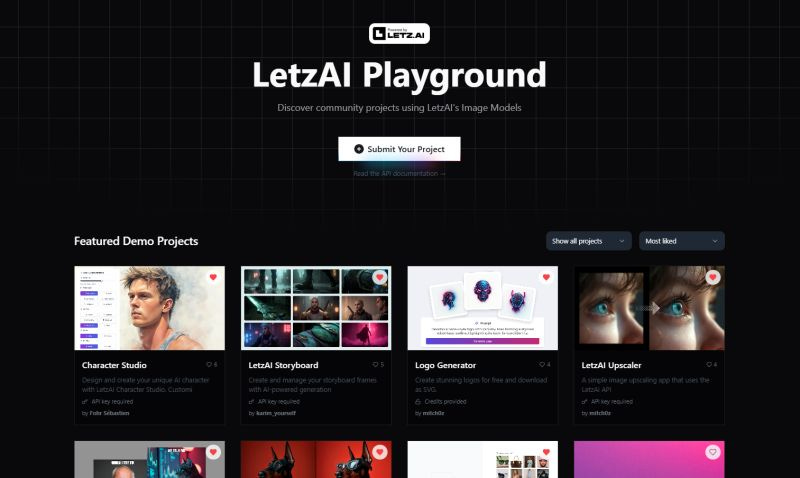

LetzAI lance Playground, un espace pour créer et partager des apps IA. Son API permet de générer, modifier et améliorer des images avec des modèles communautaires. 25 000 crédits gratuits pour ceux qui veulent tester.

🔹Le comparatif de la semaine

Après des tests intensifs avec le même prompt sur Sora, Kling 1.6 et Google Veo 2, voici le verdict de Tobias M Huber - producteur allemand de films et publicités, pionnier de l’IA générative dans le cinéma et les séries- par ordre de préférence.

• KLING (1920x1080, 30fps) : HD, lipsync et bon mouvement mais des personnages bavards

• VEO 2 (1280x720, 24fps) : bon mouvement mais coupes aléatoires et pas d’img2vid.

• SORA (1920x1080, 30fps) : bonne qualité mais cher et parfois figé.

Est-ce que comme pour Gilles, il s’agit de la première phase de déception avant de comprendre les rouages d’un Sora ?

🔹 Higgsfield AI

Higgsfield AI devient publique et annonce des nouveautés majeures pour la création vidéo IA :

- des vidéos jusqu'à 3 minutes

- un co-pilote créatif pour affiner scénarios et styles

- des styles pré-entraînés & LoRAs

- la personnalisation de styles sur mesure

Encore un peu de patience avant d’être accessible prochainement !

Les pépites de la semaine, c’est d’abord ce clip assez incroyable de Jérémy Rubier

3 mois de travail, 22,000 images et 4,000 générations vidéo, regardez :

Et la dernière réalisation du talentueux Paul Trillo, qui propose un workflow inédit qui combine l'animation 2D traditionnelle avec des outils d'IA expérimentaux.

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇

merci pour les news. C'est clair et précis. Luv it

Bravo x100 !!!! et merci