It's coming back around again

Salut les éclectiques supersoniques, ceux qui s’intéressent à tout ce que propose l’IA générative et qui sont capables de courir au delà de la vitesse du son. Ce sont là les pré-requis indispensables pour pouvoir suivre de près tout ce qui se passe dans ce microcosme en perpétuelle ébullition.

Bienvenue dans cette 122e édition.

Cette semaine est placée sous le signe de Nano Banana (encore ) mais aussi d’une légère accalmie en comparaison avec le tsunami en 2 parties de la semaine dernière. Mais rassurez vous, ça tabasse quand même fort.

Des fois je me dis qu’il est un peu vain d’essayer de rattraper le train de la GEN AI.

Puis je regarde Caro. Et je me dis qu’elle court quand même sacrément vite.

(Midjourney video)

Allez, let’s go !

Si ce n'est pas déjà fait, tu peux aussi :

Découvrir mes formations IA pour les créateurs, 100% finançables par le CPF. Les inscriptions se font ici. La session de Paris est full ! Il me reste quelques places pour Marseille. Viens, si en + de l’IA, tu aimes la mer et le soleil

Former tes équipes à l'IA générative grâce à nos formations entreprise finançables par ton OPCO

Nous contacter directement pour discuter de ton projet IA générative

Me suivre sur LinkedIn, YouTube ou TikTok pour ne rien rater.

Et c'est parti ! 🚀

🟦 CÔTÉ PLATEFORMES & SUITES IA

🔹 Freepik – Visual Prompt

LA grosse news de la semaine c’est Freepik (encore et toujours) qui ajoute les “Visual prompts” à Google Nano Banana. Les utilisateurs peuvent annoter directement une image pour générer des résultats précis, sans recourir à des prompts complexes.

Ça fait deux ans qu’on le répète : le “prompt engineering” est une compétence qui va disparaitre pour les outils grand public. Le Graal pour les éditeurs, c’est la communication en langage naturel télégraphique : “change la couleur de ça” - “enlève ce truc” - “ajoute des arbres”, etc…

🔹 Higgsfield & Nano Banana gratuit 1 an…

Higgsfield propose un an d’accès illimité à Nano Banana. L’offre comprend des applications maison comme “GTAI”, “Latex” ou “3D Render”. Les utilisateurs peuvent expérimenter librement pour créer vidéos, publicités fictives ou contenus immersifs. Offre limitée disponible uniquement cette semaine.

… des presets K-Pop dans WAN 2.2 p

C’est aussi 10 préréglages de mouvements inspirés de la K-Pop qui viennent compléter leur offre WAN 2.2 avec des gestes iconiques comme le cœur de doigts, les trends ou danses virales deviennent “générables” en un clic. L’outil démocratise l’accès à cette culture. “Fans, créateurs et marques peuvent s’approprier ces codes visuels pour produire des performances virales et interactives.”

Pour les personnes âgées de plus de 18 ans, il est difficile de dire avec certitude s’il s’agit d’une avancée ou d’une régression. Qu’en pensez vous ?

Et ça continue encore avec son UGC factory :

🔹 Weavy & Modélisation 3D

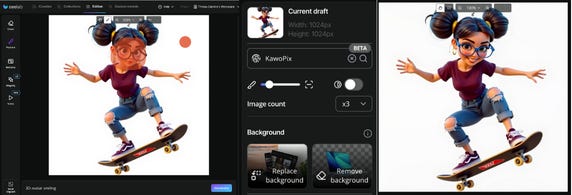

La particularité de Weavy c’est que ce sont souvent les “Weavers” qui partagent leurs workflows. Pour mémoire, Weavy est un outil nodal de création IA (une sorte de ComfyUI simplifié), dont Caro est archi fan (Gilles n’a pas encore trouvé le temps d’en soulever le capot)

Ici on nous propose un processus simplifié pour générer des angles variés de personnages 3D. Il combine angles de caméra, prompt et images clés de Kling 2.1 pour créer des rendus cohérents et dynamiques. Nano Banana permet d’obtenir différents angles de vue, par contre pour une meilleure qualité 3D, Hunyuan 2.5 reste de rigueur.

Ross Symons explique avoir conçu un jeu de plateforme en quelques heures grâce à Weavy pour générer les assets avec Nano Banana et Rodin (3D). Construit en vibe coding dans Replit (comprendre, en langage naturel), aucune compétence de codage n’a été nécessaire.

Enfin, voici une masterclass de Rory Flynn, connu pour ses partages sur Midjourney et en charge du Creative Council de Wonder Studios depuis avril dernier :

🔹 ElevenLabs & SFX V2

La nouvelle version du moteur SFX d’ElevenLabs génère des effets sonores plus qualitatifs, disponibles en boucle, allant jusqu’à 30 secondes avec un échantillonnage en 48 kHz. Directement intégrés dans Studio, les sons d’ambiance (pluie, vagues, vent…) sont disponibles en MP3 et WAV sur tous les plans, y compris gratuit, ce qui peut être utile pour tous les créateurs qui ne disposent pas de banques de sons professionnels.

On vous partage ici une démo de Heather Cooper :

🔹Hedra & Minimax Speech 2.5

Avec Minimax Speech 2.5 maintenant dans Hedra, le phrasé semble plus naturel et fluide, la prononciation plus précise et l’intonation réaliste dans 40+ langues.

Nous on trouve qu’il y a encore un peu trop de mouvements de tête, et vous ?

🔹 LTX Studio Project

LTX Studio regroupe désormais ses outils (Gen Space, Storyboard, Timeline) dans un espace projet unifié. Chaque projet intègre sa propre timeline enrichie (multi-clips, accrochage intelligent, annulation), un storyboard allégé et des sessions pour organiser les générations. Ce système accélère les workflows en centralisant toutes les étapes, de la conception initiale au montage final.

Et LTX Studio ajoute également Nano Banana à FLUX Premium. En appliquant un transfert de style et de texture précis, modifiant des zones spécifiques d’une scène et en déplaçant des personnages dans de nouveaux environnements grâce à la multi-référence, les transformations restent cohérentes visuellement, ce qui facilite l’intégration d’éléments variés dans un même rendu.

🔹 ImagineArt & Flow (Alpha)

Flow est une nouvelle interface nodale développée par ImagineArt. Elle permet de connecter génération image/vidéo, édition et automatisation au sein d’un seul flux visuel. Les créateurs lient différents “nœuds” pour adapter et réutiliser leurs idées, tout en ajustant les paramètres en temps réel. L’outil remplace la multiplication d’onglets et de fichiers dispersés, offrant un contrôle plus intuitif et flexible.

🔹 Photoshop, Gemini 2.5 Flash & Flux Kontext

Un script Photoshop intègre Gemini 2.5 Flash aka Nano Banana et Flux Kontext directement dans l’interface. Selon Rob de Winter, qui étant speaker à l’ADOBE Max cette année, Gemini assure cohérence des personnages et précision des couleurs, tandis que Flux gère bien le relighting et les variations d’ambiance. Le process est le même pour les 2 outils : l’utilisateur sélectionne une zone avec de l’inpainting, ajoute une image de référence et décrit la modification souhaitée avec un prompt. Les résultats se mélangent aux détails d’origine grâce aux masques, préservant la précision de Photoshop tout en profitant de la génération IA.

🔹 Adobe Firefly & infographie Nano Banana

Dans Adobe Firefly, Nano Banana aka Gemini 2.5 Flash peut transformer une photo en infographie claire et structurée, sans avoir à préciser les objets ou lieux dans l’invite. L’utilisateur n’a qu’à indiquer « transformer en infographie » pour obtenir un rendu adapté, simplifiant fortement la création graphique. Un partage de l’AI Evangelist Kris Kashtanova.

🔹 VEED – Fabric 1.0

VEED.io lance Fabric 1.0, présenté comme un modèle permet de générer des vidéos où le personnage principal est totalement généré ou très modulable à partir de la vidéo d’origine : nouveaux angles de vue, placement de produit, style transfert… Un produit destiné aux créateurs de contenu social media, qui ressemble à ce qu’on trouve déjà chez nos amis d’Argil.

🔹 Apple – FastVLM et MobileCLIP2

Apple pédale fort pour rattraper son retard. La marque à la pomme lance FastVLM et MobileCLIP2 sur Hugging Face. Ces modèles très rapides et beaucoup plus petites que les modèles usuels, permettront une exécution locale. Ils ouvrent la voie à des applications de vision/langage en temps réel, comme le sous-titrage vidéo directement dans le navigateur, sans passer par des serveurs distants.

🔹 Architecture, 3D & Gaussian Splatting

Ça nous a donné envie de vous partager le concept de la designer June Chow qui rappelle que ce n’est pas l’image brute mais le concept spatial qui attire l’attention. Ses travaux viraux reposent sur la façon dont l’espace est pensé et détourné de sa fonction. Elle voit l’IA comme un support et non le centre de l’intérêt.

🔹 Suno Studio & Multi-track

Suno prépare une version avancée de son outil musical avec création multi-pistes, avec export MIDI et nouvelles fonctions. Les utilisateurs peuvent déjà rejoindre la liste d’attente. L’objectif pour la plateforme est bien d’élargir l’usage de l’IA dans la composition et l’arrangement.

🔹 SeeLab : Kontext & Lora (bêta)

Déjà intégré à leur outil d’upscale Magnify V2, Seelab.ai teste une combinaison de Kontext et LoRA, deux modules intégrés pour améliorer la génération et personnaliser les résultats sur des personages, un style ou des produits. La bêta vise à renforcer le contrôle des créateurs sur leur production d’images.

🔹 Mago – Transformation faciale

Spécialisé en transfert de style sur le format vidéo, Mago Studio applique des transformations faciales tout en conservant la cohérence des personnages, le mouvement naturel et la synchronisation labiale. Cela réduit le besoin de rotoscoping et keyframing manuel. Lien d’inscription à la bêta sur liste d’attente ici.

Gilles a testé avec la vidéo de Caro qui court plus vite que le train, c’est plutôt réussi :

🔹 Morphic & editing d’images

Basé sur la même technologie que pour leur One Shot Model, Morphic permet de remplacer des objets, changer l’environnement, ajouter des éléments ou modifier la perspective avec un simple prompt. Exemples : transformer un décor en camping de nuit, ajouter un personnage ou modifier un panneau publicitaire. Les résultats conservent proportions, perspective et cohérence. Dans la lignée des Flux Kontext, Reference, Nano banana & autres multi-elements. A comparer si vos journées font 77 heures comme les nôtres.

🔹 Dor Brothers – Pub Heineken IA

Les célèbres Dor Brothers présentent une publicité Heineken réalisée avec Google Nano Banana. Acteurs, décors et objets restent cohérents d’un plan à l’autre, résolvant un des défis majeurs de l’IA générative en vidéo. Le film démontre la maturité croissante de ces outils, tout en rappelant que la qualité d’une publicité repose toujours sur la créativité humaine.

🟧 LE COIN OPEN SOURCE

🔸 Le Workflow ComfyUI de la semaine

Le réalisateur Mick Mahler détaille un court-métrage IA conçu avec ComfyUI et modèles open source. Le workflow permet de remplacer des arrière-plans vidéos de manière interactive avec les acteurs, proches d’un tournage sur fond vert. Les scènes ont été tournées en une journée, puis enrichies dans Blender pour ajuster la mise en scène. Une approche qui réduit la préparation et concentre le travail sur l’éclairage et la prise de vue.

🔸 WAN InfiniteTalk – Lipdub open source

WAN InfiniteTalk est un modèle open source de lipdub qui rivalise avec les solutions commerciales disponible sur Github. Trois modes sont disponibles : image-vers-vidéo avec audio, vidéo-vers-vidéo pour synchronisation labiale, et multi-personnes. Distribué sous licence Apache-2.0, il s’installe via ComfyUI et Gradio avec poids et code accessibles. Pratique pour doublages et créations vidéo automatisées.

🔸 HunyuanWorld Voyager & Reconstruction 3D

Idem, Voyager est un projet de modèle open source disponible sur Github pour créer directement des vidéos de nuages de points exploitables en 3D, sans passer par COLMAP, l’outil classique et habituel pour reconstruire une scène 3D à partir de photos ou vidéos. Il intègre donc une mémoire 3D garantissant la cohérence géométrique lors des déplacements de caméra. Déjà classé premier sur le benchmark WorldScore de Stanford, il cible VR, simulation et jeux.

🔸MeshCoder & Conversion nuages de points

Encore à l’état de projet, MeshCoder prévoit de transformer des scans de nuages de points en scripts Python exploitables dans Blender. Ces fichiers deviendront des maillages modifiables et programmables, offrant un contrôle direct et rationnel sur la forme. Développé par le Shanghai AI Lab, l’outil rend le passage de la donnée brute à un mesh utilisable plus simple et rapide. Toutes les infos sur le projet dans l’article Shanghai AI Lab.

🔸 HunyuanVideo-Foley – Génération audio

Hunyuan rend disponible un framework open source Text-Video-to-Audio appelé Projet Foley. Il permet de générer un son haute fidélité correspondant parfaitement aux flux visuels, utile pour films, jeux ou vidéos. Cette approche supprime une partie du travail manuel de sound design en automatisant la correspondance image/audio.

🔹 Finaliste au Runway Gen:48

Le court-métrage de Lion El Aton, finaliste du concours mondial Runway Gen:48, se distingue par une mise en scène simple mais impactante. Réalisé en moins de 48 h selon les modalités du concours, il démontre comment l’IA peut soutenir une narration visuelle claire et sobre. Chaque plan est pensé avec retenue et efficacité, sans excès d’effets. Disponible en 4K ici, il illustre un usage réfléchi des outils IA dans un contexte compétitif.

🔹 Court-métrage ROPED de Cokau Lab

On a une seconde pépite cette semaine avec ROPED des copains de Cokau Lab (Achille Coquerel et Thomas Kauffman), un film développé à partir d’un ancien projet de clip. La réalisation est particulièrement réussie, avec un découpage très cinématographique. La musique et le sound design sont signés Fabrice Smadja (AOC Production). On vous laisse admirer le résultat :

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇

Toujours au top votre news. Pour ma part, très fan depuis longtemps de l'approche de June Show et comme Caro j'adore les plateformes avec les nœuds (Weavy ou Imagine art à laquelle je rajoute tldraw). Petite constatation sur l'aspect "Bro" de la tech toujours à déplorer (cf l'UGC factory ou l'infiny talk de Wan).