Salut à tous les veilleurs saturés d’informations, les victimes de l’infobésité, les martyrs du FOMO (Fear Of Missing Out) et toutes celles et ceux qui essayent de rester à flot dans le torrent ininterrompu de news de l’IA Générative.

Ces derniers mois ont été intenses. Certains diront “hystériques”. Des news paraissent toutes les 48 heures, la veille est constante et épuisante.

Merci à Caroline Thireau pour son aide précieuse dans cette tâche chronophage.

Au sommaire cette semaine :

Des news et encore des news

“Karo fait des videos” : Test de la fonctionnalité vidéo sur Sezam.ai

Les vidéos pépites de la semaine

Les news de la semaine

🔹LA SAGA META

Depuis plusieurs semaines, la fête de la vidéo IA bat son plein. Les nouveaux outils se succèdent dans une course effrénée à la performance. Meta vient de se joindre à la fête en présentant Movie Gen, des modèles conçus pour la création vidéo et audio. Composé de Movie Gen Video pour générer et modifier des vidéos HD à partir de textes et de Movie Gen Audio pour produire des sons et musiques synchronisés aux vidéos, Movie Gen propose un teaser qui frappe tant par les fonctionnalités de l’outil que par la qualité et le réalisme des vidéos générées.

Aucune date de sortie n’a été communiquée.

Leo Kadieff est alllé de son petit comparatif entre Movie Gen, Kling et Gen-3 :

🔹WELCOME INTO THE FUTURE

Tome AI est une startup qui s’était fait connaitre en 2023 avec un outil de génération de slides presque aussi performant que ceux de ses concurrents directs Gamma.app et Decktopus. Tome semble avoir opéré un pivot et propose aujourd’hui un assistant vocales destiné aux équipes commerciales. Regardez la démo, qui ressemble à un épisode de Black Mirror. Par extrapolation, on peut aisément imaginer le même type d’assistant personnel IA, capable de nous aider tous les jours à nous organiser pour atteindre nos objectifs. Bienvenue dans le futur.

🔹NEW KID ON THE BLOCK !

Last minute, un nouvel outil open source de génération vidéo vient de sortir.

Il s’appelle “Pyramid Flow”; il fait du txt2vid et de l’img2vid, des vidéos de 5 et 10 secondes et la qualité semble plutôt très bonne :

Toutes les infos sur Hugging Face : https://huggingface.co/rain1011/pyramid-flow-sd3

🔹MINIMAX PASSE À LA CAISSE

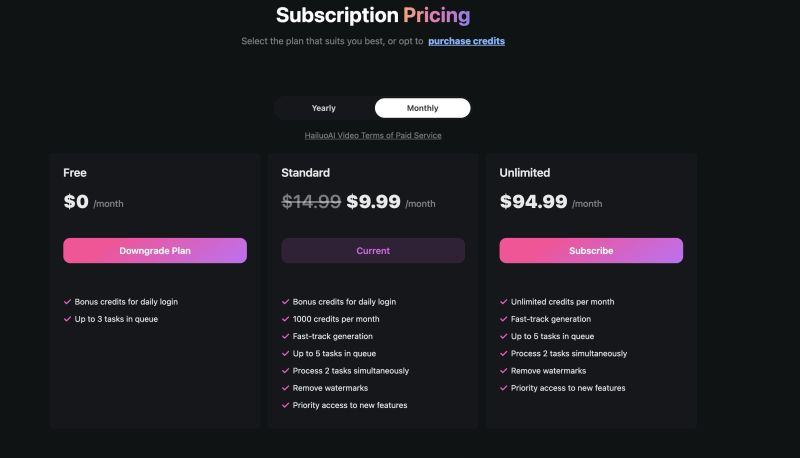

La fête est finie sur Hailuo AI Minimax. Le générateur de vidéo le plus excitant du moment devient payant. Il propose 2 offres très éloignées :

- une offre standard à 9.99$ qui permet 33 génération par mois.

- et une offre illimitée à 94.99$ par mois.

Une offre gratuite limitée demeure.

🔹 KREA CONTRE-ATTAQUE

Krea AI a récemment annoncé l'intégration des API de Gen3, Luma DreamMachine, Kling et Hailuo, disponibles dès maintenant en version beta pour ses abonnés. Cette initiative centralise les principaux outils de création vidéo au sein d'une seule interface, permettant ainsi aux utilisateurs de ne souscrire qu’un seul abonnement plutôt que 4. Et terminé de jongler entre plusieurs plateformes. Merci à Pierrick Chevallier pour la vidéo.

🔹META ORION GLASS & AI LIGHTNING

Combiner les lunettes AR Meta Orion et le mode video-to-video de Runway Gen3 permet de fusionner des éléments dans la réalité augmentée avec un rendu intéressant. Par exemple, les effets de lumière et les contrastes sont plus intenses, donnant une esthétique parfois surréaliste. C’est un peu comme augmenter la saturation des couleurs dans une photo, mais ici en direct, dans le champ de vision.

🔹LE BUREAU DES LÉGENDES DU FUTUR

Deux étudiants de Harvard ont montré comment les nouvelles fonctionnalités des lunettes connectées Ray-Ban de Meta peuvent poser des problèmes de vie privée. En détournant l'outil d'analyse de l'environnement, ils ont prouvé qu'il est facile de transformer ces lunettes en un dispositif d'espionnage . Reste à espérer que Meta travaille déjà sur ces failles. (Gen Z oblige, la video est évidemment en 9:16 !)

🔹APPLE VISION PRO & JOYSTICK

A l’heure du FacePoke, l'utilisateur de Reddit t_hou a préféré combiner ComfyUI avec l’Apple Vision Pro pour contrôler un avatar en réalité augmentée et en temps réel. La configuration permet de diriger les mouvements de l'avatar : le joystick gauche contrôle la tête, le droit les yeux, et les boutons gèrent les expressions faciales (clignements, sourires). Encore une fois, le combo IA et RA peut recréer la surprise !

🔹COPILOT fait peau neuve

Microsoft a dévoilé une nouvelle version de Copilot, son assistant IA intégré à Windows. Cette mise à jour introduit une interface repensée et de nouvelles fonctionnalités vocales et visuelles. Copilot Voice ambitionne de concurrence chatGPT voice, tandis que Copilot Vision analyse le contenu à l'écran. L'entreprise lance également Copilot Labs pour tester de nouvelles fonctionnalités. L'intégration avec Edge et l'introduction de Copilot Daily pour les actualités soulignent l'ambition de Microsoft de faire de Copilot un assistant quotidien polyvalent, tout en proposant une alternative crédible aux solutions OpenAI.

🔹FACEPOKE

FacePoke est un outil open-source de génération d'images faciales basé sur l'IA, disponible via deux démos sur Hugging Face. Il fonctionne principalement avec de vrais visages, permettant de modifier des images à partir de photos ou vidéos. La licence MIT permet aux utilisateurs de l'explorer librement. Extremement pratique lorsque vous générerez un visage qui vous plait, mais dont l’angle n’est pas EXACTEMENT celui que vous aviez en tête.

Petite démo sympathique de Jacques Alomo on LinkedIn:

Pour tester c’est par ici :

Git - https://lnkd.in/dmf9SFmd

Demo #1: https://huggingface.co/spaces/fffiloni/expression-editor

Demo #2: https://huggingface.co/spaces/jbilcke-hf/FacePoke

Code: https://github.com/jbilcke-hf/FacePoke

🔹 DES IMAGES ET DES CLÉS

Runway Gen-3 est désormais doté d’une nouvelle fonctionnalité de Keyframes (images clés) qui mérite d’être testée :

🔹L’HOMME INVISIBLE

Face à toutes ces questions sur la protection de la vie privée, des chercheurs de l'Université du Maryland ont créé un pull avec des motifs contradictoires capables de tromper les détecteurs de sécurité par IA et rendant la personne "invisible" en temps réel face aux algorithmes de reconnaissance. Une nouvelle version des pulls de noël ?

🔹MEMORY SHOTS

"Memory Shots" est un outil numérique conçu pour aider les patients atteints d'Alzheimer à recréer des souvenirs non photographiés en générant des images, favorisant les interactions. Développé avec la Fondation Recherche Alzheimer, Alzheimer Belgique et Baluchon Alzheimer, il s'intègre à "Réminiscence" pour être accessible aux centres de soins et aux familles.

Plus de détails ici : https://memory-shots.org/fr

🔹BORING AMATEUR

On vous parlait de technique pour redonner un grain retro aux générations videos, aujourd’hui c’est le modèle Flux 1.1 Pro qui nous permet de créer des images réalistes tout en imitant le style de photos "banales" ou "amateur"… Pour cela, il suffit d’ajouter des extensions de fichiers de caméra au prompt comme par exemple DSC_0076.JPG, IMG_2024.CR2, etc.) et l'outil s'inspire des photos amateures pour reproduire un style caractéristique de photos amateures : cadrage discutable, netteté moyenne, grain, etc…

D’une manière générale, cette astuce fonctionne mieux avec des prompts courts.

A gauche, un rendu caractéristique de Flux (trop saturé et trop lisse). A droite, une “photo” plus vraie que nature :

🔹WELCOME TO MY NEIGHBOURHOOD

Nous vous parlions tendance maison dans les précédentes éditions, elle semble suivre son cours… Une équipe spécialisée d’Archviz, blog spécialisé dans la 3D, a transformé un défi en opportunité en exploitant l'IA. Ils ont converti une capture d'écran SketchUp, outil de prédilection des architectes et décorateurs d’intérieur, en combinant ComfyUI, Stability AI et Magnific AI.

Le rendu détaillé ci-dessous a été obtenu en seulement quelques heures. Ils travaillent depuis sur le développement d’un outil public afin de générer facilement des images hyperréalistes à partir des modèles 3D en archi. De quoi se projeter plus rapidement pour les achats sur plan !

🔹LES VFX EN 2024

Martin Haerlin a utilisé un workflow qu’on apprécie beaucoup par ici, mêlant modèles de diffusion et montage pour remplacer une voiture dans une scène de Baby Driver. Il a collecté un dataset d'images de voitures, formé un modèle LoRa, puis a utilisé l'inpainting pour insérer l'objet dans les scènes clés avant d'animer les images pour les adapter au film original. C’est une méthode qui, potentiellement, pourrait éviter les coûteux reshoots et démocratiserait les effets visuels avancés grâce à l’IA générative, ouvrant la voie à de nouvelles solutions créatives dans la publicité.

🔹API RUNWAY

L’API Runway est ouverte à tous les développeurs depuis vendredi (Pour mémoire, une API (Application programming interface) est un programme permettant à deux applications distinctes de communiquer entre elles). L’objectif ? Nous permettre d’intégrer Gen-3 Alpha Turbo dans n’importe quel plateforme / environnement externe au site internet de Runway.

🔹ANTILATENCY

Au delà de son nom qui ne peut que nous séduire, ce studio à fond bleu utilise un éclairage dynamique en temps réel, synchronisé avec une scène virtuelle dans Unreal Engine 5.4, grâce au plugin CyberGaffer. Jamais la prévisualisation de séquence compositée n’avait été aussi réaliste.

Discord ici : https://lnkd.in/dwMqMZSH

🔹HUBSPOT HEYGEN BLOG 2 AI VID

HeyGen s'associe à HubSpot pour faciliter le marketing vidéo. Grâce à l'intégration Blog-to-AI Video, les articles publiés sur HubSpot sont automatiquement transformés en vidéos courtes avec un avatar de style influenceur. Aucune compétence en tournage ou montage n'est nécessaire. Cette fonctionnalité permet de générer rapidement du contenu vidéo attrayant à partir de simples articles de blog.

Perso, j’attends des avatars un peu plus “vivants” avant de commencer à m’exciter.

🔹LA THÉORIE DE L’EVOLUTION DES AVATARS

Synthesia nous rappelle le chemin parcouru…. En 2017, les avatars avaient des voix artificielles et des mouvements limités. Aujourd'hui, ils paraissent presque humains, avec des voix naturelles et des expressions réalistes. D'ici 2031, ils pourraient devenir indiscernables des humains, capables de percevoir les émotions et d'interagir de manière intuitive.

Avis de Gilles : je suis très partagé sur cette technologie. D’un côté je trouve ça spectaculaire et extraordinaire.

Et d’un autre, l’idée de regarder/écouter/interagir avec des humains de synthèse m’angoisse. Sur ces bonnes paroles, je vous laisse avec mes clones :

HeyGen a récemment publié des vidéos spectaculaires réalisées avec la technologie Avatar 3.0, qui nous emmènent un peu plus loin dans la “Vallée de l’étrange”.

🔹ANIM 2 VID

PJ Ace a recréé en live-action le trailer de Princesse Mononoké, reproduisant chaque plan avec précision. Ce projet a nécessité plus de 745 $ en crédits Kling, des milliers de générations via Midjourney, et de nombreuses heures de travail. Le trailer compte environ 50 plans vidéo, chacun ayant été généré plus de 50 fois pour obtenir la version parfaite.

Les internets sont partagés entre les fans et ceux qui crient au crime de lèse majesté, Miyazaki ayant publiquement manifesté son “dégoût” de l’intelligence artificielle.

🔹 KLING VOICES

Kling dote sa fonctionnalité lipsync de voix IA. Il ne sera désormais plus nécessaire de passer par Eleven Labs pour faire parler vos personnages.

🔹LEONARDO N’EST PAS MORT

Leonardo (qui s’est fait très discret ces derniers mois) dote son modèle Phoenix de nouvelles fonctions Style Reference (pour influencer le style généré) et l’Image-to-Image, offrant ainsi un contrôle créatif encore plus poussé. Des fonctionnalités déjà disponibles chez plusieurs concurrents. La société australienne a t-elle définitivement fermé sa cellule R&D depuis son rachat par Canva en juillet dernier ?

A tester ici : https://bit.ly/3zKv9Cy

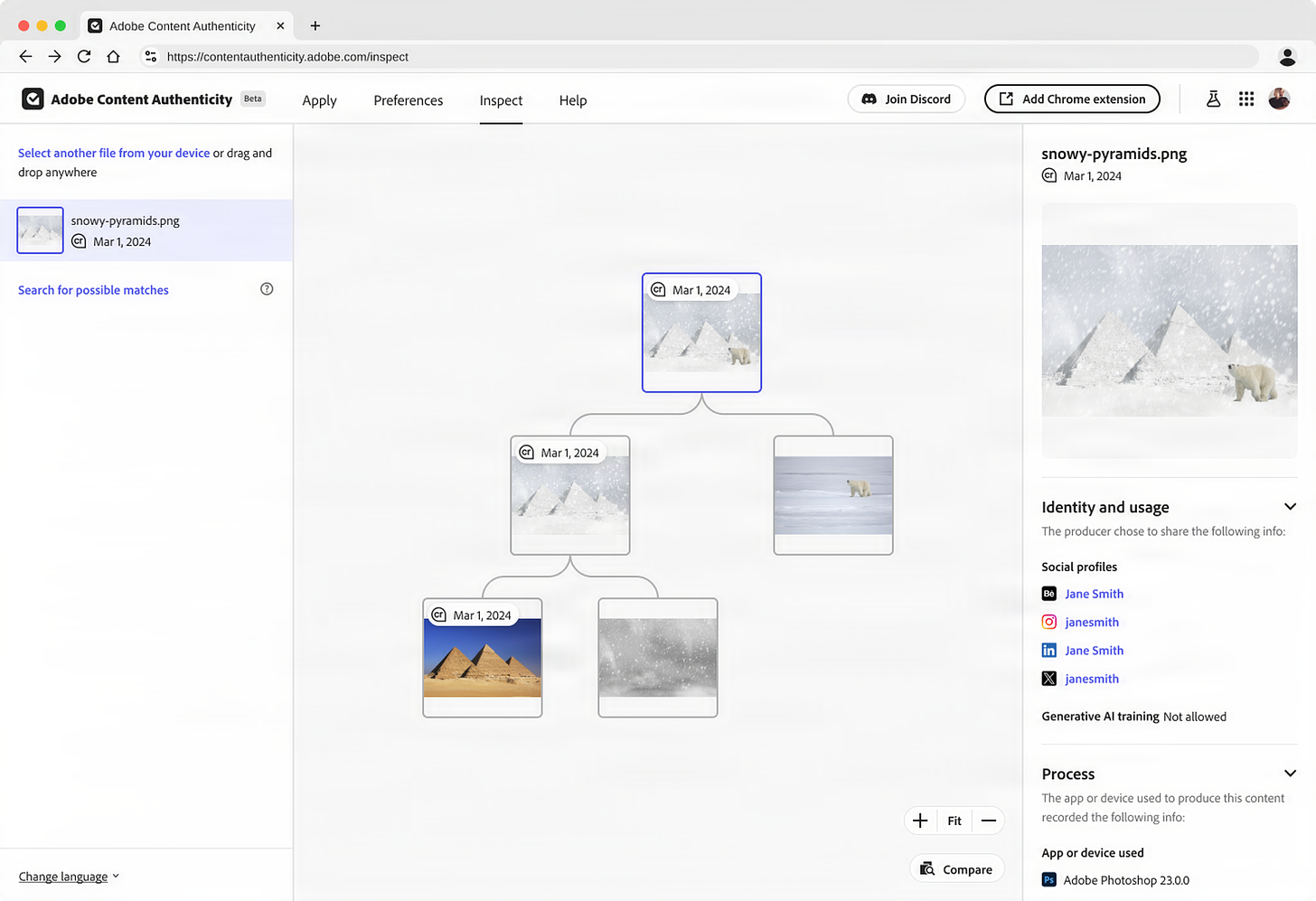

🔹ADOBE PROTECTION

Adobe lance “Adobe Content Authenticity”, permettant aux créateurs de protéger leurs œuvres numériques. Cette innovation utilise les Content Credentials, des métadonnées sécurisées fournissant des informations sur la création et l'édition du contenu.

Développée en collaboration avec la communauté créative, cette application répond aux préoccupations actuelles des créateurs concernant l'attribution et l'utilisation non autorisée de leurs œuvres.

🔹PAUL TRILLO is BACK

Le "Gaussian Splatting" est une technique en 3D qui utilise des points flous ("splats") pour représenter des objets. Ici, le réalisateur Paul Trillo a scanné 30 éléments dans son jardin et les a intégrés en 3D au logiciel After Effects. Cela permet de créer des effets visuels réalistes tout en réduisant le temps de calcul nécessaire.

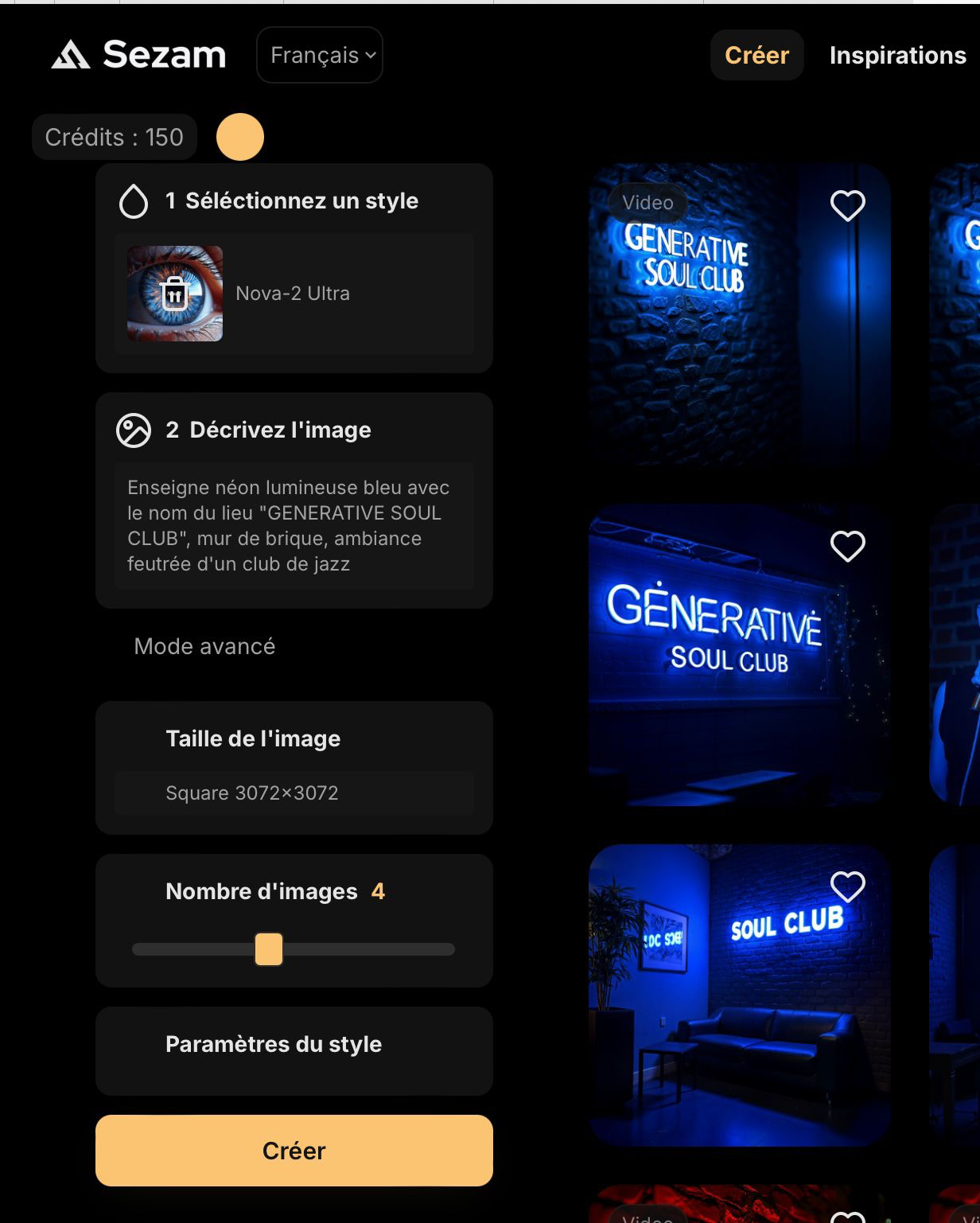

🔹KARO FAIT DES VIDEOS

La plateforme française Sezam a sorti jeudi une nouvelle fonctionnalité Image to video. Une bonne occasion de tester la méthode chill du co-fondateur Aurélien Gomez à savoir “depuis mon canapé, en moins de 2 heures, avec les images du modèle Nova-2 Ultra de Sezam”.

Bienvenue au Generative Soul Club !

Voici le workflow pour cette ambiance concert intimiste propice aux tests.

1- Génération d’images avec Nova-2 Ultra :

Ce modèle issu de Flux permet un rendu de qualité sur les lumières, le grain et les contrastes, comme on peut le voir sur les portraits

Excellente adhérence aux prompts, comme on peut le voir sur les néons

Petite remarque : vous avez le choix du nombre de générations dans le menu “mode avancé” (1 à 8 images), ce que mon ipad m’avait caché sur les 1ers tests !

2 - Génération video en 1 clic via une nouvelle icône "Play" en bas des images générées sur Sezam

Possibilité de lancer plusieurs générations en parallèle

Stabilité des plans et cohérence des mouvements

Possibilité d’exporter en 16:9 ou 9:16 en fonction du format de l’image initiale

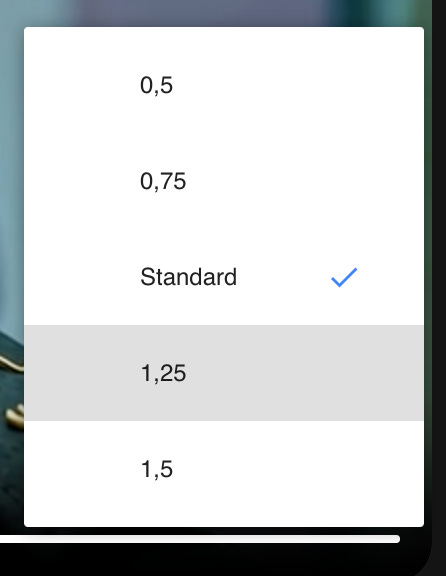

Astuce : sur les premières générations, j’avais le sentiment que c’était un peu le retour du slow motion, comme à la grande époque de Runway Gen-2. Parfait pour ce type de projet mais pas adapté à tous les besoins. En creusant, il est possible d’ajuster la vitesse de lecture du lecteur en cliquant sur l’icône “…”. Cela permet de prévisualiser le rendu au ralenti ou en accéléré (de x0,5 à x2) pour anticiper le montage, sans affecter la vitesse ni la qualité de la vidéo téléchargée. Une fonctionnalité bien utille.

3 - Bande son avec Udio

Je reste fidèle à Udio, qui me permet d'obtenir rapidement un bon résultat avec peu d'itérations, et des voix assez quali. Les prompts courts avec sélection rapide d’un style (en un clic) offrent souvent de bonnes surprises.

Les conditions d'enregistrement (studio, concert, live, …) peuvent aussi influencer les deux versions générées à chaque fois par l'outil.

Ici, j’ai aussi demandé la génération automatique du texte avec ce prompt pour coller au décor : “New Soul Concert, Soul, Live.”

4 - Montage avec Capcut

Rapide et efficace même en version gratuite. Voici le résultat final :

A ce stade pour Sezam.Ai, pas de prompt requis pour lancer la génération vidéo. On attend de voir la suite de ce qui sera proposé : + de contrôle, des keyframes, de l’extend ? Une chose est sûre, on va continuer à suivre ça de près avec Gilles. To be continued !

Les pépites de la semaine

Les pépites de la semaine sont les courts métrages IA des camarades Matthieu Grambert, Stéphane Galienni et Marc Horgues.

Ces films ont été réalisés dans le cadre de l'Artefact AI Film Festival, organisé par Artefact et mk2. Ce festival, présidé par Jean-Pierre Jeunet, invite les réalisateurs à explorer la créativité via l'IA avec des courts métrages de 314 secondes. Le public pourra voter, et les gagnants recevront jusqu'à 10 000 € lors de la cérémonie en novembre 2024 à Paris.

A vos votes sur le site du festival : https://artefact-ai-film-festival.com/

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇

Best synthèse as usual mais déprimant quand je vois tout ce que je dois encore tester ce weekend !