Salut les mutants, les cyborgs et les androïdes augmentés par l’IA, bienvenue dans cette nouvelle édition de GENERATIVE.

Cette semaine on vous parle essentiellement de vidéo avec HEYGEN et de son “avatar IV”, de Runway Gen-4, de Higgsfield, etc, etc, etc…

La liste est aussi longue que d’habitude.

Mais pas de stress, ça va bien se passer : let’s go !

P.S. J'animerai une prochaine session de formation en CPF les 19 et 20 juin prochains. Les inscriptions sont déjà ouvertes ici.

🔹 HeyGen Avatar IV – Vidéo IA pilotée par la voix

HeyGen lance Avatar IV, une fonctionnalité qui permet de transformer une simple photo en vidéo animée jusqu’à 30 secondes, synchronisée non seulement aux mots, mais aussi au ton, au rythme et à l’émotion de la voix.

LA THÉORIE : Le moteur analyse les nuances vocales pour générer des expressions réalistes : micro-expressions, pauses, inclinaisons de tête. Résultat : un rendu naturel et fluide, plus proche d’une vraie performance que d’un simple doublage animé.

LA PRATIQUE : le résultat dépend beaucoup de la photo d’origine. Ainsi, Avatar IV aura plus de mal à égayer un visage fermé qu’un visage souriant :

Mercredi dernier, je suis intervenu dans IAGora, un rdv hebdomadaire en visio créé par François Deliac de l’IMA, pour suivre l’actu de l’IA, avec Yann Carbonne et Marjory Canonne. A cette occasion, j’avais créé un avatar de Yann à partir d’une photo où il souriait. Le résultat était plus probant qu’à partir de mes photos :

🔹 Higgsfield – Effets VFX

Higgsfield, dont on vous parle depuis 2 semaines, propose maintenant un pack de 23 effets visuels intégrés (feu, métal, invisibilité…). Des effets dignes d’un studio VFX générés en un prompt, sans montage. Exemple : “Agent Reveal”, qui transforme une identité comme dans Matrix, pour 9 $ mensuel seulement (Note de Caro : attention, les crédits partent très vite !).

Un outil qui permet des rendus spectaculaires, rapides et accessibles à tous sans compétences techniques avancées comme sur la démo ci-dessous. . A tester d’urgence si ce n’est pas déjà fait !

🔹 Runway Gen-4 References & Intégration d’assets 3D

Runway Gen-4 permet d’intégrer des modèles 3D dans des scènes générées à partir de seulement 3 images : un décor, une composition rapide avec l’objet 3D et une référence de style. Pas besoin de rigging ou de rendu complexe. L’outil positionne les objets comme voulu, tout en conservant cohérence et style, donc plutôt utile pour produire des visuels sur-mesure avec contrôle total.

En plus, c’est accessible en plan sans abonnement depuis mercredi !

🔹 LTX Video 13B

LTX Video de Lightricks passe un nouveau cap avec sa version 13B : rendu + rapide, meilleure qualité et toujours en open source. Le modèle propose un bon rendu, mais un peu inférieur (moins naturel) aux meilleurs du marché, avec un temps de génération assez court. Des outils comme le contrôle caméra, les images clés “key frames” ou les expressions faciales sont intégrés pour affiner la production. A tester par ici : bit.ly/ltxvalex.

Ici une video de Alex Patrascu :

LTXV 13B permet également entrainement de LoRA vidéo. Le camarade Neb Sh, membre du Prompt Club, en a entrainé plus de 29, qu’il met à disposition ici : https://huggingface.co/melmass/ltxv-loras

🔹 SkyReels V2 – Génération vidéo IA open-source et illimitée

SkyReels V2 sur Huggingface ou Github, est l’évolution du modèle open source Skyreels. qui permet de créer des vidéos jusqu’à 30 secondes à partir de texte ou d’images. Le pipeline va du script au montage final, avec des effets personnalisables et des mouvements de caméra.

C’est gratuit en version open source mais nécessite par contre une carte graphique avec 15 Go de VRAM.

Accessible également en version payante via le site web ici : skyreels.ai/h5.

🔹 Krea AI – Nouveaux outils image et vidéo intégrés

Depuis la semaine dernière, Krea AI propose désormais des presets GPT intégrés dans son module image pour créer des visuels variés : figurines réalistes à partir d’un portrait, logos en 3D ou strips BD en combinant plusieurs images.

Côté vidéo, la version Wan 2.1 permet d’utiliser une image de départ et une de fin pour générer une séquence animée entre les deux. L’outil combine textes, images et paramètres visuels dans une interface simplifiée, sans passer par des logiciels de montage.

Krea propose également un upscaler vidéo qui permet de “gonfler” vos vidéos jusqu’à

8K et 120 ips à l’aide de Topaz Labs dans Krea.

🔹 Electric Sheep – un éditeur vidéo IA agentique ?

Electric Sheep débarque avec une promesse qu’on attend depuis longtemps : un éditeur vidéo basé sur l'IA. En clair, un logiciel à qui l’on prompterait le montage que l’on souhaiterait réaliser. En 2 mots : du “Vibe Editing”.

La démo est très impressionnante, comme souvent avec les startups IA.

Nous, on attend de voir pour le croire.

Inscription sur la waitlist sur leur site.

🔹 Whisk Animate + Veo 2 – Animation par Google

Google propose une nouvelle fonction pour des animations video de 8 secondes en un seul clic, en combinant Whisk Animate et Veo 2 (réservé aux abonnés Google One AI Premium).

🔹 Pimento – Nouveaux styles, redimensionnement intelligent et rendu photo-réaliste

Pimento ajoute 10 styles visuels, du flou studio aux textures holographiques, adaptés à différents usages (mode, produit, nature…). Un nouvel outil de redimensionnement ajuste automatiquement les visuels à tous les formats (bannière, post, story), sans perdre en qualité. Le moteur de génération de personnages a aussi été amélioré : plus de réalisme, meilleure lumière, et détails affinés.

Bonus : il est possible d’entraîner un style visuel à partir de son compte Instagram pour produire du contenu cohérent à grande échelle.

🔹 Leonardo.Ai – Vidéo 720p avec Motion 2.0

Leonardo.Ai propose désormais la génération vidéo en 720p via Motion 2.0, à partir d’un texte ou d’une image. La version 480p est aussi + rapide et passe de 250 à 200 tokens. Le mode 720p permet un rendu + détaillé, avec contrôle du mouvement et image de départ pour une animation + précise.

De nouvelles features semblent à venir sur la suite, on garde l’oeil à Generative.

🔹 Freepik AI – Assistant IA avec flux de travail guidés

Freepik intègre désormais des « flux de travail » dans son Assistant IA, combinant GPT-4o et les différentes fonctionnalités de sa suite. On choisit un modèle (merchandising, déco, séance photo produit), puis on interagit étape par étape pour générer des visuels adaptés. Ce système simplifie la création de contenus visuels cohérents, sans avoir à maîtriser plusieurs outils séparés. Accessible depuis la Freepik AI Suite.

🔹 CAST – Reconstruction 3D à partir d’une image

CAST permet de recréer une scène 3D réaliste à partir d’une seule image. La méthode isole chaque objet, les reconstruit en 3D, puis les place dans l’espace en respectant la physique et les relations spatiales, grâce à un modèle de type GPT. Utile pour les jeux vidéo, la VR, l’architecture ou la robotique, sans avoir besoin de scanner la scène sous plusieurs angles. Code pas encore disponible mais détails par ici : CAST.

🔹 IntelliPrompt sur ComfyUI

Pour ceux qui préfèrent travailler en local, IntelliPrompt est un nouveau module pour ComfyUI qui utilise GPT-4o pour analyser des images de référence et générer des descriptions textuelles détaillées. Il permet de créer des prompts précis pour la génération d’images IA, avec des niveaux de détail ajustables et la possibilité de gérer plusieurs images avec des rôles spécifiques.

Possibilité de joindre la Waitlist par ici : intelliprompt.

🔹 OpenMagic AI – Montage vidéo 3D simplifié

OpenMagic AI permet d’intégrer facilement des éléments 3D réalistes dans des vidéos en mouvement. On peut y insérer une vidéo, transformer une photo en 3D ou importer un objet 3D tout en conservant sa qualité et son niveau de détail (texte et logo par exemple).

Relayé et testé par Eugenio Fierro, il est possible de s’inscrire sur omagic.ai, moyennant un billet d’entrée un peu élevé, sans option freemium.

🔹 ChatGPT : Un moodboard visuel en quelques minutes

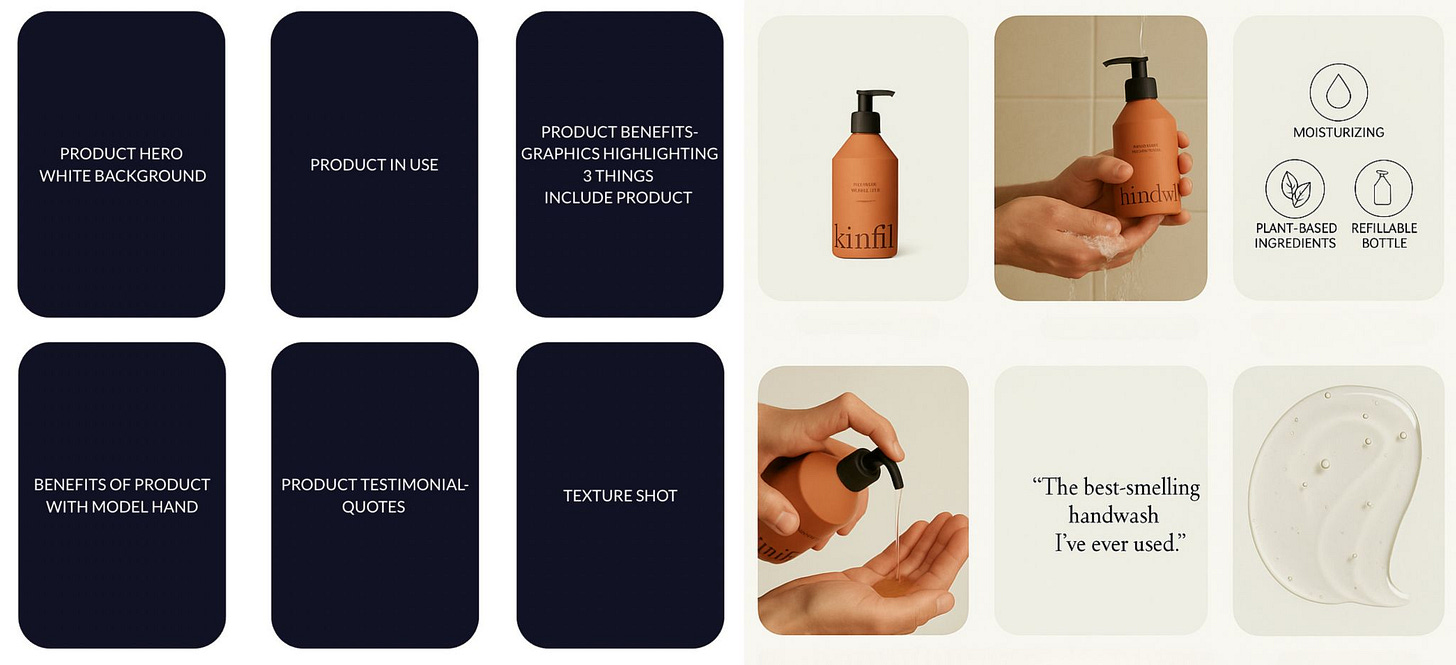

On n’y pense pas toujours, mais il est également possible de créer un moodboard directement dans ChatGPT : on glisse un visuel produit, on ajoute un template préconfiguré et on demande une grille d’aperçu. Cela permet de visualiser l’agencement d’un feed ou d’une campagne avant de produire les images finales. Une bonne idée de Salma Aboukar.

🔹 MEMEDECK – Création de personnages IA en image et vidéo

Memedeck est une nouvelle plateforme à venir qui proposera de créer des vidéos en partant d’un personnage personnalisé : on définira d’abord son nom et son apparence, puis on ajoutera des descriptions pour créer une bibliothèque. L’IA génèrera ensuite des visuels dans différents styles (3D, cinématique, analogique, animé…). Le personnage pourra ensuite être animé dans divers contextes, sur des scènes dont on choisira la durée. A tester à la sortie ! En attendant, voici un petit peu de teasing !

🔹 ElevenLabs – Doublage multilingue pour séries en streaming

La plateforme Gaia utilise ElevenLabs pour doubler ses séries dans d'autres langues. Résultat : une réduction de 25 % du temps de production et de 10 % (seulement ?) des coûts. Après les bandes-annonces, ils traduisent maintenant des séries entières en espagnol et en allemand.

Le résultat est pas mal mais devrait bientôt évoluer vers un lipsync plus “propre”.

🔹 Tencent HunyuanCustom

Tencent lance HunyuanCustom, un modèle open source capable de générer des vidéos à partir de texte, image, audio ou vidéo. Il intègre plusieurs modules pour combiner ces sources et maintenir la cohérence visuelle du visage tout au long de la séquence. La synchronisation labiale est améliorée, notamment pour les vidéos avec voix. L’outil vise les cas d’usage comme les avatars ou les deepfakes. Il reste dépendant de la qualité des entrées et nécessite des ressources importantes pour fonctionner.

🔹 NINJA PUNK

Le réalisateur et producteur américain Dave Clark a publié le teaser d’un long métrage IA intitulé “NinjaPunk”, qu’il ambitionne de produire (et co-réaliser) avec sa société de production Promise .

Situé à Los Angeles en 2065, NinjaPunk met en scène des décors urbains générés en 3D et par intelligence artificielle, des personnages créés par IA, ainsi que des performances d’acteurs et de cascadeurs réels, intégrées dans des environnements de pointe mêlant IA et apprentissage automatique.

Se positionnant comme un “State of The Art” de la réalisation cinématographique augmentée par l’IA, cette bande annonce nous laisse mi-figue mi-raisin, à la croisée des chemins entre une animatique de Playstation et le souvenir lointain d’ovnis filmiques dopés aux CGI, tels le japonais “Casshern” (2004).

(Grosse scène d’action autour de 57mn)

Plus d’infos sur leur blog.

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également vous abonner à la chaine Youtube, TikTok, me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇

Mon plaisir du weekend 🤗

Merci pour ces news 😁