Festival Midjourney !

Salut les survivors, cette semaine a encore été… (insère ici un superlatif que je n’ai pas déjà utilisé 7 fois depuis 2023).

La vidéo est désormais disponible pour tous dans Midjourney et ça, c’est quelque chose.

Cependant, je suis frustré ce mois-ci, j’ai énormément de travail.

La conséquence, c’est que je n’ai pas assez de temps pour tout tester comme je le voudrais. C’est contrariant.

Néanmoins, nous faisons le max avec Caro pour vous donner un aperçu exhaustif de ce qu’il ne fallait pas rater cette semaine.

Sans plus attendre…

————————————————————————————————————————————

Si ce n'est pas déjà fait, tu peux aussi :

Découvrir mes formations IA pour les créateurs, 100% finançables par le CPF. Les inscriptions se font ici et la prochaine session aura leu en septembre 2025.

Former tes équipes à l'IA générative grâce à mes formations entreprise finançables par ton OPCO

Me contacter directement pour discuter de ton projet IA générative

Me suivre sur LinkedIn, YouTube ou TikTok pour ne rien rater.

Et c'est parti ! 🚀

🔹 MIDJOURNEY VIDEO

C’est officiel, le modèle vidéo est disponible pour tous les utilisateurs Midjourney.

Après avoir généré une image, il est possible de l’animer en une vidéo de 5 secondes (480p, 24 fps), avec option d’extension jusqu’à 21 secondes. Le rendu est plutôt rapide, le style visuel reste constant et les mouvements sont fluides. L’interface propose un prompt soit automatique, soit en manuel.

Le coût annoncé est de seulement 8x celui de la génération images. Impressionnant.

Pour démarrer, on vous propose un bout à bout de quelques plans générés par Gilles :

Midjourney video nous surprend par la qualité de sa cohérence spatiale. Dans certains cas de figure, il semble très proche de ce que peut proposer Kling, même si quelques petites étrangetés subsistent parfois. Nous pensons qu’il est globalement supérieur à Gen-4 en animation, ce qui constitue une incroyable performance en soi, pour un modèle nouveau né.

Il semble égaleent faire merveille dans le domaine de l’animation. Certains membres du Prompt Club ne s’y sont pas trompés, tels Warren Grange :

L’image semble reconstituée en 3D, avec une profondeur qui donne l’impression d’entrer dans la scène. Une approche cohérente avec l’ambition de Midjourney créer des “espaces virtuels”, au-delà des images fixes.

Nous saluons les équipes de Midjourney d’avoir réussi leur coup. Ils étaient particulièrement attendus au tournant. Et quand on sait que l’outil crée en 2022 par David Holz a toujours capitalisé sur le feedback des utilisateurs et l’amélioration continue, on peut présager que le modèle va continuer à s’affiner au fil des prochains jours/semaines.

On poursuit avec cette démo de l’incontournable Rory Flynn :

Phénomène intéressant, la résolution de vos vidéos n’est pas la même selon que vous le téléchargiez classiquement (“Download”) ou bien pour les réseaux sociaux (“Download for Social”). Ça permet de passer de 480p à 1080p, soit un gap de résolution spectaculaire !

On vous montre ici avec les essais issus des crashtests de Caro :

🔹 SREF V7 MIDJOURNEY

Eclipsé par la vidéo, le “Style Référence” V7 a également fait sont entrée cette semaine. Pour rappel, le “—Sref” pour les intimes, permet d’appliquer un style visuel de référence aux images générées. Avec un gain très fort en cohérence visuelle, en limitant la parfois trop grande créativité de Midjourney et en améliorant la cohérence des moodboards. Combiné à la video, cela permet un contrôle artistique fort comme dans cet exemple d’Arminas Valunas ici :

🔹 HAILUO MINIMAX 2

Après une très longue attente (leur premier modèle datait de l’étét 2024) MiniMax lance Hailuo 02, un générateur vidéo IA 1080p, plutôt performant, même si la concurrence est de plus en plus sauvage. Il montre un gain de qualité net comparé à la version précédente et reste économique avec environ 0,44 $ pour 6 sec en HD.

Un modèle très performant même si nous continuons de lui préférer Kling 2.1.

On vous partage cette démo de Arunag Tiwari qui vaut le détour :

➜ Et qui l’a déjà intégré cette semaine ?

Weavy AI, Freepik, Krea AI… pour les premiers !

🔹 HIGGSFIELD CANVAS

Higgsfield Canvas permet de sélectionner des objets directement dans une image grâce à de l’inpaiting accompagné de prompt, le tout pour un contrôle pixel-perfect. Dans les faits, c’est moins précis qu’un Flux Kontext sur des images complexes. Mais on sent une volonté chez Higgsfield de se positionner en tant que nouvelle référence pour le placement de produit !

De nouveaux motion controls arrivent aussi en cette fin de semaine :

Duplication - Tempête de sable – Congélation – Diamant – Roll Transition.

Gilles pense souvent qu’on est plusieurs de mon côté… La preuve en images !

🔹 FLORA & VFX

Flora propose aussi de générer des effets spéciaux directement depuis un navigateur, sans passer par un logiciel 3D. Il est maintenant possible de produire, corriger et étalonner les effets pour obtenir un rendu réaliste. Il semblerait que Higgsfield ou House of David aient fait des émules… Leur démo ici :

🔹 KREA 1 ouvert à tous

On vous présentait Krea 1 avec ses caractéristiques la semaine dernière. Développé avec Black Forest Labs (Flux), ce modèle de génération image maison de Krea AI est enfin accessible gratuitement à tous. Dans ses atouts, une excellente résolution et la possibilité d’entraînements personnalisés (jusqu’à 50 images).

🔹 LUMA - Modify Video

Le réalisateur Jon Finger qui a récemment rejoint les équipes de Luma nous propose la démo ici grâce à l’outil "modify video" qui permet d’agir directement sur les objets filmés sans avoir recours à des logiciels de VFX. On ne sait pas ce qui est le plus intéressant à partager ici, la techno qu’on vous avait déjà partager dans une précédente édition ou bien la créativité avec laquelle Jon se réinvente sans cesse. Enjoy !

🔹 SEEDANCE – Le contender

Seedance 1.0, dévoilé par ByteDance, est un nouveau générateur vidéo IA capable de produire des séquences jusqu’à 1080p à 24 fps qui prend la tête des modèles vidéo sur le discutable leaderboard d’Artificial Analysis.

➜ Et qui l’a déjà intégré cette semaine ?

• Il est disponible via WaveSpeedAI et coûte 0,6$ pour 5 secondes de video HD ;

• Sur Fal.ai, dispo en version “Lite” seulement à 720p max. pour 0,18$ ;

• Côté Saas, les versions “Pro” & “Lite” sont toutes les 2 accessibles sur Weavy AI depuis ce matin ainsi que chez Krea AI en 10 fois moins cher que Veo 3.

A bon entendeur, à vos paypals !

🔹 Veo3 x ASMR

Bien que la fonction ASMR ne soit pas encore accessible au public (NDLR : on l’aurait plutôt attendue chez Pika ou Higgsfield), la vidéo TikTok Impossible ASMR met en avant une capacité de Veo 3 : générer du son synchronisé avec l’image. Voilà de quoi rendre les contenus IA plus immersifs, multisensoriels… et viraux.

🔹 WEAVY COMPOSITOR NODE

Le Compositor Node de Weavy est un outil pour gérer la mise en page, les polices et les couleurs directement dans un projet IA. Cela évite d’exporter vers un logiciel tiers et accélère les workflows visuels. Et la plateforme continue à grossir cette semaine avec l’arrivée de Mystic v2.5, de Magnific AI ainsi que du très récent Minimax Hailuo-02. A suivre comme on vous le disait déjà il y a 2 semaines !

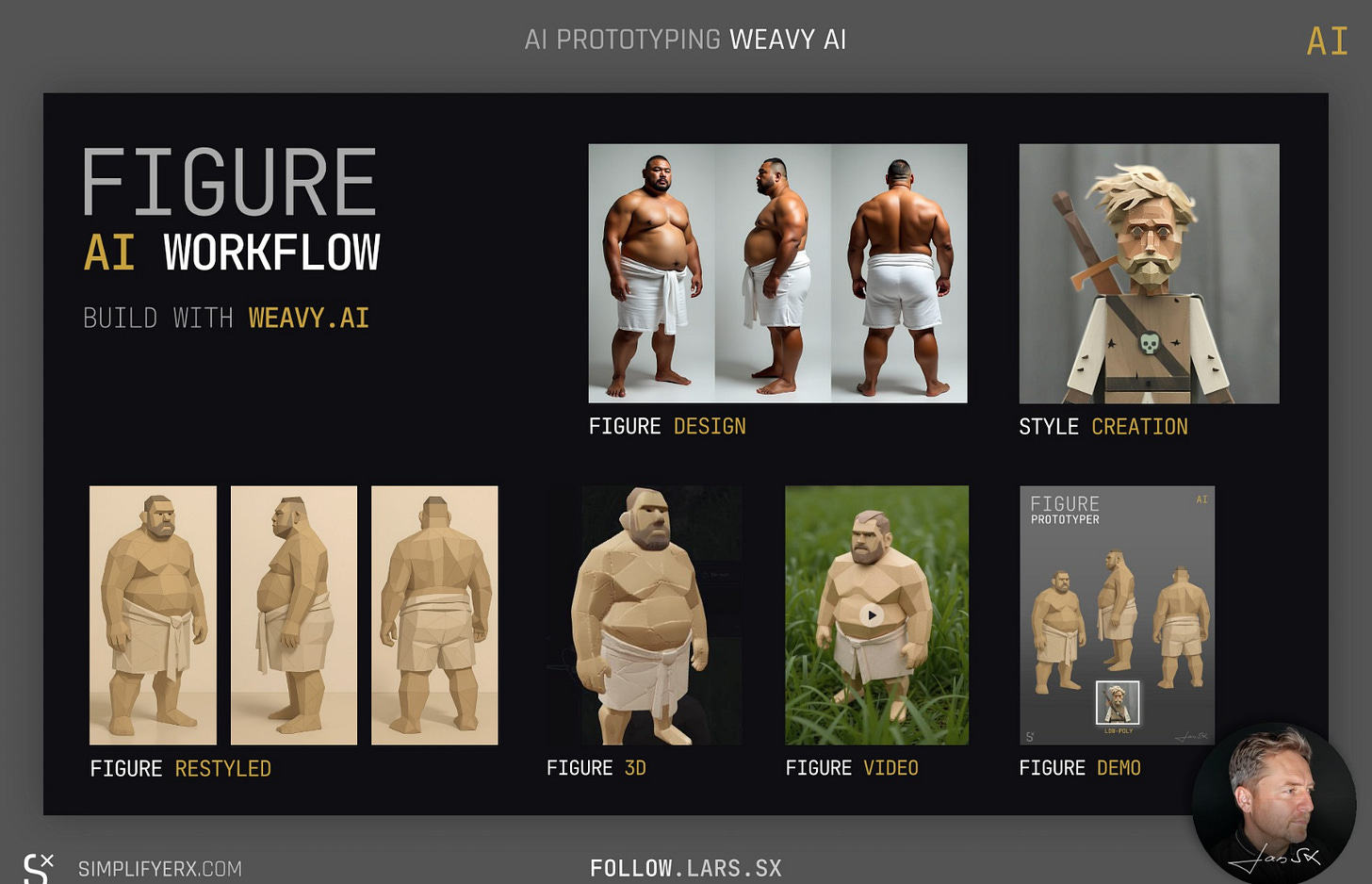

Ici un projet expérimental de Lars Richter où il assemble des modules 3D, vidéo et de style via des prompts JSON pour prototyper rapidement des personnages multi-vues en automatisant les tâches techniques.

🔹 COMFY SPLINE CONTROL

Cet outil open source aide à contrôler précisément la trajectoire d’un objet animé dans une vidéo Wan2.1 VACE, via Spline-Control-Path, c’est à dire avec une série de points clés dans l’espace 2D et 3D. Cette fonction, absente de nombreuses plateformes actuelles, permet de contrôler le mouvement de la caméra, des objets, des sujets, etc avec énormément de précision. Nous, l’outil nous semble encore un peu compliqué à maîtriser.

🔹 WAN VACE OUTPAINTING

Phu Ngo présente un workflow d’expansion vidéo baptisé Wan VACE Outpainting qui a pour objectif d’étendre visuellement une scène générée pour créer des travellings ou élargir des plans sans avoir besoin de filmer.

🔹 ComfyUI au rythme de la musique

Encore en test, le processus partagé par Lovis Odin permet de créer des vidéos hommage via ComfyUI. Il génère d’abord des images avec Flux et Kontext, puis les assemble avec Framepack. Son programme LLM analyse le clip et réalise un montage complet synchronisé au BPM avec Gemini. A tester par ici.

🔹 FINEGRAIN x LOVABLE x Vibe Coding

Lovable s’utilise maintenant avec l’API Finegrain pour créer en quelques heures une app de retouche photo avancée. Le tout est piloté uniquement par prompts et sans coder. Vibe coding in full effect.

🔹 Lovart AI – Intégration de Kling 2.1 pour la vidéo IA

Lovart, plutôt orienté création graphique et dont on vous parlait dans l’édition de mai dernier, passe à la video avec Kling AI comme partenaire officiel, désormais accessible directement sur la plateforme.

🔶 Dossier FLUX KONTEXT de Caro

➜ L’AI Assistant de FREEPIK

Depuis quelques semaines, Freepik propose Flux.1 Kontext à travers son AI assistant (dispo en haut de votre écran), pour transférer des textures sur des objets avec un contrôle précis des style et des matériaux. Cela permet de styliser logos, produits ou mockups sans y passer des heures. J’ai décliné notre mascotte pour illustrer :

Ce qui n’est pas sans nous rappeler…

➜ Le FIREFLY BOARDS beta

… Dont on parlait dans une précédente édition et qui vient tout juste d’être ouvert au public cette semaine ! Les modèles comme Flux 1.1 Pro, Ultra et Ultra (Raw) ne sont testables qu’une seule fois sans abonnement. Ensuite, l’accès démarre à 11 €/mois, sauf pour Firefly Image 3.

Parmi les autres partenaires disponibles : Imagen 3 et 4 (preview), Ideogram 3.0 et Runway Gen‑4 Image. A tester ici : Firefly Boards.

A vous de voir où vous souhaitez mettre votre abonnement en fonction de vos usages et préférences ! Pour ceux qui ont le Creative Cloud, dommage que l’accès n’inclut pas l’ensemble des modèles dans Firefly Boards.

🔹 Comparatif de la semaine : Midjourney Video, Seedance, Kling et MiniMax

Pour clôturer la semaine, Jan-Willem Blom nous propose ce comparatif des 4 modèles vidéo les plus récents (sorties que vous avez suivi avec GENERATIVE bien sûr !). Il utilise la même scène d’un skateur pour comparer les performances entre les modèles, le suivi caméra et l’interaction avec l’environnement. Résultats :

• Midjourney Video 1.0 : pas mal, manque de définition, certains incohérences

• Seedance 1.0 : très fluide mais très lent. Manque de dynamique.

• Kling 2.1 : très dynamique, très réaliste dans les mouvements

• MiniMax 2.0 : très dynamique, de bonnes interactions avec le décor

Lequel préférez vous ?

🔹 GOOGLE DEEPMIND

Le projet “The Space Between Us” de Google DeepMind explore les liens entre mémoire et espace en combiannt Veo 3 et Gemini 2.5 Pro :

🔹 DOUCEUR VIDEO IA

Ce film d’animation de Davide Bianca, conçu et animé avec Midjourney v7, puis upscalé avec Topaz Astra donne un avant goût du potentiel de Midjourney vidéo dans le domaine de l’animation.

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇