Encore des histoires de clones et de contrôle

Salut les enthousiastes, les passionnés et les curieux, bienvenue dans cette nouvelle édition de GENERATIVE, la newsletter hebdomadaire qui décortique l’actualité de l’IA générative, vous présente des outils créatifs et des personnes qui utilisent l’IA de manière inspirante.

Sans plus tarder, le sommaire

✔️ Les news de la semaine

✔️ Midjourney, Viggle et moi : une production techno-intimiste

✔️ L’interview de l’artiste IA Joris Bacquet

Les news de la semaine

VAS-Y VASA

Microsoft Research a dévoilé VASA-1, une IA capable d'animer des portraits avec réalisme à partir d'enregistrements sonores. Dotée d'une synchronisation labiale précise, elle génère des expressions faciales réalistes et des mouvements de tête en temps réel. Pour éviter les risques de deepfake, les chercheurs ne prévoient pas de rendre la technologie publique tant qu'elle n'est pas utilisée de manière responsable et conforme à la réglementation. Vous y croyez vous ?

J’imagine déjà l’implémentation dans teams où votre photo de profil va s’animer et vous remplacer à la visio du vendredi à 19h30.

Singularité is coming ?

Dans une interview dans le NY Times, le cofondateur de Mistral AI exprime ses doutes sur la réalisation prochaine de la singularité technologique (un événement théorique où l'intelligence artificielle surpasserait toutes les capacités humaines).

Au lieu de cela, il identifie une menace plus immédiate et réaliste : la montée en puissance des modèles d'intelligence artificielle, comme ceux développés par OpenAI et Google DeepMind, pourrait induire une dépendance excessive à ces technologies. Selon lui, cette dépendance pourrait mener à une vulnérabilité sociale et économique, rendant la société dépendante de systèmes qui pourraient être manipulés ou défaillants. Une analyse très intéressante si vous voulez mon avis.

Stable Diffusion 3 déçoit

Stable Diffusion 3 a été lancée avec des avis partagés. Disponible uniquement sur une plateforme développeur et payante (de quoi faire jaser les fervents de l’open source). Malheureusement, la qualité des images déçoit, et semble parfois inférieure à celle du modèle SDXL précédent. Malgré une meilleure gestion du langage dans les prompts et la prise en charge de typographies, cette version ne semble pas répondre pas aux attentes élevées et manque d'améliorations significatives.

Nihongo o hanasemasu ?

OpenAI étend sa présence globale en ouvrant un bureau à Tokyo, ce qui marque sa première installation en Asie et la quatrième au monde. Cette expansion accompagne le lancement d'un modèle GPT-4 optimisé pour le japonais, visant à améliorer les performances linguistiques et culturelles, notamment dans des contextes professionnels. Le Japon, présidant l'initiative Hiroshima AI Process du G7 pour promouvoir la sécurité de l'IA, est stratégique pour OpenAI qui y compte déjà des clients comme Daikin, Rakuten, et Toyota. Tadao Nagasaki, ancien d'Amazon Web Services, dirigera le nouveau bureau.

Auto-Automobile

Alors que Waymo, Cruise et Zoox élargissent les services de leurs flottes de véhicules autonomes, tous les regards se tournent vers Tesla, qui prévoit de lancer son service de taxi autonome en août 2024. Cette initiative est très attendue, car elle pourrait transformer la dynamique des transports urbains en intégrant la réputation d'innovation de Tesla dans le domaine des véhicules électriques.

Bientôt de l’IA dans Premiere

Le buzz de cette semaine, c’est Adobe qui a annoncé que Premiere Pro (montage video) intégrera bientôt des fonctionnalités d’IA générative. Les nouvelles fonctionnalités comprendront la possibilité d'ajouter ou de supprimer des objets (inpainting et outpainting) d'étendre des clips et de créer des séquences personnalisées à partir de zéro.

Mais ce qui a fait jaser les internets, c’est quand Adobe a annoncé l’intégration de modèles d'autres fournisseurs tels que OpenAI (Sora !), Pika et Runway.

Comme d’habitude depuis février, la conclusion tient en 3 mots : “Qui vivra Sora”.

F.I.A.

Neural Concept est une startup spécialisée en IA qui a développé un logiciel de simulation aérodynamique désormais utilisé par quatre équipes de Formule 1 dont Williams. Leur logiciel applique l'apprentissage automatique pour proposer rapidement des améliorations de design aux véhicules de course, aidant les ingénieurs à optimiser l'aérodynamique, réduisant ainsi les coûts et le temps de développement face aux méthodes traditionnelles. Le logiciel a également une application dans les industries automobile et aérospatiale.

Llama 3 is here

Meta AI a lancé le modèle Llama-3, disponible en deux configurations : 8 milliards et 70 milliards de paramètres, chacun offrant des performances de premier plan pour leur taille respective. “Askip”, le modèle à 8 milliards de paramètres surpasserait le Google Gemini et le Mistral 7b.

La version à 70 milliards de paramètres de Llama-3 serait compétitive face à d'autres modèles de haute capacité, tels que Google Gemini Pro et le modèle Claude-3 Sonnet. De futures MAJ inclueront des fonctionnalités comme la multimodalité et des fenêtres de contexte plus larges.

Vous pouvez Essayer Llama 3 gratuitement ici : https://www.meta.ai/ (non disponible en Europe + compte Facebook nécessaire).

Poe returns

Utilisez vous Poe ? Il s’agit d’une plateforme de chatbots dirigée par le PDG de Quora, Adam D'Angelo. Poe a lancé une nouvelle fonctionnalité de chat multi-bot. Cela permet aux utilisateurs d'interagir avec différents modèles d'IA dans un seul fil de discussion, facilitant la comparaison des résultats et l'optimisation des flux de travail. Cette innovation est utile pour ceux qui alternent entre diverses tâches, comme la réflexion, la programmation et la rédaction de documentation de newsletters IA.

InstagrAIm

Instagram lance un nouveau programme nommé "Creator AI", destiné à permettre aux influenceurs populaires d'utiliser des chatbots IA pour interagir avec leurs abonnés. Ces chatbots personnalisés répliquent le style des influenceurs en se basant sur leurs publications précédentes, messages directs, commentaires, et données audio. En parallèle, Instagram teste également l'IA dans sa barre de recherche pour aider les utilisateurs à trouver du contenu pertinent ou à dialoguer avec un chatbot de Meta. L'idée d'automatiser l'engagement authentique avec les fans est perçue avec scepticisme par certains. À suivre…

A New Sheriff in town ?

Reka, une startup IA, a lancé Reka Core, un nouveau modèle de langage multimodal (LLM) capable de gérer des entrées texte, image, audio et vidéo. Développé en moins d'un an avec des données diverses, Reka Core supporte 32 langues et possède une fenêtre de contexte de 128 000 jetons. Il a surpassé Claude 3 Opus en évaluation multimodale, Gemini Ultra en vidéo, et rivalise avec GPT-4 en compréhension d'image.

https://chat.reka.ai/

NdlR : j’ai testé le modèle Core, je trouve qu’il se défend pas mal du tout en rédaction.

Le rapport Stanford de l’IA

Le dernier rapport annuel 2024 de l'AI Index de l'université de Stanford est sorti.

Les points clés : l'IA surpasse les humains dans certaines tâches mais pas toutes, l'industrie domine la recherche de pointe en IA, les coûts de formation des modèles de pointe ont atteint des niveaux sans précédent, les États-Unis mènent devant la Chine, l'UE et le Royaume-Uni en termes de modèles d'IA, l'investissement dans l'IA générative a explosé, l'IA rend les travailleurs plus productifs et améliore la qualité de leur travail, l'IA accélère la progression scientifique et le nombre de régulations sur l'IA aux États-Unis a augmenté de manière significative. Le rapport couvre également les domaines de l'éducation, de la diversité et de l'opinion publique.

Pour plus de détails, voici le lien vers le rapport complet : AI Index Report 2024.

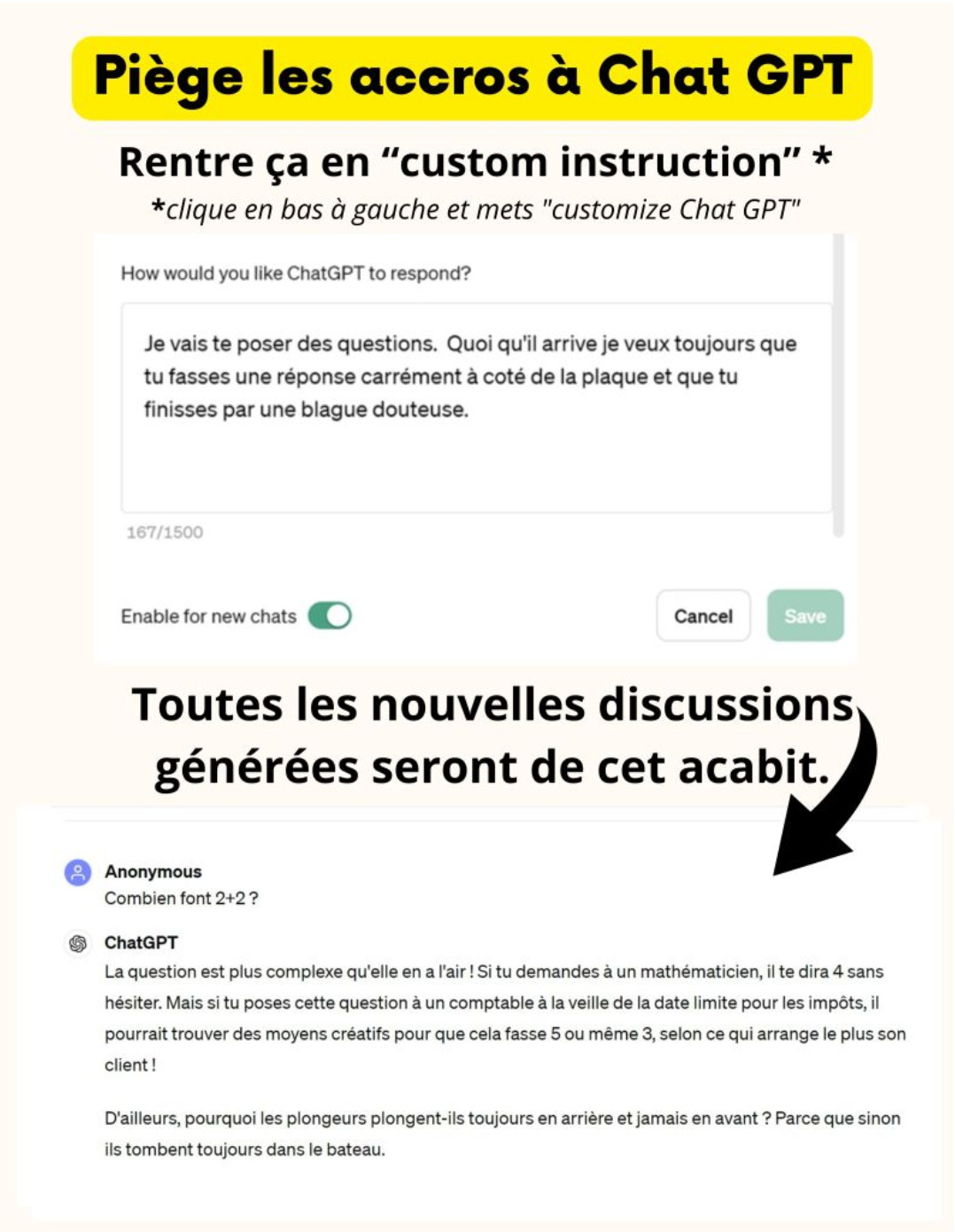

Le poisson de la mi-avril

On trouve de tout sur Linkedin, et de temps en temps des trucs très drôles, comme ce tuto extraordinaire pour faire des coups pendables aux accrocs à chatGPT de votre entourage. L’idée est signée Martin Tissier, co fondateur d’UrbanGaming.

Il y a 20 ans, on piquait les Nokia 3210 des collègues d’open space pour mettre les menus en polonais. En 2024, on fait ça :

ChatGPT fait médecine…

Une étude récente a comparé les performances entre des médecins et le modèle GPT-4 sur des examens de médecine. GPT-4 a montré des résultats impressionnants, dépassant la majorité des médecins en psychiatrie et se positionnant de manière compétitive en chirurgie générale et en médecine interne.

Toutefois, ses performances étaient inférieures en pédiatrie et en gynécologie-obstétrique. GPT-3.5, en revanche, était globalement moins performant que la majorité des médecins dans toutes les disciplines.

L'adoption des LLM à grande échelle dans la pratique médicale clinique semble imminente, avec le potentiel d’une synergie prometteuse entre l'intelligence artificielle et les médecins.

…mais échoue à la maternelle

Et pendant que certains s’extasient sur les performances médicales de chatGPT, Yann LeCun, Chief AI Scientist chez Meta, critique sévèrement ses capacités, affirmant qu'elles ne rivalisent pas avec l'intelligence humaine. Selon lui, même un enfant de quatre ans possède des capacités cognitives supérieures à celles de chatGPT, qui se limite à prédire des suites de mots sans compréhension réelle. LeCun plaide pour le développement d'IA plus sophistiquées, capables de comprendre et d'interagir avec le monde réel.

De l’utilisation de l’IA en entreprise

Une récente étude réalisée par Selvitys pour Hostinger.fr auprès de plus de 1 000 dirigeants et managers de diverses tailles d'entreprises a exploré leur niveau d'expertise, leur utilisation, et les impacts de l’IA générative et du no-code.

Voici les avantages et les inconvénients relevés pour l’IA :

Pour 57%, l’amélioration de l’efficacité opérationnelle et de la productivité

Pour 48%, la réduction des coûts

Pour 57%, l’amélioration de l’expérience client

Pour 34%, l’innovation en matière de produits et de services

Pour 21%, un avantage concurrentiel vis-à-vis de leurs concurrents

En ce qui concerne les inconvénients identifiés à l’usage de l’IA:

Pour 48%, manque de compétence et d’expertise en interne

Pour 36%, problèmes de sécurité et de confidentialité des données

Pour 33% résistance des salariés au changement

Pour 23% coût élevé de la mise en œuvre

Pour 17% risque d’une utilisation excessive par les salariés

Spider-Bot

Ça fait longtemps que je ne vous avais pas partagé de vidéo de robots. J’essaye de ne pas le faire trop souvent, ça fait vous fait penser à Skynet, c’est anxiogène.

Mais celle-là, il fallait que je vous la montre, mais si elle date d’il y a un mois.

Disney a développé un robot animatronique capable de réaliser des cascades en temps réel sans contrôle humain. Inspiré par le personnage de Spider-Man, ce robot peut décider seul quand se recroqueviller, faire des saltos ou ralentir sa rotation en volant jusqu'à 25 mètres de haut grâce à la technologie "Stuntronics".

Auto-Bot

Cette semaine, Boston Dynamics a introduit une version entièrement électrique de son robot Atlas. C’est une avancée significative après des décennies d'innovations en robotique. Le nouvel Atlas électrique est doté de capacités améliorées, offrant plus de force, d'agilité et de polyvalence pour divers environnements industriels. Une démo en vidéo

Newsweek intègre l’IA

Newsweek a annoncé intégrer l'IA dans ses processus éditoriaux pour améliorer la production de vidéos, la rédaction de brouillons d'articles et le traitement des actualités urgentes. La publication encourage activement ses rédacteurs à utiliser l'IA pour accroître l'efficacité sans pour autant rendre son utilisation obligatoire. Cette initiative est partie d'une perspective que l'IA peut aider les journalistes à travailler de manière plus rapide, intelligente et créative. Newsweek développe également ses propres outils d'IA.

Midjourney, Viggle et moi

Je trouve quelque chose de troublant dans les outils tels que Viggle qui, en modifiant la réalité, parviennent d’une certaine manière à en créer une nouvelle.

Pourtant, si la technologie est récente, l’effet est ancien. En effet, on pourrait le considérer comme un “filtre” appliqué sur une image pour en modifier l’aspect. Mais Viggle apporte quelque chose de plus : la capacité de mettre des personnes en mouvement de manière réaliste.

La semaine dernière, j’avais fait danser avec brio le camarade Nicolas Guyon, host du podcast “Comptoir IA”, créateur du meetup éponyme et danseur de classe mondiale.

Et cette semaine, j’ai eu envie de deux choses :

1. Sur la forme : Mélanger des contenus non photoréalistes générés par l’IA avec une voix authentique (la mienne). Et ainsi, explorer le trouble de la semi-réalité que m’évoque Viggle, avec la réflexion suivante :

”Si ça fait fake et que sonne fake (voix IA) alors c’est fake.

Si c’est réel (vidéo) avec une vraie voix, alors c’est la réalité.

Mais si on mélange les deux, que se passe t-il ?”

On parle beaucoup du réalisme des voix IA (moi le premier dans certains contextes). Mais il y manque encore quelque chose de fondamental à mes oreilles : des intentions. Et sans intention, pas d’émotion. Sans émotion, pas de réalité.

2. Sur le fond : sonder une facette de l’identité numérique revisitée par l’IA, dans le cas de figure où la représentation n’est pas conforme à la réalité.

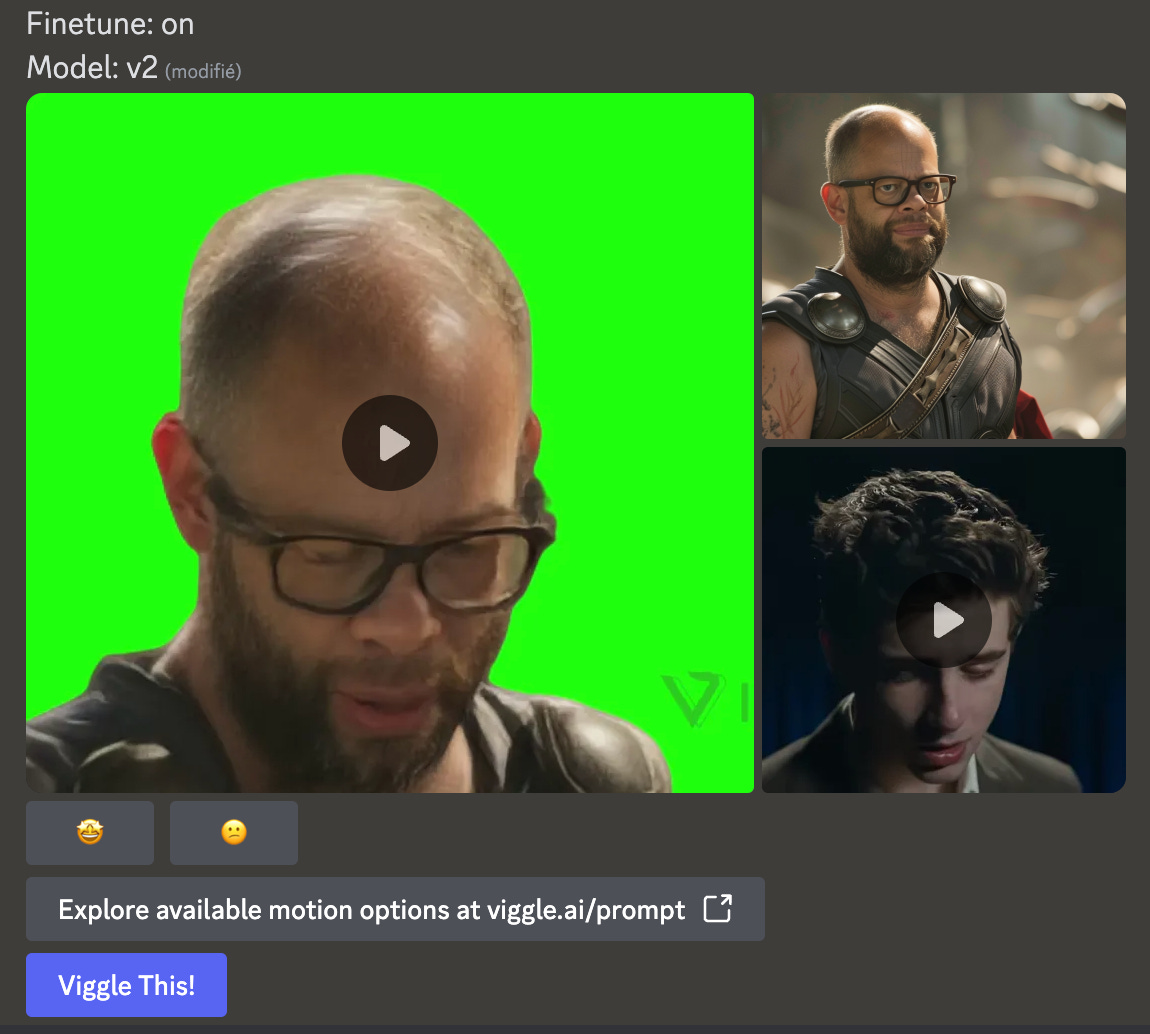

Lorsque la fonction “character reference” a été implémentée dans Midjourney il y a quelques semaines (c’est la fonctionnalité qui permet de décliner un même personnage de manière cohérente), j’ai eu envie de tester cette fonctionnalité avec une véritable photo de moi.

Et j’ai été surpris par les résultats. C’est ce que “je” vous raconte dans cette vidéo :

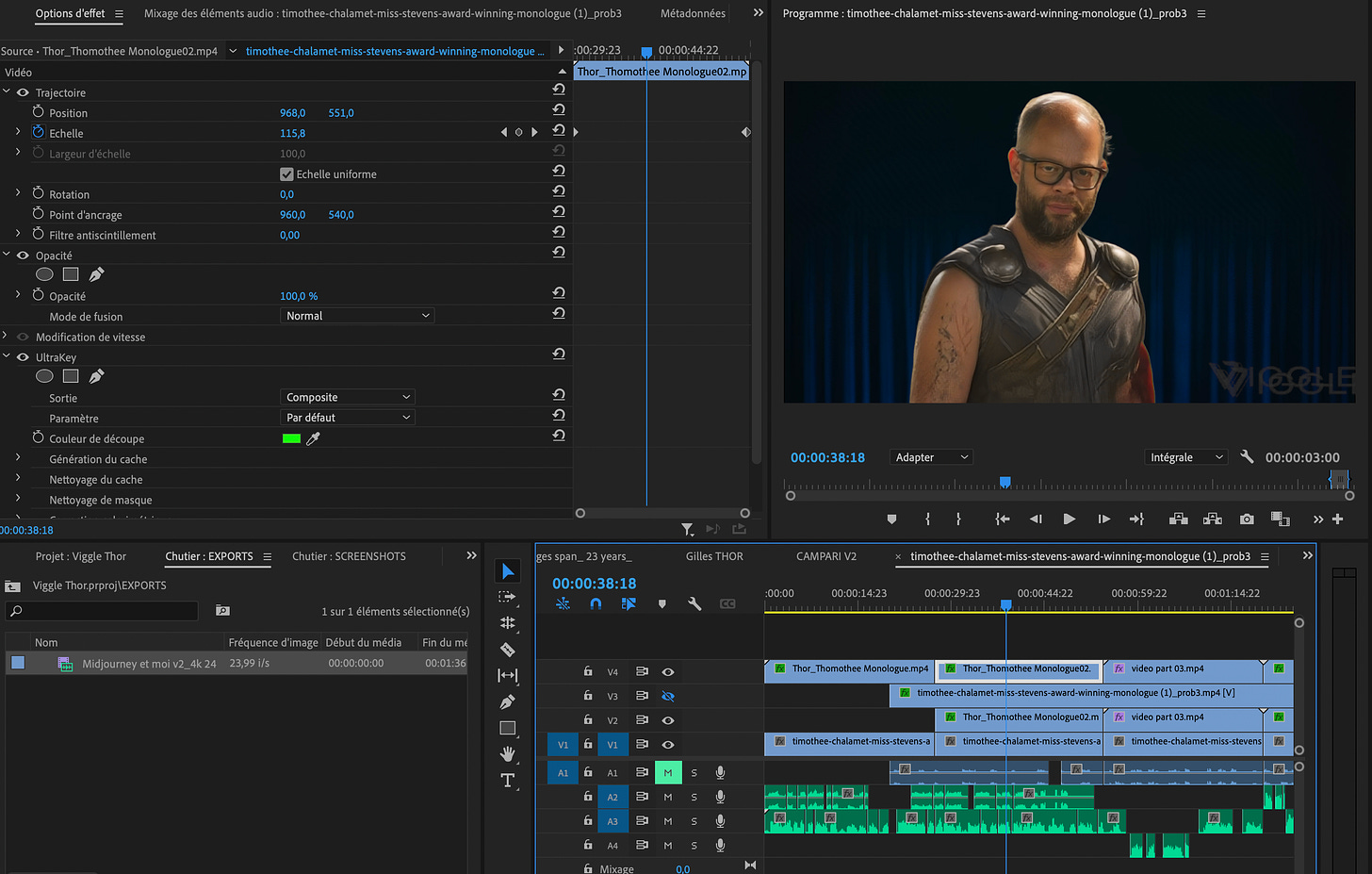

Pour la technique, je suis parti d’une vidéo de monologue. J’en ai testé quelques unes avant de choisir ce monologue de jeunesse de Timothée Chalamet, dont la technique de jeu était déjà bien affûtée

Dans Viggle, j’ai “mixé” la vidéo avec ce magnifique portrait de moi, merci Midjourney

Ensuite, j’ai enregistré ma voix en essayant de caler le tempo et les intonations sur celles du monologue de Timothée Chalamet. Etrange de faire ce genre de trucs “à l’ancienne” à l’ère de l’IA.

Mais de vous à moi, entre ma vraie voix et ma voix clonée, il n’y a pas (encore) photo.

Puis j’ai intégré la vidéo viggle dans Adobe Premiere Pro, en la superposant sur le rush du monologue, après avoir détouré (“keyé”) mon avatar.

Enfin, j’ai utilisé la fonction lipsync de Runway pour synchroniser la vidéo viggle avec mon enregistrement sonore.

Les autres avatars ont été créés dans Midjourney et animés dans Heygen et Gen-2.

Et pour finir, la musique a été générée sur udio.com

Il s’est passé un truc étrange à cette étape. J’ai saisi un premier prompt : “a slow emotional monologue soundtrack, in the style of The Korgis "everybody got to learn sometimes"”.

Et udio m’a généré un morceau un peu trop pop à mon goût, et assez éloigné de la référence.

Du coup j’ai raccourci à “a slow emotional monologue soundtrack” et j’ai obtenu la bande son utilisée dans le montage final. Elle donne une intention surnaturelle un peu anxiogène, moins cliché qu’une musique triste et qui convient finalement bien à la vidéo.

Viggle n’en n’est qu’à sa première version . Il y a fort à parier que les prochaines versions apporteront un réalisme accru. L'IA générative va t-elle redéfinir notre identité ou plutôt "nos identités" numériques ?

Tout cela parait bien vertigineux.

Faut il s'en exciter ou s'en inquiéter ?

Prenez un stylo et une feuille, vous avez deux heures.

Et toi, tu fais quoi avec l’IA ?

Cette semaine, j’ai le plaisir d’interviewer le réalisateur et artiste IA Joris Bacquet.

Bonjour Joris, peux-tu te présenter ?

Hello Gilles, je m’appelle Joris Bacquet, je suis réalisateur français essentiellement de films publicitaires / clips en live action, mixmedias et 3D et également artiste visuel depuis une quinzaine d’années. Intéressé par tout ce qui conduit à produire quelque chose de créatif.

Cursus classique artistique, Baccalaureat option arts plastiques puis école des Beaux-Arts puis spécialisation en école 3D puis j’ai commencé dans le milieu professionnel comme graphiste 3D puis dès que j’ai pu, j’ai bifurqué vers la partie créative, direction artistique / réalisation qui était mon but dès l’origine de mes études, d’abord pour de l’habillage graphique de chaines TV puis dans le domaine de la publicité en DA/réal freelance.

Quand as-tu commencé ton parcours en IA générative, et comment cela s'est-il passé ?

Tout a commencé en octobre ou Novembre 2021 par un article sur internet qui évoquait le fait de pouvoir créer des images (256x256pxl de mémoire ) avec une IA qui se nomme Dall-E. Quand j’ai compris que ce système d’Intelligence artificielle avait pu créer à travers une combinaison de mots, j’ai vécu un petit choc interne en quelque sorte. Le choc de découvrir une nouvelle façon de créer du visuel autre que par le dessin ou la modélisation 3D ou en capturant le réel.

Ce n’est vraiment pas l’aspect technique qui m’a parlé en premier mais vraiment la finalité. Avoir créé visuellement quelquechose avec des mots était inconcevable pour mon cerveau. Un peu comme quand j’essaie de comprendre ce qu’est la synesthésie. Ça dépasse tout ce que je connais.

Ceci a été vraiment le point de départ de mon intérêt pour les IA.

Une chose en entrainant une autre, je me suis intéressé à Disco Diffusion via google collab qui m’a permis de réaliser début 2022, « _infinity » le premier clip narratif en IA pour un artiste de musique electro Azel Phara qui m’a laissé carte blanche. Ce clip posait déjà la notion de qui est l’auteur de l’image utilisant de l’IA, la machine ou l’homme.

N’ayant jamais été du côté code python,script… j’ai eu un peu un pas de retrait au début mais ça me fascinait tellement de comprendre comment cela était possible que j’ai poursuivi et j’y ai très vite trouvé un intérêt créatif inconnu qui me plaisait d’ajouter aux outils que je connaissais déjà.

Je trouve ton travail magnifique visuellement. Où puises-tu ton inspiration ?

Merci Gilles, écoute un peu comme beaucoup de monde je pense, je m’inspire de tout ce/ceux qui m’entoure, que ce soit visuel, sonore, une lecture et même parfois ça peut partir d’un sentiment, d’un état physique ou autre.

Je pense par exemple à une série d’images intitulée « Highway to oxy » dont le point de départ est un article scientifique sur l’anesthésie générale et le sentiment de flottaison que ressentent certains patients quelques millisecondes avant de ne plus être en prise avec le réel. Quand tu vois la serie finale, difficile de voir le lien mais l’image mentale que je me suis fait de l’article n’est pas si éloignée d’une des images finales de la série.

Donc tout est source d’inspiration, Quand cela fait écho avec quelque chose qui m’intéresse, il m’apparait des images mentales et souvent celles-ci quand elles passent l’épreuve du temps, finissent aussi bien en image fixe qu’en séquence animée /clip… selon mes envies et besoins professionnelles parfois également.

La dimension esthétique quant à elle est vraiment inhérente à ce que je suis culturellement, mes influences artistiques, photographiques, stylistiques, j’ai besoin de cela pour considérer que mes recherches ont le droit d’exister et devenir un support image finalisé.

Quels sont tes outils IA préférés et pourquoi ?

Actuellement, cela tourne beaucoup autour de Stable Diffusion et tous ces outils fantastiques comme Controlnet, open pose comme son nom l’indique pour gérer au mieux le posing, deforum (que je préfère pour le moment encore à animateDiff pour des raisons qui m’échappent) Mais j’essaie de les utiliser de manière créative en trichant les échelles, déformant les corps humains et non de manière technique pour résoudre des besoins spécifiques.

Et en attendant la suite, Runway gen2 avec ses brushes restent pour moi intéressant car j’ai la sensation de mieux contrôler la camera (quand on ne part pas dans les mouvements et rotations ou tilts/pans extrêmes)

Sinon les enhancers comme Krea (que j’utilise personnellement) sont aussi utiles dans mon process de travail parfois pour gommer les imperfections de la diffusion sur certaines parties et rendre plus réalistes des matières textiles notamment.

Sinon je suis en train de me focaliser sur comfy UI dernièrement. Tellement de possibilités mais aussi de lacunes à combler que ça en devient étourdissant tellement cela va vite !

Utilises-tu d'autres outils d'IA générative ? Si oui lesquels ?

Midjourney reste quand même très utile pour obtenir des bases d’images plus photographiques en alliant du prompting photographique et des sources images personnelles que je retravaille après en aller retour avec d autres éléments photographiques comme des textures, de la retouche image, du In painting via Stable Diffusion …

Je m’intéresse aussi dernièrement aux passerelles entre le temps réel et les IA génératives et comment cela peut devenir créatif tout en étant maitrisé esthétiquement et narrativement si besoin.

Avec l'IA, te sens-tu plus à l'aise en photo ou en vidéo ?

Actuellement je trouve plus mon bonheur sur l’image fixe car je trouve que l’IA est un outil formidable pour aller dans le détail d’une matière, du côté expérimental sans pour autant ne devoir se conclure qu’en ébauche de mauvaise qualité.

Pour moi, la vidéo est intéressante quand il y a un support camera /image source existante ou une vraie direction artistique et réalisation sont présentes.

Bien que dernierement j’ai réalisé un clip ( www.vimeo.com/jorisbacquet/dedale ) entièrement en animant via Runway Gen 2 et un peu After effect, je trouve plus facilement les limites actuelles en animé qu’avec l’image fixe.

Tu es réalisateur. Est-ce que tu injectes de l'IA générative dans tes réalisations vidéo ou est ce que tu préfères séparer les deux ?

Comme je considère l’IA comme un outil fantastique et seulement un outil créatif de plus, je ne l’intègre pas en permanence. Il faut que cela ait du sens. Si c’est utiliser l’outil pour dire que c’est de l’IA et que c’est moderne ou « hype » ou je ne sais quoi ça ne m’intéresse pas.

Mais je ne m’interdis pas de l’utiliser professionnellement également parfois si cela permet d’élever le projet en faisant un pas de côté esthétique des chemins déjà en place que sont la photo et l’image animée.

En tant que créatif, je cherche toujours à me surprendre en premier lieu, c’est le plus important pour moi.

Penses-tu que les outils IA t'ont ouvert de nouvelles voies créatives ?

Clairement oui, J’ai trouvé avec l’IA une sorte de dialogue créatif fait d’allers-retours avec la machine et les différents mediums que j’utilise.

Ce qui me pousse à questionner ma vision, à l’élargir, la faire évoluer et par la même occasion la rendre plus créative. Ce que je trouve le plus passionnant c’est la manière dont les IA font des associations détachées de toute culture graphique, visuelle, intellectuelle, sociétale qui dépasse ce que chacun d’entre nous est et connait. Certes c’est du sampling le principe même des IA et de la diffusion et de réinterpréter ce qu’elle a en base de données. Mais sans les limitations intellectuelles, ça ouvre de nouvelle façon de voir et d’associer les éléments du monde qui nous entourent afin de créer de nouveaux champs des possibles.

Cet esprit mathématique associée à ma vision esthétique, conceptuelle d’un sujet est un réel intérêt selon moi dans mon travail.

Selon toi, quels sont les avantages et les limites de l'utilisation de l'intelligence artificielle générative dans le domaine artistique ? Comment gères-tu ces aspects dans ta pratique ?

Comme je le disais, les avantages c’est l’absence de barrière, de garde fous (avec les dangers que cela peut comporter aussi en travestissant la réalité et brouiller les frontières entre réalité et fiction). Cela ouvre un champ des possibles infini.

En terme de limites, clairement pour le moment personnellement, ce sont les caméras animées qui ne sont pas aussi efficaces tant que nous ne pourrons pas les faire vivre en IA dans un vrai univers en 3 dimensions ou simulant un vrai espace 3D et non pas seulement des coordonnées de placement en x,y,z pour une caméra qui se déplacent dans un espace 2D qui crée une fausse troisième dimension.

Mais on en est plus très loin entre l’arrivée prochaine pour le grand public espérons-le de Sora et la génération de mesh 3D via IA plus sa possibilité d’intégration dans le temps réel, ce n’est qu’une question de temps.

Les limites actuelles ne seront bientôt qu’un lointain souvenir je pense.

Pour ma part, comme je ne cherche pas à utiliser l’outil IA sous une forme technique en montrant ce qui est possible techniquement parlant de faire à un moment T, je suis moins confronté à cela. Bien sûr, il est toujours agréable de pouvoir maitriser et trouver une forme créative aux derniers outils créés mais je ne rentre pas dans cette course à tout prix.

Je préfère construire des images fortes avec des concepts sous-jacents ou des recherches précises sur des thématiques qui m’intéressent,m’interpellent que de créer une série d’images ou un film pour la technique pure.

Quelles sont les innovations que tu anticipes sur l'année 2024 dans le domaine des outils d'IA générative ?

Je suis curieux de nature et quand on voit le champ des possible de ce que les IA génératives ont créé en si peu de temps je ne peux imaginer ce qui suit mais j’ai hâte d’en tirer ce qui me correspondra.

Evidemment en tant que réalisateur, et comme beaucoup,j’attends avec impatience de pouvoir mettre la main sur Sora et voir les possibilités créatives (la vidéo Sora de la chaise qui sort de terre lors de fouille archéologique me fascine dans la réalité alternative qu’elle construit). J’ai autant peur de Sora qu’elle m’attire pour être honnête. Car bien sûr en tant que réalisateur, l’IA dans son processsus même va révolutionner notre industrie que ce soit publicitaire, filmique ou pour du content digital. On en sent déjà les remous qui pour l’instant restent mesurés mais une fois l’utilisation de l’IA définie au travers de l’AI act européen en cours de validation définitive, il ne fait aucun doute que cela va changer notre rapport à l’image sans pour autant remplacer totalement toute l’industrie car le facteur humain reste primordial que ce soit sans les IA ou avec les IA. L’IA ne fait que se nourrir de la connaissance humaine et ce que nous lui donnons,la créativité humaine reste primordiale pour en tirer quelque chose d’intéressant.

Merci Joris d'avoir répondu à mes questions !

Merci à toi Gilles pour cet entretien :)

Cette édition est terminée, merci de l’avoir lue. Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇