ChatGPT + Midjourney = ?

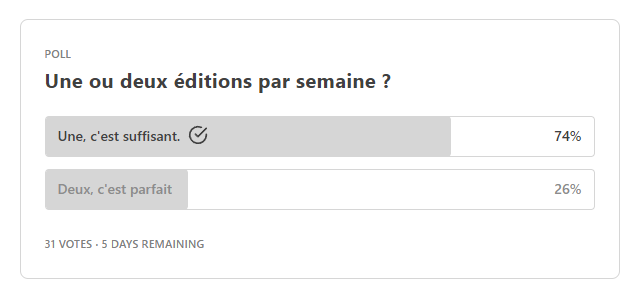

Bonjour à toutes et à tous, bienvenue dans cette nouvelle édition de GENERATIVE, la newsletter consacrée aux outils d’intelligence artificielle générative et à leurs usages. Merci à toutes celles et ceux qui ont pris la peine de répondre au sondage de la dernière édition. Le résultat est clair :

“Je vous ai compris” !

L’unique édition hebdomadaire paraitra désormais le vendredi. D’un côté, je prends beaucoup de plaisir à rédiger cette newsletter et ça me plait de le faire autant que possible.

D’un autre, il est effectivement très chronophage de dénicher les meilleures news, de les synthétiser (même avec l’aide précieuse de chatGPT) et de rédiger tests et dossiers. Le conclusion est que me focaliser sur une seule NL le vendredi me parait être une bonne idée.

Au sommaire aujourd’hui :

1 - Un meetup IA chez Google !

2 - Dans la presse cette semaine

3 - Les news de la demi-semaine

4 - Dossier : Faut il utiliser ChatGPT avec Midjourney ?

Meetup IA chez Google

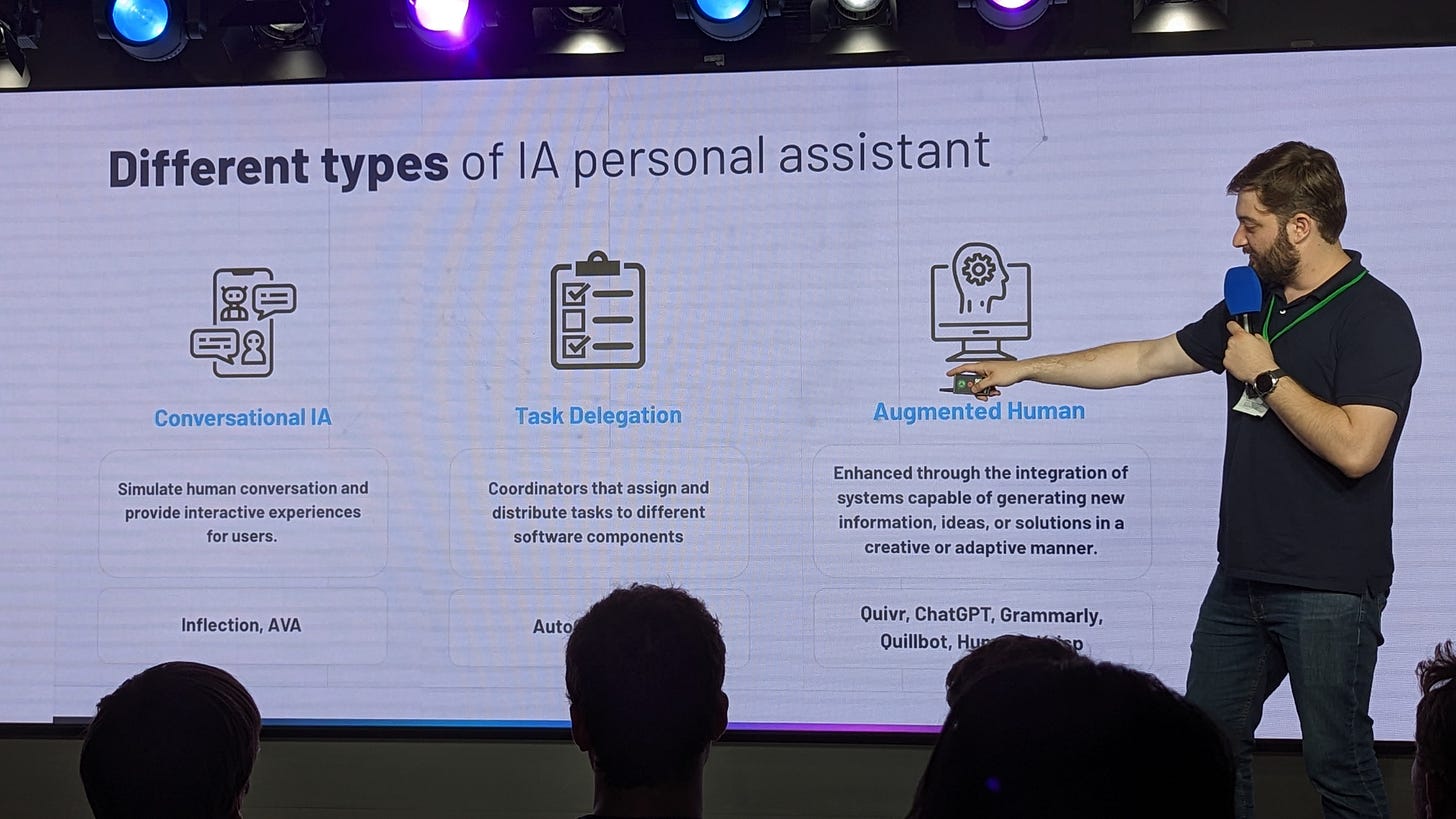

Mardi dernier, j’ai eu la chance d’assister à un Meetup AI organisé par l’association Generative AI Paris, dans les locaux parisiens de Google. Parmi les speakers, Farid El Attaoui, Machine Learning Specialist chez Google, nous a parlé de modèles de langage et nous a présenté la plateforme Vertex AI.

Vertex AI est une “plateforme d'intelligence artificielle unifiée” B2B qui offre tous les services cloud de Google à un seul endroit. Avec Vertex AI, il est possible de créer des modèles d'IA, de les déployer et les faire évoluer à l'aide d'outils pré-entraînés et personnalisés.

Parmi les nombreuses fonctionnalités proposées par la plateforme, celle qui a retenu mon attention, c’est les API qui permettent aux équipes ne disposant pas de connaissances approfondies en Machine Learning ou d'ingénieurs dédiés à l'apprentissage automatique d'ajouter facilement des capacités d'IA à leurs applications. En d’autres mots, une interface qui permet à l’utilisateur de s’affranchir de connaissances techniques, exactement comme Windows ou MacOs vous permettent d’interagir avec vos ordinateurs sans taper une seule ligne de commande.

Bref, si vous aviez l’idée de lancer un business de développement de chatbot personnalisé pour les entreprises, réfléchissez-y à deux fois. Bientôt tout le monde pourra déployer des solutions d’IA générative personnalisées quelques clics avec des plateformes comme Vertex AI.

L’intervenant suivant, Stanislas Girard, Engineering Manager chez Padok, nous a présenté une solution qu’il a développée et qui s’appelle Quivr.

Quivr propose d’utiliser chatGPT comme deuxième cerveau 🧠

Pour simplifier, on peut le définir comme une base de données que vous alimentez avec vos propres données (PDFs, PPTs, Word, Excel, audios, vidéos et même des sites web). Vous pouvez ensuite interroger cette base avec chatGPT3.5 ou 4.

Et comme vous vous en doutez, il ne s’agit pas de simplement faire de l’interrogation de base de données, mais d’utiliser la puissance de chatGPT pour restituer, synthétiser, croiser, mixer, reformater vos données avec des possibilités inédites jusque là.

Stanislas y voit une manière de remplacer avantageusement Notion et Obsidian.

Le 3e intervenant, Raouf Chebri a soulevé le capot et nous a fait mettre les mains dans le camboui avec sa keynote intitulée “quel vector store utiliser pour stocker et faire des recherches sur ses embeddings ? Quels sont les limites de pgvector ? Quels sont les avantages des autres outils comme Pinecone, Weaviate, Redis ?”

Autant vous dire qu’il m’avait perdu dès “Vector store”. En revanche, les ingénieurs présents dans la salle semblaient très intéressés.

Un meetup sensiblement plus tech que l’édition précédente, dont je parlais ici :

https://iagenerative.substack.com/i/120289124/party-time mais néanmoins très intéressant. Merci et bravo à Maxime Thoonsen pour l’organisation.

Je vous tiendrai au courant des prochaines dates, si ça intéresse les lecteurs parisiens.

Dans la presse cette semaine

J’ai eu le plaisir cette semaine d’être à nouveau interviewé par le journal Le Monde sur ma pratique de Midjourney.

Ainsi que pour le site du média La Réclame, où j’ai eu le plaisir de répondre à des questions sur l‘IA générative aux côtés de camarades d’exploration tels que Mathieu Cruq, Directeur Général de l’agence Brainsonic, que j’avais interviewé il y a quelques semaines ou Marc Horgues-Debat, co-founder de l’agence web3 OK C’est Cool.

Un article passionnant si vous vous intéressez aux usages de l’intelligence artificielle générative dans la communication digitale, à l’appropriation de ces technologies par les professionnels du secteur, et à leur leur impact à court et moyen terme.

(Et ravi que l’article soit illustré par mes créations Midjourney !)

Les news de la demi semaine

JEPA les mots pour dire à quel point cette news est potentiellement énorme

Meta, la maison mère de Facebook, a dévoilé un nouveau modèle d'intelligence artificielle nommé "JEPA" (Joint Embedding Predictive Architecture), capable de comprendre le monde sous-jacent, d'apprendre, de raisonner et de planifier des tâches. Ce modèle s'appuie sur une nouvelle architecture conçue par Yann LeCun, le "AI chief scientist" du groupe.

Contrairement aux modèles d'IA générative, JEPA compare des représentations abstraites d'images ou de sons, répliquant le fonctionnement du cerveau humain. JEPA apprend en créant un modèle interne du monde extérieur, en comparant des représentations abstraites d'images plutôt que les pixels eux-mêmes. L'objectif est que ces modèles deviennent auto-apprenants.

De plus, JEPA est plus rapide et nécessite moins de puissance informatique que mes modèles actuels. Les premiers cas d'usage de ce modèle concernent la reconnaissance d'images, mais à long terme, cette IA pourrait élaborer des stratégies marketing ou publicitaires complètes pour des marques.

Last but not least, Meta a mis JEPA en open source, comptant sur la communauté des développeurs et des chercheurs pour l'améliorer.

Amazon pousse l’IA en interne

Un document interne Amazon a fuité. Intitulé "Generative AI-ChatGPT Impact and Opportunity Analysis", il liste 67 cas d'opportunités d'utilisation de ChatGPT et d'applications d”IA générative dans une large gamme d'équipes chez Amazon.

Les employés d'Amazon utiliseraient le chatbot IA pour générer automatiquement du code logiciel et des contenus marketing. Les commerciaux pourraient l'utiliser pour parcourir rapidement les rapports financiers d’Amazon et de ses concurrents afin de définir plus précisément leurs objectifs stratégiques.

Certaines des idées mentionnées dans le document sont déjà en phase de prototypage, notamment un outil d'automatisation de la sécurité et une application d'ingénierie capable de répondre rapidement aux questions liées aux produits cloud d'Amazon Web Services. Le document témoigne du travail qu'Amazon effectue en coulisses pour répondre à l'essor soudain de ChatGPT et d'autres applications IA.

AMD s’attaque à Nvidia

AMD a annoncé son dernier GPU dédié à l'IA, le MI300X, qui devrait être commercialisé dans le courant de l'année. Cette puce constitue un défi de taille à la domination de Nvidia sur le marché des puces d'IA. Ce lancement s'inscrit dans le cadre de la stratégie d'AMD en matière d'IA, un secteur qui devrait passer de 30 milliards de dollars à plus de 150 milliards de dollars d'ici 2027. Conçu pour les grands modèles de langage, le MI300X pourrait faire baisser les coûts des applications d'IA et prendre des parts de marché à Nvidia.

Here come the b.I.A.tles

La musique générée par l'IA est un sujet d'actualité, au point où Paul McCartney a créé une nouvelle chanson des Beatles en utilisant l'IA. La chanson, qui sera sera publiée plus tard cette année, utilisé la voix de John Lennon, extraite d'une ancienne démo, probablement de "Now and Then", un enregistrement de Lennon de 1978. L'inspiration pour la chanson est venue du documentaire “Get Back" de Peter Jackson.

Pour ce processus, un système d'IA personnalisé a été utilisé pour séparer les voix des différents membres des Beatles du bruit de fond, permettant une reproduction de haute qualité. Malgré quelques réserves, McCartney a déclaré que c'était "effrayant mais excitant, parce que c'est l'avenir". Merci Paul pour cette analyse de qualité.

InterstellRap

Non, Paul McCartney n’a pas l’apanage de la création musicale assistée par l’IA. Vous pouvez aussi commencer à essayer de composer des chef d’œuvre avec MusicGen, un générateur de musique lancé par Meta. Basé sur l'IA , MusicGen crée des morceaux audio à partir de prompts.

Développé par Audiocraft, l'équipe de recherche audio de Meta, MusicGen a été formé sur 20 000 heures de musique (dont 10 000 morceaux provenant des banques ShutterStock et Pond5) et peut générer un extrait original de 12 secondes basé sur une description de style musical. L'outil, qui peut être testé via une version de démonstration, est un concurrent de MusicLM, un outil similaire dévoilé par Google plus tôt cette année.

Le musicien qui sommeille (lourd) en moi a tenté un crossover entre Hans Zimmer et du hip hop West Coast des années 90. Concrètement, j’ai uploadé un extrait du thème principal d’Interstellar, et j’ai prompté : “West coast hip hop song from the 90's”.

Alors, MusicGen, c’est génial ?

Pas exactement. L’interface est assez rustique, le temps de génération est très long (jusqu’à 10 minutes d’attente selon la charge) et une durée finale de 12 secondes, c’est définitivement beaucoup trop court.

Le bon côté des choses c’est que vous êtes en train d’assister à la préhistoire de la création musicale assistée par l’IA (même s’il existe déjà des solutions plus performantes, j’en reparlerai), ça fera des trucs super à raconter aux avatars holographiques de vos futurs petits enfants augmentés, lors des réveillons de Noël dans le Metaverse. J’ai hâte.

Synthesia

100% des hotlines et customer services du futur seront-ils des avatars alimentés par des chatbots ? C’est ce que semblent penser les investisseurs (parmi lesquels Accel et Nvidia) qui viennent de miser 90 millions de dollars en série C sur la société Synthesia, une entreprise spécialisée dans les vidéos générées par l'IA à l'aide d'avatars synthétiques et de voix générées par l'IA.

Elle compte plus de 50 000 clients et affiche un taux de croissance des utilisateurs de 450 % d'une année sur l'autre.

Ce tour de table porte la valorisation de Synthesia à un milliard de dollars, soit une augmentation de 300 millions de dollars par rapport à la fin de l'année 2021.

Objectivement, le degré de réalisme est impressionnant, regardez :

Le futur du travail

Selon un rapport du McKinsey Global Institute, l'IA générative a le potentiel d'ajouter jusqu'à 4,4 billions de dollars de valeur à l'économie mondiale chaque année.

Cette technologie pourrait augmenter l'impact de toute l'intelligence artificielle de 15 à 40 %.

Le rapport suggère que d'ici 2030 à 2060, la moitié du travail pourrait être automatisé - la puissance des outils d'IA générative a accéléré cette prévision par rapport aux prédictions précédentes. Les domaines qui pourraient bénéficier le plus de l'IA générative sont les opérations client, le marketing et les ventes, l'ingénierie logicielle et la R&D. L'IA générative pourrait également transformer le travail, automatisant des activités qui absorbent 60 à 70 % du temps des employés aujourd'hui.

McKinsey affirme également que ces changements "remettront en question l'obtention de diplômes pluriannuels", ce qui signifie que les travailleurs du savoir pourraient être les plus susceptibles de voir leur carrière affectée.

Que pensez vous de cette supposition ?

“Le futur que nous réserve t-il ?”

Le journal du net a publié récemment une analyse futurologiste intéressante de Sylvia Tassan Toffola, présidente du Syndicat des régies internet (SRI) et DG de TF1 Pub.

Elle envisage un futur où le numérique sera structurel et structurant à plusieurs niveaux : économique, environnemental, sociétal et même culturel et identitaire.

Dans 20 ans, nous serons avant tout des citoyens numériques, avec l'IA qui ancrera notre identité numérique. L'IA apportera des bénéfices très nombreux, avec des gains de productivité colossaux, mais également le risque de nous habituer aux sirènes de la facilité et de la copie, mettant un frein à notre créativité.

Un point de vue intéressant. Je fais partie de ceux qui pensent qu’à “augmenter” la portion de l’humanité qui aura un accès facile aux outils d’intelligence artificielle, on va en réalité, et de manière très ironique, la “diminuer”.

Pourquoi solliciter ses compétences cognitives lorsque la machine pourra (presque) tout faire à notre place ?

Réguler, oui mais comment ?

Le bras de fer entre Google et OpenAI se poursuit au delà du terrain de la tech. Les deux sociétés affichent des opinions différentes sur la manière dont l'IA devrait être gouvernée et réglementée par le gouvernement américain.

OpenAI préconise la création d'une nouvelle agence gouvernementale chargée spécifiquement de la réglementation de l'IA, tandis que Google est favorable à une approche reposant sur des régulateurs sectoriels informés par une agence centrale telle que le National Institute of Standards and Technology (NIST).

Un élément clé est que si le gouvernement américain décide d'opter pour une nouvelle agence dédiée à la réglementation de l'IA, les États-Unis pourraient être confrontés à un contrôle plus centralisé et à des exigences de conformité plus strictes, ce qui pourrait ralentir le déploiement des outils d'IA.

Toutefois, si l'approche multipartite est suivie, il pourrait y avoir une réglementation plus souple, spécifique à un secteur, permettant une intégration plus rapide de l'IA, mais peut-être avec des normes diverses à respecter.

Et pendant ce temps là, en Europe

Le Parlement européen a adopté à une large majorité un projet de régulation de l'intelligence artificielle, marquant une étape importante dans la course au contrôle des innovations dans ce secteur. L'Union européenne aspire à être la première à mettre en place un cadre juridique complet pour limiter les abus de l'IA tout en sécurisant l'innovation.

La pilule bleue ET la pilule rouge.

Le projet de règlement, proposé il y a deux ans, a été retardé par des controverses sur les dangers des IA génératives. Le Parlement a adopté sa position, permettant d'entamer les négociations avec les États membres pour finaliser la législation, si possible, d'ici la fin de l'année. Le règlement n'entrera pas en vigueur avant 2026, au plus tôt.

D’ici là, on sera à chatGPT-8, capable de monter un business de A à Z, de répondre intelligemment à tous nos emails, de faire ma compta sans erreur et sans me réclamer d’argent, de disserter 1000 pages sur la philosophie analytique, de résumer les derniers films qu’il aura visionné sans spoiler la fin, de composer des tubes planétaires et de prompter brillamment dans Midjourney v12.

Mais sera t-il capable de faire d’aussi belles transitions que moi ?

Permettez moi d’en douter (encore un peu) 👇

Dossier : Faut-il utiliser ChatGPT avec Midjourney ?

A l’arrivée de Midjourney v5 il y a quelques semaines, de multiples sources ont insisté sur la nécessité d’arrêter de prompter avec une suite de mots clés séparés par des virgules, comme c’était la cas avec les version antérieures de Midjourney.

Un exemple :

A stunning portrait of a native american old warrior chief, tribal panther make up, blue on red, side profile, looking away, serious eyes, shot on DSLR, 50mm portrait photography, hard rim lighting photography--v 4 --ar 9:16

A écouter ces “experts”, il fallait désormais rédiger des phrases construites pour obtenir les meilleurs résultats. Certains allant même jusqu’à faire rédiger leurs prompts par chatGPT en personne.

Exemple : photography shot trough an outdoor window of a coffee shop with neon sign lighting, window glares and reflections. A portrait a woman is sitting at a table shot on kodak portra 800 with a 105 mm lens --ar 2:1

J’ai commencé par étoffer ma rédaction (sans nécessairement utiliser ChatGPT) avant de revenir à un style plus télégraphique, avec de bons résultats. Pour autant, la question demeure. Est-il pertinent d’utiliser chatGPT pour prompter dans Midjourney ?

C’est ce que nous allons voir ensemble maintenant.

Imaginez que vous ayez envie de créer le nouveau fond d’écran de votre smartphone. Vous avez envie d’une image cosmique. Voyons voir comment Midjourney se débrouille avec un prompt très simple :

J’ai mis “—style raw” pour éviter que Midjourney 5.1 ne parte dans des interprétations comme celles-ci (prompt : “universe —ar 9:16”)

Maintenant, il existe deux méthodes pour faire intervenir ChatGPT.

La première consiste à lui demander des descriptions que nous allons ensuite envoyer à Midjourney. La 2e méthode consiste à lui apprendre à prompter.

1ère méthode

Commençons par lui demander de nous décrire visuellement l’univers en moins de 50 mots. Comme toujours, on lui donne un rôle avant de le solliciter.

Elle est pas mal cette description. Lequel d’entre vous aurait fait mieux du 1er coup ?

Testons-la avec Midjourney :

Effectivement, on est tout de suite plus précisément dans le thème. Mais le rendu ressemble tout de même à de la peinture sur toile. Ajoutons “—style raw” pour voir :

Voilà qui est beaucoup mieux. Un point pour ChatGPT.

Par déformation professionnelle ou par goût pour la photographie, la majorité de mes créations Midjourney sont des portraits. Comparons un portrait créé “à la mano” avec un portrait crée avec ChatGPT au prompting.

D’abord un portrait prompté “à la main”

Ensuite, les résultat d’un prompt pondu par GPT 3.5

C’est très joli. Est-ce mieux que l’image promptée à la main ? Probablement.

Le prompt de GPT apporte quelque chose dans le regard et la posture que le premier prompt n’apportait pas. Le personnage semble nous interpeller. C’est plus intéressant.

Passons maintenant aux paysages. J’ai récemment réalisé une série stylisée intitulée “Wanderlust”.

Que nous dit chatGPT ?

Voici le prompt que je lui ai rédigé :

write a prompt that describes the beauty of a vietnamese landscape. Add style with keywords such as : "silhouette of a man", "minimalistic", "beautiful color grading", "moody", "apocalyptic", "cinematic", "rich color palette". no more than 60 words

Il m’a répondu avec une prose dont il a le secret, qui a donné ces images

Essayons avec le Japon

Puis avec le Maroc

Quelques bizarreries dans le ciel pour les images marocaines…

Pro Tip : La clé du rendu des couleurs de ces images, c’est le “style of Paul Cezanne” glissé au milieu du prompt. Sans cet élément, la colorimétrie est moins stylisée 👇

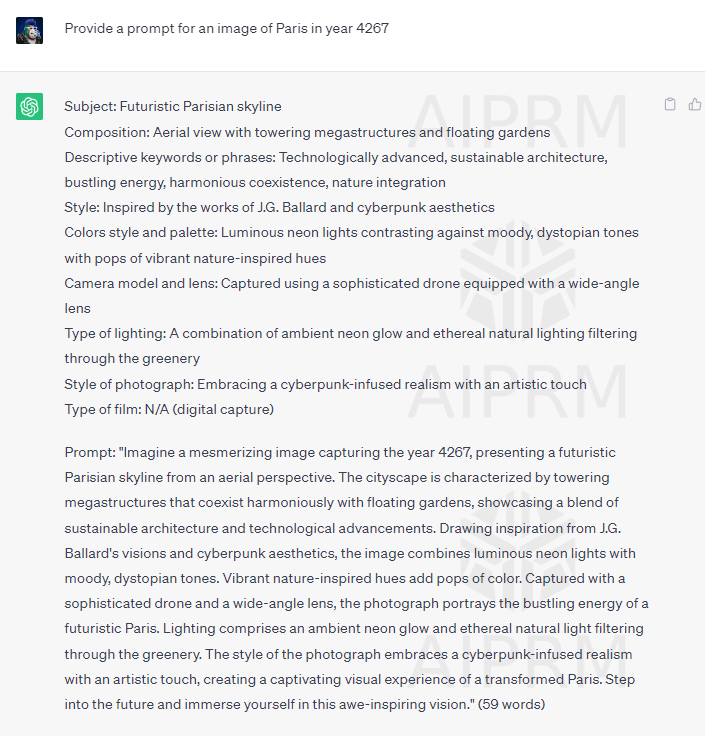

Abordons maintenant la 2e méthode, plus ingénieuse donc plus intéressante : Apprendre à chatGPT à prompter.

Étape n°1 : expliquer à ChatGPT ce qu'est Midjourney. Pour mémoire, ses connaissances s'arrêtent en septembre 2021 et Midjourney est sorti en juillet 2022.

Copions-collons une définition trouvée sur le net, donnons la à ChatGPT sans oublier de lui préciser l’objectif de la démarche ni de lui demander s’il a bien compris :

Etape n°2 : expliquer à GPT ce qu'est un prompt. Rendez vous dans la documentation de Midjourney. Pas besoin de tergiverser ici, on copie toute la page, qu’on colle dans chatGPT. Et voici sa réponse :

Magnifique, on peut passer à l’Etape n°3 : Lui expliquer la structure d’un prompt. Il n’a pas de formule absolue ici, l’idée est de faire en fonction de ses habitudes de prompting. ChatGPT étant parfois très verbeux, n’hésitez pas à lui donner une limite de 60 mots.

Pourquoi 60 mots ? Parce que c’est la limite au delà de laquelle Midjourney ne tient pas compte des informations supplémentaires. Sinon vous allez vous retrouver avec des prompts de 120 mots (soit environ le format d’une news de cette newsletter).

Etape 4 : Une fois que vous avez fourni suffisamment d'informations à ChatGPT, vous pouvez vous auto-féliciter : vous avez appris à chatGPT à prompter pour Midjourney !

Vous pouvez maintenant lui demander de prompter. Il vous suffit de lui fournir un concept. Je pars sur un Paris du futur.

Ce qui est intéressant maintenant, c’est non seulement de tester le prompt généré par ChatGPT mais de le comparer avec le prompt initial.

Le prompt généré par chatGPT donne t-il de meilleurs résultats qu’un prompt de 5 mots rédigés à la main ? Je vous laisse juger.

Faisons un autre essai avec un portrait.

Le Le prompt de 163 mots généré par chatGPT (il a rapidement oublié la consigne des 60 mots) est-il plus performant que le prompt de 6 mots ? Je n’en suis pas convaincu. En revanche, il apporte davantage de variété que le prompt court. Je suis persuadé qu’il existe un entre-deux pour obtenir la même variété avec des prompts plus économes en mots.

En conclusion, il n’est évidemment pas nécessaire d’utiliser chatGPT pour prompter dans Midjourney, et l’ingéniérie déployée pour apprendre à chatGPT comment prompter est intéressante d’un point de vue pédagogique mais n’apporte pas assez de valeur ajoutée pour être utilisée de manière régulière.

Néanmoins, le chatbot d’OpenAI peut, comme pour les contenus écrits, apporter une base de prompting et des idées sur lesquelles vous allez capitaliser et rebondir pour aller plus loin dans la création de vos images. Happy prompting !

Cette édition est terminée, je vous souhaite un week end ensoleillé et d’embrasser le futur en expérimentant autant que possible avec les outils d’intelligence artificielle générative.

N’hésitez pas à me suivre sur LinkedIn et activer la cloche 🔔 pour être tenu informé des prochains posts, ni à me contacter pour toute proposition d’intervention, conférence, projet, formation liée à l’intelligence artificielle générative. Et bien sûr, à vous abonner à la Newsletter 👇