Ça innove et ça déborde

Bonjour à toutes les machines qui liront cette nouvelle édition de GENERATIVE, la newsletter qui compresse l’actualité surabondante de l’IA générative

Cette semaine encore, avec Caroline Thireau, on a fait de gros efforts pour vous proposer une édition digeste. Mais le problème, c’est pas notre bonne volonté. C’est l’actu de l’IA générative qui elle, est toujours aussi indigeste.

Soyez courageux/ses, ça va bien se passer.

Au sommaire

🔹 Les news de la semaine

🔹 La vidéo de la semaine

🔹 Le workflow du mois

🔹 36-15 my Life

Au fait…

Je forme des profils communicants, créatifs et professionnels du marketing aux outils d’IA génératif (Génération d’images de vidéos, de voix et de sons, etc…

Je créé également des contenus visuels de qualité (image, vidéo, sons) avec l’IA.

Pour travailler ensemble, contactez moi sur Linkedin.

🔹 Section Nouveautés

🔹 Runway Gen-3 Turbo : des cameras under control

L’une des grosses news de cette semaine, c’est l’arrivée des camera controls dans Runway Gen-3 Turbo. Comme dans Runway Gen-2, vous pouvez désormais choisir à la fois la direction et l’intensité de vos mouvements de caméra pour un contrôle accru. Et si vous pratiquez la génération d’images et de vidéos vous le savez : le contrôle, c’est le nerf de la guerre.

🔹🔸 Freepik : des LoRAs sur-mesure

Freepik intègrera bientôt l’entraînement de LoRAs directement dans son interface, permettant aux utilisateurs d’y créer des modèles personnalisés à partir de leurs propres photos. Actuellement en bêta, il se dit même que l’entraînement pourrait concerner les LoRAs de style et pourrait bientôt être possible avec Flux comme Mystic. Brique après brique, Freepik continue de confirmer sa position en tant que suite complète, comme en atteste cette vidéo promotionnelle :

🔹🔸 X-Portrait 2 : un pas de plus vers l’animation réaliste

Bytedance lance X-Portrait 2 (la V1 était sortie en Juillet) qui permet d’animer une image à partir d'une vidéo source. Concurrente de HeyGen et RunwayML, elle améliore le réalisme des mouvements & synchro labiales mais aussi des expressions faciales, tout en séparant les traits du visage des émotions.

Grâce à un modèle d’encodage avancé, il s’adapte aux portraits réels que l'IA va animer et se destine aux animations et contenus numériques. Les résultats sont pas mauvais du tout comme on peut le voir dans ce petit comparatif Shining :

Contrairement aux alternatives payantes, Bytedance proposera cet outil gratuitement pour TikTok. Infos complémentaires sur github : X-Portrait 2.

🔹🔸 Kling : le video-LoRA

Kling lance "AI Face Model", en accès anticipé, conçu pour créer des avatars numériques stables dans le text-to-video. Il est désormais possible de conserver une apparence constante des personnages dans vos vidéos Kling, éliminant ainsi les variations aléatoires de visage d’une image à l’autre. Ou d’appliquer votre visage sur vos personnages.…

Pierrick Chevallier que nous soupçonnons d’être soit un cyborg Duracell, soit un humain à la tête d’une armée d’avatars, a testé l’outil en alpha :

Sur cette image ultra réaliste, nous avons même un doute !

🔹Blendbox : l’atelier digital gen AI modulable

Blendbox ai de Blockade Labs débarque en version alpha, avec une proposition intéressante sur le papier : faire du drag and drop pour modifier une image plutôt que de tout reprompter/inpainter (pardon pour le néo-anglicisme) à chaque itération. proposant un contrôle et une grande précision dans la création assistée par IA. Via un système de calques/layers comme dans les outils Adobe, il est possible de :

déplacer les objets en avant ou en arrière

repositionner, redimensionner, ajuster les objets, offrant une maîtrise très précise

retravailler sur un calque sans perdre de données

sauvegarder les projets tout en conservant l’historique des modifications

Le seul bémol à mon goût est ce rendu visuel “so 2023” diront les mauvaises langues.

Parce que comme chacun sait, un an en IA générative = 75 ans dans la vie réelle.

🔹🔸 HeyGen : génération relooking

HeyGen lance une fonctionnalité qui permet de créer des photo avatars basé sur un système de type LoRA. Vous uploadez quelques photos de vous, vous promptez pour générer des images, que vous pouvez panier ensuite. Sur le papier c’est ultra cool, regardez :

Dans la réalité c’est moins efficace qu’un “vrai” avatar vidéo (voix off ElevenLabs)

🔹🔸 Krea : l’entraînement des LoRaS débarque

Krea se met aux LoRas dont Gilles avait parlé en détails dans l'edition eponyme L'ère des LoRA : Me, Myself and (A)I : ça signifie que vous pourrez désormais y entraîner vos personnages, styles et produits. L’accès devrait être déployé dans les prochains jours. Votre servitrice est sur le coup pour déterminer si ce sera possible aussi sans abonnement !

(Visiblement, Krea voit des Sam partout !!…)

🔹🔸 Meshcapade : des agents 3D aussi humains que nature

Meshcapade développe une tech de prompt-to-3D qui cible des secteurs variés comme le gaming, ou l’animation. Fondée en 2018 à Tübingen, en Allemagne, l'entreprise se spécialise dans des outils de génération de mouvements essentiellement. Plus d’infos ICI.

🔹🔸 Le new kid de la semaine : Rendora

Ce nouveau venu veut simplifier la création d’avatars 3D “réalistes” (on met les guillemets, n’est pas HeyGen qui veut) en automatisant des étapes complexes comme le rigging (comprendre le principe de lier chaque partie du modèle à un « squelette ») pour rendre l'animation fluide. Avec sa bibliothèque d’avatars préconçus et sa synthèse vocale en temps réel, cela en fait une plateforme supplémentaire pour rendre ces technologies accessibles aux domaines de la formation, du streaming et du e-commerce.

🔷 Section Open Source

🔹🔸 Mochi Edit : open source, inpainting et restyling vidéo ?

Breaking : Une nouvelle fonctionnalité TRÈS attendue en vidéo arrive sur Mochi version Comfy UI : il serait désormais possible de faire de l’inpainting et du relight (modification de style) en vidéo.

Imaginez l’éditeur Midjourney en vidéo. Ce serait fou.

Deux exemples très courts :

Si vous êtes plutôt volatiles, la version Perroquet > Dragon.

Si vous êtes plutôt quadrupèpes, la version Loup > Dragon.

🔹🔸VidPanos : le panorama vidéo qui comble les vides !

VidPanos, développé par l’Université de Washington, Google DeepMind et l’Institut Weizmann, génère des vidéos panoramiques immersives en comblant les zones manquantes. En balayant la scène avec votre téléphone, l’outil crée une vidéo panoramique fluide et cohérente. Lien Github ici : VidPanos

Et vous, vous êtes plutôt skate ou plutôt ski ?

🔹🔸 Tencent Hunyuan3D-1.0 : Texte et image en 3D

Tencent lance Hunyuan3D-1.0, une interface de génération 3D à partir de texte et d’image. La démonstration montre un potentiel intéressant mais il faudra peut-être que Gilles se remette au chinois pour explorer pleinement le Text-to-3D ! A priori bientôt disponible sur ComfyUI, cet outil mérite un suivi attentif et nous en ferons un retour dans une prochaine édition.

Lien Github ici : Tencent Hunyuan3D-1

🔹🔸 BlenderGPT : le 3D express

BlenderGPT intègre GPT-4/GPT-3.5 directement dans l’interface de Blender, permettant de créer ou modifier des modèles 3D par commandes en langage naturel. Ce plugin convertit les instructions en scripts Python, facilitant la création 3D sans codage complexe. Les tests montrent un rendu rapide, bien que les rendus puissent encore être améliorés. Inscription waitlist ici : BlenderGPT (Démo de @aarya sur X)

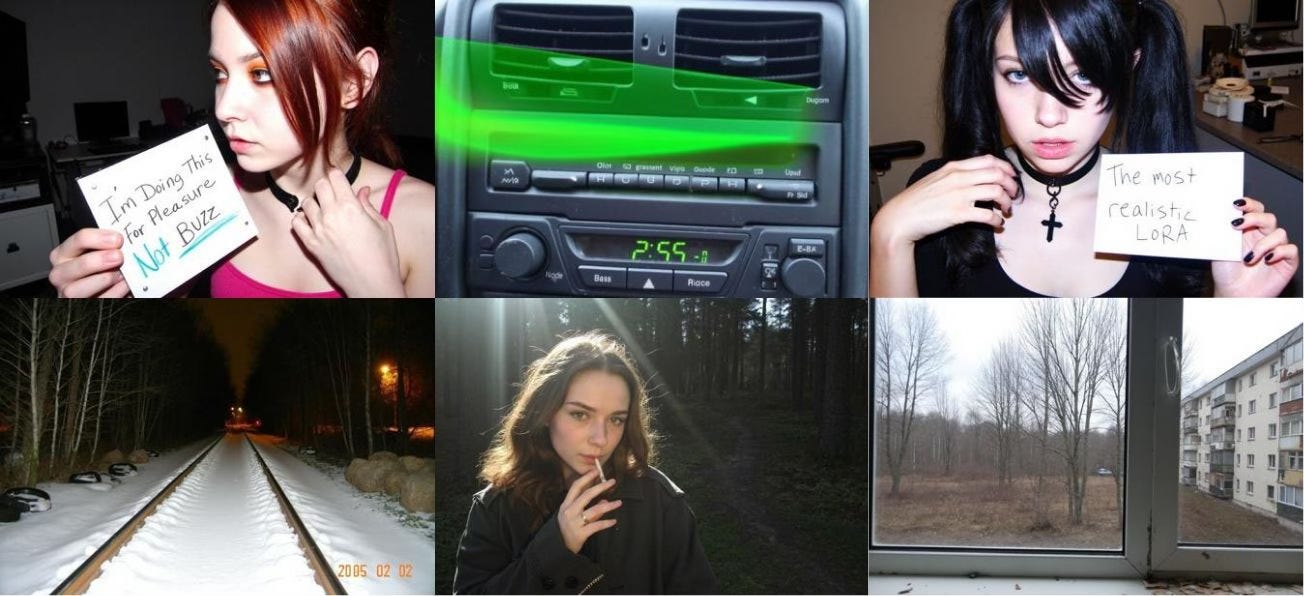

🔹🔸 CIVIT. AI : UltraRealistic Lora Project

Un nouveau LoRa hyper réaliste fait son apparition sur la plateforme Civit Ai. En combinaison avec Flux V2, son objectif est de proposer des images “plus vivantes”, avec un rendu un peu plus amateur (et donc plus réaliste) que ce que proposent les autres modèles.

🔷 La video de la semaine

Sora returns

Jon Uriarte, artiste digital, utilise Sora pour allier précision et spontanéité visuelle. Il dit être particulièrement impressionné par la qualité organique et onirique des images générées par Sora qui lui permet d'explorer de nouveaux angles… On aimerait bien en dire autant. Maintenant que le président US est élu, Sora sortira t-il ?

Yves Dalbiez fait partie des artistes IA ayant travaillé à la réalisation du dernier clip de Snopp Dogg sous la houlette des Dors Brothers, dont vous nous parlions récemment. Yves nous propose un petit making of qui vient tordre le cou à l’idée reçue selon laquelle tout se fait en 5 minutes avec l’IA.

Dans un making of généreux, Yves détaille son workflow, du storyboard papier au résultat final, en passant par d’innombrables itérations dans Midjourney, du détourage, de l’inpainting, de la fusion de frames, du time remapping, etc…

l’IA générative est utilisée ici comme un outil parmi d’autres, au sein d’un projet qui nécessite une grande expertise technique globale pour atteindre ses objectifs.

Voici ses retours d’expérience :

Rapidité de production avec un temps de création réduit à quelques heures.

Contrôle limité avec des mouvements imprécis malgré les avancées de Kling 1.5.

Le profil “flat” de Luma Dream Machine et la rapidité de Gen3 Alpha Turbo sont très appréciés

Compétences requises en storyboard, composition avec des retouches essentielles avec l'IA.

Selon lui dans le futur, l'IA s’ajoute au cinéma sans remplacer les tournages traditionnels

🔷 36.15 My life

J’ai vécu une semaine exceptionnellement dense avec 2 journées de formation chez Value Retail, un groupe spécialisé dans la création et la gestion de villages de marques de luxe. J'ai formé leurs équipes marketing à l'utilisation des outils de brainstorming et de création via l’IA.

Ensuite direction SATIS, le plus grand salon francophone dédié aux innovations technologiques dans les médias, le divertissement et la communication audiovisuelle. J'ai eu le plaisir d’être invité par Jean-Yves LeMoine participer à une table ronde aux côtés de mon ami de longue date Guillaume Colboc, producteur chez Gaumont, et de Louis Bonichon, fondateur de l'agence mnstr.

Une heure d'échanges autour du futur de l'audiovisuel et des enjeux techniques, éthiques et philosophiques liés à l'IA. C'était passionnant.

La même journée s'est terminée en beauté avec la 19e édition du meetup de Comptoir IA, qui s'est tenu à l’ESCP Business School dans le 15e arrondissement de Paris.

La semaine n’est pas terminée puisque j’ai le plaisir d’intervenir ce soir lors du premier event Runway organisé en France, qui aura lieu dans ma belle ville de Marseille !

Merci à Nicolas Geniart et à Ludovic Carli pour l’organisation ! Je vous débriefe la semaine prochaine.

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇