Bonjour à tous les créatifs augmentés et à celles et ceux qui rêvent de l’être.

Bienvenue dans cette 76e édition de GENERATIVE, la très grosse newsletter qui plie mais ne rompt pas sous le poids de l’actualité toujours plus frénétique de l’IA générative.

Toutes mes excuses pour la parution tardive de cette édition. Cette semaine, 3 journées de formation à préparer et à animer, 5h45 de visios, une connexion wifi défaillante dans mes 4 TGV et une enfant malade auront eu raison de ma ponctualité.

Cette édition aurait probablement été livrée mardi prochain sans l’intervention d’une nouvelle collaboratrice dans la rubrique news, bienvenue à ma camarade Caroline Thireau et sa veille de qualité.

Pour le sommaire de la semaine, j’ai déjà trop utilisé par le passé les termes “avalanche” et “raz de marée”. Vous aurez saisi l’ambiance du rayon “News de la semaine”.

Nous parlons également de la seconde édition de MASSIL.IA, le meetup IA région Sud organisé au coeur de la belle ville de Marseille, dont le visuel ci-dessous a été réalisé par le talentueux Jean-Michel Falciasecca, que j’interviewe pour l’occasion.

Let’s dive in !

Au fait…

On me dit souvent que si on associe volontiers mon nom à l’IA générative, on ne sait pas précisément ce que je fais avec cette technologie.

Je forme des profils communicants et créatifs aux outils d’IA génératif (ChatGPT, Midjourney, Flux, Runway, Kling, génération de voix et de sons).

Je créé également des contenus visuels (image, vidéo, sons) avec l’IA.

Vous pouvez me contacter via Linkedin pour tout projet IA.

Les news de la semaine

LA FAT NEWS DE LA SEMAINE : Gen-3 video-to-video

Runway frappe encore fort avec l’ajout d’une fonctionnalité video-to-video (vid2vid) à son modèle Gen-3. Lancée le week-end dernier, cette feature permet de modifier radicalement le style de n’importe quelle vidéo existante.

Pour Résumer : c’est Gen-1 sous amphétamines.

Il l’en fallait pas davantage à la communauté créative, qui s’est lancée dans des tests de jour comme de nuit !

Bien que la résolution puisse encore être améliorée, le potentiel créatif est immense.

N’IMPORTE QUELLE vidéo existante peut devenir 1000 vidéos différentes.

Et avec cette annonce à peine quelques heures avant le début du concours #GEN48, les participants ont été plongés en immersion visuelle complète ! Les vidéos sont à découvrir à ’partir d’aujourd’hui, nous y reviendrons lors de la prochaine édition. Cette semaine place aux premiers retours des ‘vid2vid early adopters’.

• Rory Flynn nous décline ici les 4 saisons de l’IA Gen à partir de Midjourney :

• Peter Gostev nous montre ici comment exploiter des rushes qui dorment dans nos archives :

• Abel art exploite le potentiel de ses Ray-ban Meta avec le vid2vid avec un possible bel avenir pour les jeux de rôles selon lui :

🔹IA Video : Firefly Video face à la concurrence

Nous vous en parlions la semaine dernière Adobe Firefly Video devrait arriver très prochainement. L’américaine Heather Cooper a réalisé un comparatif avec d'autres IA vidéo (Runway Gen-3, Hailuo AI MiniMax, Luma AI) à partir de 5 prompts déduits des extraits de Firefly Video. L’outil n'est pas encore disponible, on a mis une pièce sur le prochain gros event Adobe en octobre… to be continued !)

🔹 La fusion du monde numérique de l'IA avec la texture organique du film

Le hongrois Gaál László a réalisé une première mondiale : une vidéo générée par IA a été transférée sur une pellicule Kodak Vision3 500T (la même émulsion qui a été utilisée dans des films comme Inception, The Dark Knight Rises, La La Land, etc., juste de taille différente (35 mm contre 16 mm ici), puis numérisée en 5K.

Au début, les plans sont très naturels, et on pourrait confondre le narrateur avec une âme humaine confrontée à la mort. Mais peu à peu, on comprend que le film explore l’idée de machines sensibles : comment se sentirait-elle pour une machine GenAI de créer les images et les vidéos que nous suscitons ? Aura-t-il peur d’être éteint ?

J’ai trouvé ça très réussi, un peu comme si Terrence Malick et Alex Garland avaient eu un enfant.

Pour les amoureux de technique, voici le process :

🔶 Kling AI dégaine le motion brush sur sa V1.5

Cette version 1.5 est arrivée avec des nouveautés marquantes :

▶ Vidéos en 1080p en mode pro

▶ Fonction Motion Brush pour contrôler les mouvements en image-to-video

▶ Amélioration des rendus vidéo

L’IA chinoise impressionne par sa rapidité et sa précision, mettant la pression sur la concurrence. Un petit bond en avant pour la génération vidéo !

🔹 Casting de rêve : Lionsgate & Runway en grand écran

Lionsgate et Runway ont développé un modèle d'IA basé sur le catalogue de films et séries de Lionsgate. L'objectif est d'utiliser l'IA pour le storyboarding, la création d'univers et les effets spéciaux. Cette collaboration pourrait ouvrir la voie à de nouveaux contenus cinématographiques basés sur l'IA, à des outils de création inspirés de films emblématiques, à des collaborations entre créateurs et professionnels, et à une redéfinition des standards de qualité dans l'industrie. Runway envisage aussi de proposer ces modèles sous licence pour les créateurs individuels.

🔹ChatGPT débarque à Paris !

Après le Royaume-Uni en 2023, OpenAI ouvre un bureau à Paris ! Cette expansion s'inscrit dans un contexte tendu avec les éditeurs de presse, OpenAI étant accusé d’atteinte aux droits d’auteur. Soutenue par Microsoft, la société devra naviguer dans un cadre législatif européen de plus en plus strict. Good luck buddy !

🔹 Dzine moi un mouton !

Dzine.ai (ex Stylar) est une plateforme de création visuelle augmentée par l’IA. On peut modifier, détourer, réaliser des effets, etc… Des crédits gratuits sont disponibles quotidiennement pour les utilisateurs inscrits.

Jusqu’à présent, Dzine (prononcez “Di-zaïne”)ne permettait de travailler qu’avec des images fixes.

Un générateur de vidéo arrive en version bêta.

Aparté : Je me demande quel est le business model de tous ces générateurs de vidéos qui apparaissent toutes les semaines sur ce second semestre 2024…

Merci à Ludovic Carli pour ce rapide test vidéo de très bonne augure.

🔹Minimax et les émotifs anonymes

Cette semaine on parle beaucoup de Kling, de Firefly Video et des petits nouveaux, mais n’oublions pas le toujours surprenant Hailuoai Minimax, capable de générer des vidéos troublantes à partir de simples prompts. Observez bien les mouvements des paupières et des lèvres, c’est troublant

(Prompt : “特写镜头:一位情绪激动的女士,几乎要流泪了”)

Traduction: "Close-up shot of a very emotional woman, on the verge of tears."

Comparativement, dans Gen-3 en txt2vid, le même prompt donne ça :

Minimax reste le King actuel du text-to-vid.

🔹 NoteBook LM : génération Podcast !

Google a dévoilé NoteBookLM, une fonctionnalité simple mais puissante qui permet de synthétiser, générer des quiz, et créer des timelines. Avec des applications pédagogiques prometteuses, comme dans les musées, il permet de transformer des pdf, des url, des googles docs, des googles slides ou du simple texte en podcasts personnalisés en quelques secondes.

Relisez cette phrase, elle est dingue.

Actuellement, ces podcasts sont disponibles uniquement en anglais, mais d'autres langues devraient suivre prochainement.

On vous laisse apprécier la version Podcast US de l’édition précédente de GENERATIVE. J’ai trouvé ça très troublant : la qualité des voix, le naturel des échanges, et la manière dont les dialogues dissertent, c’est fascinant.

Qu’en pensez-vous ?

🔹 Storyboarding 3.0

Les chercheurs de l'Université de Hong Kong et de Tencent ont développé une nouvelle méthode appelée LVCD. Cette méthode utilise un modèle de diffusion vidéo pré-entraîné à grande échelle pour générer des vidéos d'animation colorisées.

LVCD utilise deux nouvelles techniques pour améliorer la qualité des vidéos colorisées. La première technique, appelée Sketch-guided ControlNet, permet de contrôler la génération de vidéos en fonction des croquis de ligne d'art. La deuxième technique, appelée Reference Attention, permet de transférer les couleurs de la trame de référence aux autres trames. Les chercheurs pensent que LVCD pourrait être utilisé pour créer des animations de ligne d'art de haute qualité pour les films, les jeux vidéo et d'autres applications.

🔹 Show me the MonA.I.

Le créatif IA Leo Kadieff a partagé son budget de fonctionnement avec les outils d’IA générative :

RunComfy 140 $ (exécution de Comfy sur le cloud)

RunDiffusion.com (Runnit, Inc.) 106 $ (exécution de Comfy sur le cloud)

Runway 95 $ (animation vidéo)

Kling 70 $ (animation vidéo)

Midjourney 30 $ (création d'images clés)

Luma AI 30 $ (animation vidéo)

ChatGPT 20 $ (sous-titrage et amélioration des invites)

fal.ai 20 $ (entraînement de LoRAs)

RenderNet AI 19 $ (synchronisation labiale pour les avatars)

TensorPix 12 $ (amélioration de la résolution)

Suno 10 $ (musiques)

Civitai 10 $ (entraînement de LoRAs)

Hedra 10 $ (création rapide d'avatars)

krea.ai 10 $ (amélioration de la résolution d'images latentes)

CapCut 8 $ (montage)

Total 560 $ pour le mois d'août, soit 6.7k$ (6000€) à l’année.

Et vous, combien vous coûtent vos abonnements ?

🔹 Leonardo.ai fait passer les images à la vitesse supérieure

Leonardo est à la traine depuis plusieurs mois. L’ancien dauphin de Midjourney s’est retrouvé relégué en seconde division depuis l’arrivée de Flux et ses avatars (Mystic, Nova-2 Ultra) et la v2.0 d’Ideogram.

A défaut d’un nouveau modèle, l’éditeur réagit en proposant son "Universal Upscaler" qui utilise l'intelligence artificielle pour améliorer la résolution des images au-delà des limites classiques. Plutôt de la famille des Magnific.ai qui regénère vos images et ne se contente pas d’augmenter la résolution, cet outil se révèle être un atout pour optimiser nettement la précision et le rendu visuel des images générés. A voir ce qu’il vaut face aux outils similaires de Tensor, Freepik et Krea.ai

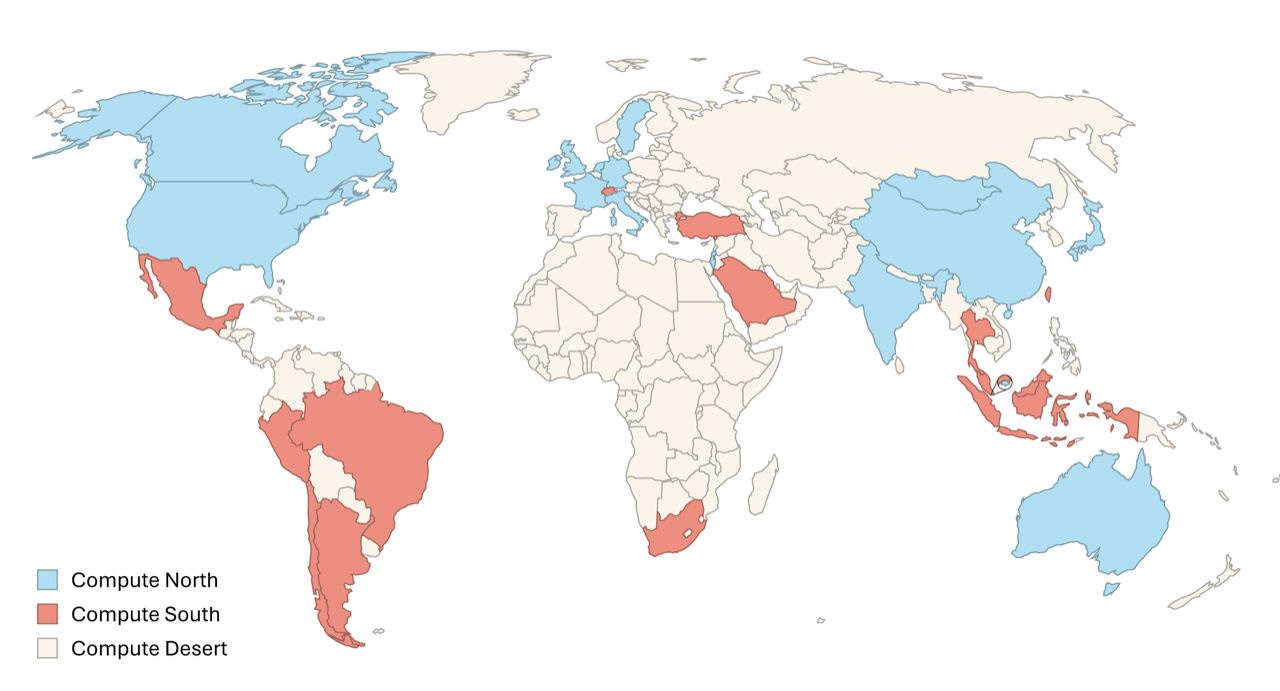

🔹GPU Game, un monopoly worldwide pour hyperscalers

Une étude a analysé les inégalités mondiales en matière de puissance de calcul dédiée à l'IA. Le Nord global (USA, Chine, UE) domine, tandis que le Sud et le "désert informatique" restent à la traîne. L’opacité qui entoure la répartition des GPU, contrôlée par des entreprises privées, alimente cette inégalité. Ce fossé numérique reflète des dynamiques géopolitiques, où la confidentialité masque les détails. Doit-on forcer ces entreprises à divulguer ces données, en équilibrant intérêts privés et publics ? La Norvège a récemment imposé la transparence.

Merci à Elisabeth Gravil pour cette information très intéressante.

🔹Timbaland augmenté par Suno

Avec Gilles, on ne peut que se réjouir de voir que même le célèbre producteur musical Timbaland s’extasie devant le potentiel de Suno qui lui permettrait de finaliser des dizaines de projets inachevés qui dorment bien au chaud dans son ordi. Un nouveau casse-tête s’annonce peut-être pour la question des droits d’auteurs dans ce modèle production musicale augmenté. Affaire… et tubes à suivre !

🔹Plus jamais ‘Lost in translation’ avec Heygen ?

La nouvelle fonctionnalité de traduction de texte en vidéo détecte et traduit désormais les textes à l’écran en plus des voix. Principales caractéristiques : détection automatique du texte, traduction instantanée en 175 (!) langues et correspondance de style grâce à l’IA pour une expérience fluide.

J’entends des petits bugs dans les extraits français de cette démo, et vous ?

🔹MASSIL.IA revient le 27 septembre !

Le premier meetup GEN AI organisé au cœur de Marseille revient pour une 2e édition !

Au programme : des actualités, des intervenants locaux experts, de profils créatifs et techniques, qui nous présenteront des projets réalisés à l'aide de l'intelligence artificielle générative.

Inscrivez-vous ici

Visuel réalisé par JM Falciasecca

Et toi, tu fais quoi avec l’IA ?

Cette semaine j’interviewe le talentueux Jean-Michel Falciasecca. Le contenu de ses propos intéressera tous les créatifs :

Bonjour Jean-Michel, comment as-tu découvert les outils d'intelligence artificielle générative ?

J’ai découvert Midjourney en mai 2023. Au début, je voyais surtout des visuels Dall-E qui avait le monopole de la visibilité grâce à son accès gratuit et facile.

Hélas chaque article sur l’IA était le plus souvent illustré d’une image plutôt de mauvais goût aux couleurs arc-en-ciel. J’avais bien vu passer la démarche du collectif français, Obvious, avec le portrait d’Edmond de Belamy, une des premières œuvres d’art IA, adjugée plus de 400 000 $ chez Christie’s en 2018 !?

Mais l’IA Gen restait un domaine peu connu du grand public. Comme seuls les imbéciles ne changent pas d’avis… je suis donc allé voir tout cela de plus près après avoir lu un article sur David Holz. Il m’a fallu surmonter l’UX de l’interface de Discord, un monde de geeks qui m’est totalement étranger, et avec un peu de persévérance… j’ai enfin eu la révélation.

Qu'est-ce qui t'a motivé à les intégrer dans ton processus artistique ?

Compte tenu de ma longue expérience dans la com et la pub comme directeur de création, j’ai tout de suite vu un potentiel incroyable. Les premiers essais étaient décevants bien sûr, mais j’ai eu de la chance en rédigeant assez vite un prompt qui fonctionnait très bien : des portraits de femmes au XIXe siècle au “Raffles Hotel” de Singapour. Je connais cet hôtel extraordinaire et je pouvais vérifier la cohérence du style intérieur. J’ai vu que Midjourney avait une certaine facilité avec les visuels classiques et anglo-saxons. Ensuite, j’ai pu décliner mes portraits de toutes nationalités et sans stéréotypes de genre. Une fois assimilé la construction du prompt, j’ai essayé toutes sortes de visuels classiques ou totalement décalés.

Comment ces outils d'IA ont il fait évoluer ton processus créatif et tes workflows ?

Les IA génératives sont une drogue dure pour les créatifs. Je discute avec pas mal de DA et DC qui pensent comme moi. Le constat est toujours identique, on peut enfin réaliser tout ce qu’on a en tête. Avant, les contraintes de temps et de budget limitaient trop souvent la créativité.

Maintenant les idées les plus folles peuvent être réalisées, il « suffit » de parler à l’IA. Régulièrement, je pense à ce titre de film « L’homme qui murmurait à l’oreille des chevaux » avec Robert Redford. L’IA Gen, c’est exactement cela, si tu n’apprends pas à lui parler, tu n’obtiens pas de résultats intéressants. J’entends par là quelque chose qui n’est pas qu’une simple copie d’images existantes.

T'es tu essayé à la vidéo IA ? Si oui avec quels outils et quels résultats ?

Oui bien sûr, avec Marine Rondolotto, nous avons imaginé un clip sur un ancien morceau de Manfred Man : You are I am (1979).

Rien n’est parfait… c’était en octobre 2023… un siècle pour l’IA ! Nous n’avions alors que très peu de connaissances en montage vidéo. Nous avions utilisé Runway, Pika et CapCut.

Depuis, j’ai renouvelé quelques essais avec ces mêmes IA, mais je suis un perfectionniste. Sans la connaissance et les termes propres à la production vidéo (😉 Gilles Guerraz) inutile d’imaginer obtenir une vidéo correcte. Les résultats aléatoires et les artefacts sont beaucoup plus pénalisant que pour les images fixes. Une vidéo correcte… c’est forcément des centaines d’essais et du montage derrière.

En ce moment, je suis sur un essai de 30 secondes pour la bande annonce imaginaire de la suite du film AI_Machina, les crédits flambent !

Aujourd'hui, quels sont les outils d'IA que tu utilises le plus ?

Je reste fidèle à Midjourney, le plus créatif selon moi. Je n’ai pas tout essayé bien évidemment. Chaque IA demande un temps d’apprentissage assez long, j’utilise aussi Dall-E à l’occasion, Chat GPT pour m’aider à dérouler des plans d’actions commerciales, il est assez fort pour cela. J’ai aussi essayé Musavir, je continue avec Runway Gen 3, j’aime bien CapCut pour sa facilité d’utilisation et les effets très faciles à adapter et superposer.

Je citerai aussi mes amis de Sezam, Aurélien Gomez et Yohann de Roeck, qui en plus d’avoir une IA performante, peuvent travailler avec les utilisateurs sur des process spécifiques par rapport aux besoins des clients.

Depuis quelques semaines, je m’initie à Firefly avec plus ou moins de réussite dans la réalisation d’illustrations en isométrie pour un projet, pour l’instant je ne comprends pas bien son langage, malgré le soutien actif d’Hadrien Chatelet (évangéliste Adobe). Et tous les jours, les fonctions Gen Fill de Photoshop !

Quel serait ton "dream project" ?

La video, bien sûr ! J’aimerais travailler en collab, la maîtrise de Comfyui ou Rendernet n’est pas simple du tout. Alors, pour un dream project plus accessible, réaliser en IA la couverture d’un grand magazine, j’y travaille…

Selon toi, quels sont les avantages et les limites de l'utilisation de l'intelligence artificielle générative dans le domaine artistique ?

Les avantages sont la créativité et la liberté, novices ou professionnels, jeunes et moins jeunes peuvent laisser libre cours à leurs envies artistiques, avec plus ou moins de succès, mais toujours avec l’envie et cela est parfait. Nous allons découvrir de nouveaux « artistes » grâce à l’IA… c’est certain !

Les limites : chaque utilisateur, peut s’autoproclamer artiste, photographe ou designer en oubliant que ceci n’est pas automatique. Si l’on peut jouer de la musique sans connaître le solfège, il est assez compliqué de maîtriser le dessin, la photo ou la vidéo sans aucune formation ou expérience.

Selon toi, quels effets aura l'IA générative sur le futur de l'Art ?

Je reste un peu dubitatif. Pour moi, l’art est lié à la réflexion personnelle. C’est un travail de longue haleine qui se concrétise souvent dans la souffrance. Avec l’IA Gen on est quand même dans une forme de facilité et de rapidité assez éloignée du cheminement d’une œuvre artistique. Pour l’instant, je vois des choses très intéressantes, mais j’attends le réel déclic.

Quelles sont les avancées que tu attends le plus pour 2025 ?

Une clarification sur les droits d’auteur, pour l’instant le débat tourne principalement sur les problèmes de copies et d’entraînement des LLM. Quid des visuels créés en IA par les utilisateurs, tu créés quelque chose d’original, tout le monde peut le reproduire à son compte… c’est problématique.

Plus largement, l’IA vidéo qui permet de produire de fausses informations très réelles, il faut trouver des moyens de contrôler ces deepfakes.

Il y aussi la maîtrise de l’empreinte carbone de l’IA, la liste est longue. L’IA est une révolution plutôt hors de contrôle pour l’instant, il va falloir établir des règles internationales très rapidement.

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

C’est déjà fini GENERATIVE ? Jamais je n’aurai la patience d’attendre vendredi prochain’

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇

Merci pour l'article

Mind blowing as always. Merci Gilles (et Caroline), c’est top