Salut les prompteurs du cadre, les vidéastes augmentés, les enthousiastes de la mise en scène virtuelle et les curieux de l’image mouvante, bienvenue dans cette 67e édition de GENERATIVE, la newsletter qui vous présente l’actu internationale de l’intelligence artificielle générative.

Cette semaine, une accélération de news comme on en avait plus eu depuis… la semaine dernière ! Le running gag court de plus en plus vite, tout ça donne le tournis, je rédige ces mots mercredi avec l’anxiété du gardien de but au moment du penalty.

Vais-je pouvoir boucler vendredi ? Ou alors Veo, Sora et GPT-5 vont sortir dans l’intervalle ? Dois-je sniffer du café bolivien ? Me faire une perfusion de Guronzan ? Puis-je écrire en dormant ? L’IA peut-elle le faire à ma place ?

Autant de questions auxquelles je n’ai pas la réponse.

En attendant le sommaire, pensez à vous abonner si ce n’est déjà fait :

Dossier sur Luma Dream Machine, probablement la plus grosse sortie video IA de l’année, en attendant celle de Sora.

Retour sur Apple Intelligence : l’IA débarque dans vos iPhone et dans vos Mac

De l’IA dans la pub : ma dernière pub avec de l’IA dedans

Et au milieu, une avalanche de news essentiellement centrée sur la génération de vidéos et d’images.

Let’s go !

MASSIL.IA

Pour rappel, je co-organise MASSIL.IA un meetup IA à Marseille le mardi 25 juin prochain. Le cadre est idyllique : il s’agit du Riality Lab, à l’intérieur du Palais de la Bourse, sur la Canebière, à quelques dizaines de mètres du Vieux Port. Je ne pouvais pas rêver d’un endroit plus central et plus prestigieux pour ce 1er meetup !

Au programme, des news, des surprises et des intervenants de la région Sud qui viendront nous parler d’IA sous deux axes :

- Créatif

- Tech

Au fait…

On me dit souvent que si on associe volontiers mon nom à l’IA générative, on ne sait pas précisément ce que je fais avec cette technologie.

Je forme des profils communicants et créatifs aux outils d’IA génératif (chatGPT, Copilot, Midjourney, Firefly, Génération de vidéo, génération de voix et de sons).

Je créé également des contenus visuels (image, vidéo, sons) avec l’IA.

Si vous voulez travailler avec moi, envoyez moi un mail à : gilles.guerraz@nextrend.fr

Ou contactez moi via Linkedin.

Les news de la semaine

Une fois n’est pas coutume, je démarre par un dossier sur LA grosse news de la semaine, sous forme d’un journal de bord démarré mercredi soir.

A new Sheriff in town ?

Le monde de la génération vidéo IA est en ébullition. Alors que Les outputs aléatoires de Gen-2 commencent à lasser, que Pika annonce un update (+ de détails plus bas), que certains impatients cherchent des cartes SIM chinoises pour pouvoir accéder à Kling, et que l’attente de Sora devient interminable, voilà qu’un nouvel inconnu débarque sans crier gare.

Il s’agit de Dream Machine, par LumaLabs, une startup connue pour sa maitrise de la technologie NeRF, qui permet de simulant le monde réel en 3D.

Indispensable pour créer des vidéos qui intègrent la physique pour des éléments tels que le mouvement, les directions, etc.

La promesse de Dream Machine: générer 120 frames en 120 secondes, avec un niveau de qualité inégalé sur le marché. La résolution des vidéos est de 1280x720 pixels et la durée des clips est de 5 secondes.

Voici la démo :

AVIS A CHAUD

On pourrait faire la fine bouche et trouver des choses à redire à cette démo : “pas aussi réaliste que Sora”, “C’est un peu court jeune homme”, etc…

L’explorateur video IA “Uncanny Harry” a publié un de ses premiers essais sur Twitter mercredi soir. Regardons ça :

En sortant la loupe, j’ai l’impression d’être plutôt face à un super Runway que face à un Sora killer. Un Gen-2 bien upscalé, avec une bonne cohérence spatiale. Mais on n’est pas dans le quasi-photoréalisme proposé par Sora.

En cherchant quelque chose de plus convaincant, je suis tombé sur ce teaser de film IA réalisé avec Dream Machine :

Alors évidemment, ça reste impressionnant.

Mais comme on n’est pas là pour niaiser comme on dit outre Atlantique, il convient de garder les idées claires et de rester objectif :

A première vue, Dream Machine c’est très joli, mais c’est comme si on était toujours du même côté de la rivière que Runway, Pika et Haiper.

Sora, Kling et Veo eux, sont de l’autre côté.

Comme j’ai pu le lire quelque part sur le net :

“Si Sora est chatGPT4, amors Luma est chatGPT 3.5”

La bonne nouvelle, c’est que Dream Machine est ouvert à tous (30 vidéos gratuites)

La mauvaise nouvelle, c’est que Dream machine est ouvert à tous.

Et que les serveurs sont actuellement à plat ventre sous les dizaines de milliers de requêtes d’utilisateurs enthousiastes impatients.

J’ai lancé une requête il y a 3 heures. Encéphalogramme plat pour le moment.

Je glisse ici que l’interface est simple et agréable. “Très Straightforward” comme disent les Franglais. Encore plus épuré que chatGPT.

AVIS A FROID

[UPDATE] La nuit est passée, voici mes résultats en prompt-to-video :

Prompt : “A cinematic shot of a female dancer floating in the air in slow motion, shot on Arri Alexa”

Ah, tout de suite, on rigole moins.

On pourrait tirer des conclusions hâtives et en déduire que Luma sera plus à l’aise dans l’exercice de l’image-to-video que dans celui du prompt-to-video, contrairement à ce qui été dit de Sora.

Je me suis dit que peut-être que Luma n’aimait pas les prompts courts alors j’ai recyclé un des prompts de Sora :

Prompt: A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about.

Le résultat est plutôt pas mal du tout (Pas au niveau de celui de Sora, pour mémoire :)

J’ai ensuite exploré le mode image-to-video en utilisant des images générées avec Midjourney :

Deux choses à retenir de cette vidéo. Les 2 premières secondes sont d’une grande qualité pour 2 raisons :

- excellente cohérence spatiale (pas de déformation ni du personnage ni du décor)

- Le mouvement de caméra est parfaitement fluide en dépit d’un décor chargé

La suite de la vidéo est inférieure, avec une accélération du travelling ainsi qu’une déformation du personnage avec une animation disgracieuse. Mais pour un 1er essai, c’est plutôt concluant.

Pour ce packshot, le résultat est impeccable de bout en bout. Il s’agit d’une image Midjourney agrémentée d’un prompt simple : “ A professional perfume packshot, the ripple trembles on the surface of the water.”

J’ai fait beaucoup d’autres essais que je vous partagerai dans la prochaine édition, et/ou sur Linkedin.

Parce que je sais que vous aimez les comparatifs, je vous propose cette vidéo publiée par Curious Refuge.

Ce qu’il en ressort :

De bien meilleures capacités d’animation chez Luma que chez ses prédécesseurs. Les personnages se déplacent (parfois un peu trop), la caméra bouge, le résultat ressemble de moins en moins au style “photo animée” auquel Runway et Pika nous avaient habitués.

Je ne serais pas étonné que, dans les prochaines semaines, le recette secrète consiste à mélanger habilement des générations Luma avec des générations Runway (ou Haiper ou Stable DIffusion Video, qu’il ne faut pas oublier non plus).

Et on a side note, je ne serais pas étonné non plus si les équipes de Midjourney étaient en train de travailler sur un générateur de vidéo au moins aussi performant que celui de Luma. Mais halte aux spéculations, wait and see.

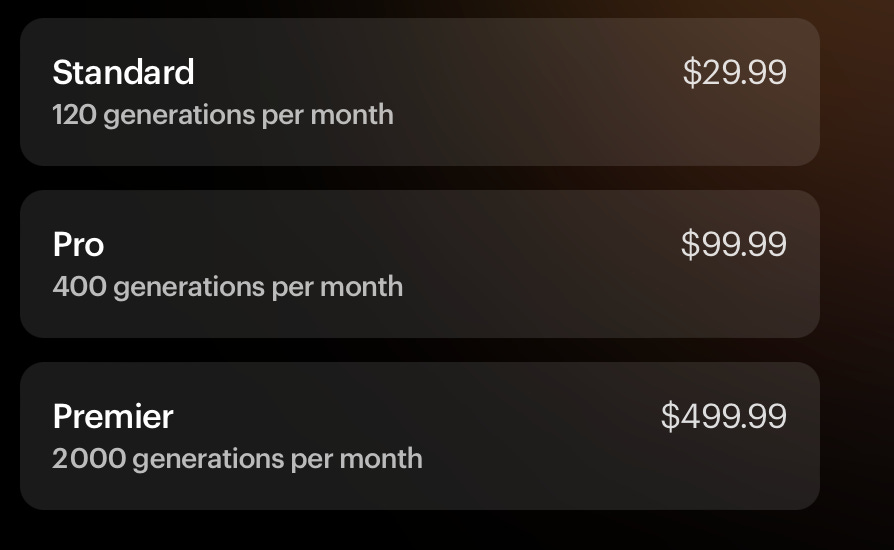

Pour terminer, l’app est accessible gratuitement pour 30 crédits (30 générations de vidéo) moment mais comme toutes les bonnes choses ont une fin, voici le pricing plan :

Voilà de quoi désengorger les serveurs et faire refroidir la température des GPU.

Quoi qu’il en soit, cela faisait longtemps que nous n’avions pas eu autant de news significatives dans la même semaine. Et ceci n’est que le début.

Accrochez vos ceintures.

C’est parti.

Krea Video upscaler

Krea.ai n’en finit plus de sortir des updates et propose cette semaine un upscaler de vidéo. L’outil gère différentes résolutions d’image et les fréquences d’images allant jusqu’à 120 images par seconde, pour des grooooos ralentis.

Pika 3.0 ?

Avec l’arrivée de Dream Machine, les concurrents se doivent de réagir. Pika a présenté une update, dont la démo est à prendre avec des pincettes tant leurs vidéos ont tendance à légèrement enjoliver la réalité. Regardons :

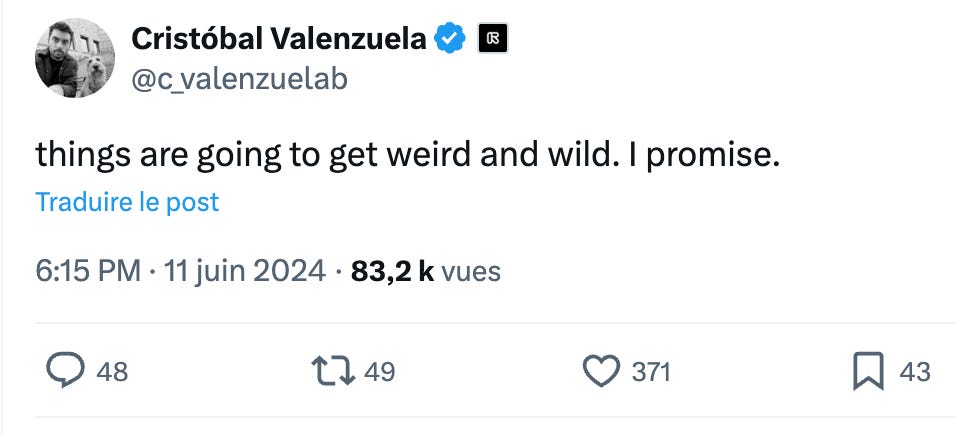

Pendant ce temps là, Cristobal Valenzuela, le CEO de Runway, tease la foule sur son compte Twitter. Runway serait sur le point de sortir une GROSSE update :

Ces 2 acteurs historiques de la génération de vidéo AI sont au pied du mur : ils doivent se réinventer ou disparaitre face à Dram Machine ou à la sortie officielle de Sora ou d’un de ses équivalents chinois. Le gap de qualité sera trop grand pour laisser la place au doute.

Dans le décor

Et pendant que certains ne parlent que de Sora, Kling et Luma, d’autres injectent de l’IA dans la vidéo de manière différente et convaincante, comme Claire Xue qui édite des arrière-plans générés par l’IA dans des vidéos tournées sur sa terrasse. Ce clip de sept secondes a nécessité près de deux jours de production à deux personnes, en utilisant des outils tels que Midjourney Photoshop, After Effects, Premiere Pro et Runway Gen-2.

Ça y est, on peut parler d’autre choses que de vidéo ?

Better, Faster, Stronger

L'Union européenne, malgré un discours ambitieux, reste à la traîne en matière d'investissements en intelligence artificielle (IA), selon un rapport de la Cour des comptes européenne. Le suivi insuffisant des projets financés, l'absence de gouvernance adéquate et une tendance à la sur-réglementation sont soulignés. Cette situation limite la compétitivité européenne dans un domaine dominé par les États-Unis et la Chine, appelant à une nécessaire révision des stratégies pour stimuler l'innovation et attirer les investissements dans cette course internationale à l’IA.

Big Three

OpenAI, Microsoft et Oracle ont formé un partenariat pour améliorer la puissance de calcul derrière ChatGPT. OpenAI utilisera l'infrastructure d'Oracle en parallèle de la plateforme Azure AI de Microsoft pour faire évoluer ses services. Cette collaboration permet à OpenAI d'étendre ses capacités de calcul tout en maintenant sa relation stratégique avec Microsoft, son principal investisseur.

Samsung et l’IA

Samsung lance une offensive dans le secteur des puces d'IA avec une nouvelle roadmap de fabrication, des technologies de pointe et une plateforme "clé en main" pour les solutions de puces d'IA. L'entreprise vise à concurrencer TSMC en améliorant les performances de ses puces et prévoit une forte croissance de sa clientèle et de ses revenus d'ici 2028. Pour renforcer son expertise, Samsung a recruté Murat Akbacak, ancien d'Apple, pour diriger un nouveau centre d'IA en Amérique du Nord. C’est la guerre course !

Londres, Stranger Things et Midjourney

L’artiste IA Vincent Smajda, a.k.a. “if Only” a réalisé la dernière campagne d’affichage Netflix à Londres pour promouvoir la 5ème saison de Stranger Things ! Vincent précise que cette série “très ambitieuse a demandé beaucoup de persévérance, de patience et d’imagination intense”.

Leonardo dégaine les typos

Le générateur d’images Leonardo a sorti un nouveau modèle appelé “Phoenix”.

Il n’est pas mauvais avec les typos (image non retouchée)

J’ai été moins convaincu par la qualité globale des images, comparée à celle obtenue avec les autres modèles de Leonardo. “Pas de quoi appeler la famille” en somme.

Sur X (Twitter), ça jase pas mal (attention, couchez les enfants)

SD 3 Medium

Stability AI annonce Stable Diffusion 3 Medium, un modèle de 2 milliards de paramètres, qui revendique une qualité et un réalisme améliorés dans les images générées, notamment pour les mains et les visages. Il comprend une meilleure interprétation des instructions, d'excellentes capacités typographiques et fonctionne efficacement sur les GPU standard.

Du coup j’ai eu envie de tester avec le même prompt que celui utilisé avec Leonardo

On est un peu mieux sur le graphisme mais pas au top sur les typo, pas vrai mes abonines ?

Vous pouvez également tester Stable Diffusion 3 ici. Il faut sortir la carte bleue mais il y a un essai gratuit de 3 jours. Après ça démarre à 9$/mois.

Update Midjourney

Midjourney vient de sortir une “fonction de personnalisation des modèles”.

Midjourney apprend vos préférences à partir de vos votes et de vos likes sur la page d'exploration. Pour que cela fonctionne, vous devez avoir environ 200 interactions. Pour activer cette personnalisation, ajoutez simplement "--p" à la fin de votre prompt ou activez-la dans les paramètres. .

Lorsque vous activez la personnalisation, vous obtenez un « code » ajouté après vos prompts, vous pouvez partager ce code pour dupliquer l’effet de personnalisation à d’autres images.

Il est possible de contrôler l’intensité de l’effet de personnalisation en utilisant (Min 0, Max 1000, 100 est la valeur par défaut).

Notez que cette fonctionnalité est expérimentale et peut évoluer les mises à jour de l'algorithme

Parmi les autres news de cet update Midjourney :

Les outils ‘Pan’ et ‘Zoom’ sont désormais unifiés et s’appellent ‘Reframe‘

L’outil ‘Remix’ se trouve désormais dans l’outil ‘Reframe‘. Cela vous permet de modifier le prompt lors d’un panoramique ou d’un zoom.

L’outil « Vary Region » s’appelle désormais “ Repaint “

Source : Discord Midjourney et Geniart.

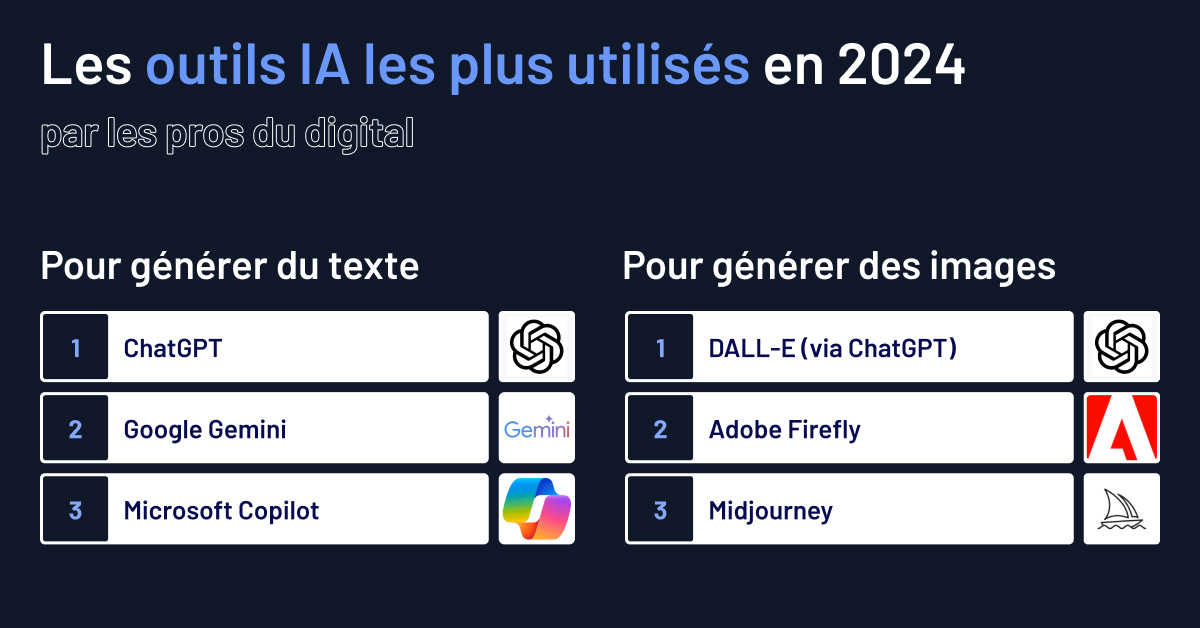

Les utilisateurs de l’IA parmi les “pros du digital”

Une enquête BDM auprès de 1045 professionnels du digital révèle que ChatGPT domine largement le marché des générateurs de texte par IA, utilisé par 73,5% des sondés. DALL-E, également développé par OpenAI, est le générateur d'images le plus populaire. Cependant, près de la moitié des professionnels n'utilisent pas encore de générateurs d'images, et l'adoption d'autres types d'IA générative, comme la vidéo ou le code, reste faible.

Apple Intelligence

Du 10 au 14 juin dernier a eu lieu la très attendue “Worldwide Developers Conference” (WWDC) durant laquelle Apple a présenté son "Apple Intelligence".

Cette annonce a suscité un vif intérêt marqué parmi les fans de la marque, les geeks de l’IA générative (je me place dans cette catégorie) et dans la communauté technologique en général, promettant une avancée significative dans l'intégration de l'intelligence artificielle au sein de la gamme de produits Apple.

Au cœur de cette annonce se trouve l'introduction de fonctionnalités IA à travers tout l'écosystème Apple, avec une attention particulière portée à iOS 18, qui sera lancé officiellement en septembre prochain (une bête circule depuis le 10 juin).

Prévues pour une intégration progressive jusqu'en 2025, ces avancées seront exclusivement disponibles sur les modèles récents comme l'iPhone 15 Pro et les appareils équipés de puces M1 et postérieurs.

Ces avancées sont destinées à dessiner dès aujourd’hui le futur des interactions homme-machine, en proposant des expériences plus intuitives et fluides. Il est à noter que les initiatives IA d'Apple ne se limitent pas à l'amélioration des capacités existantes, mais visent également une intégration plus profonde de l'IA dans les fonctionnalités quotidiennes des appareils.

iOS 18, au centre des attentions lors de l'événement, devrait introduire des fonctionnalités avancées propulsées par l'IA, à commencer par une refonte totale de Siri, le célèbre assistant virtuel d'Apple. Ces améliorations visent à rendre Siri plus réactif et capable de gérer des requêtes plus complexes. Il faut imaginer un chatGPT4-o dans son iPhone.

Un autre objectif de l'intégration de l'IA dans iOS 18 est d’améliorer l'interaction utilisateur à travers des réponses plus personnalisées et contextuellement adaptées.

Ce Siri 2.0 devrait comprendre et exécuter des commandes complexes comme résumer des notes, effectuer des recherches internes détaillées, ou gérer des interactions inter-applicatives complexes.

C’est à mon sens l’un des points les plus enthousiasmants dans le cadre d’une optimisation des tâches quotidiennes : “Dis Siri, cherche dans mes SMS l’heure d’arrivée du train de maman et commande lui un taxi 5 minutes après l’heure d’arrivée de son train. Direction la maison”

Parmi les autres ajouts notables, on trouve des outils d'aide à la rédaction, capables de proposer des réécritures dans différents tons ou de générer des textes à partir d'instructions simples. L'IA pourra également filtrer et prioriser les notifications et e-mails, etc…

En termes de création de contenu, Apple introduit des fonctionnalités pour générer des images et des vidéos personnalisées, ainsi que pour enregistrer et transcrire des appels vocaux.

Cette suite d'innovations met en lumière la stratégie d'Apple de pousser les capacités de ses appareils tout en limitant l'accès à ces avancées aux utilisateurs des modèles les plus récents, une démarche qui pourrait renforcer son écosystème mais aussi exclure une part significative de ses clients actuels.

Enfin, avec l’IA de plus en plus omniprésente dans l’intégralité de nos données, la question du respect de la confidentialité se pose plus que jamais.

Et si vous préférez les récaps en vidéo, “I got you covered” comme on dit là-bas

De l’IA dans la pub !

Entre 2 projets IA, je réalise des films publicitaires dans lesquels j’essaye d’injecter de l’IA à chaque fois que c’est possible.

Vous vous souvenez probablement mes tentatives avec la campagnes Tediber en début d’année.

Et heureusement pour la suite de cet article, ce fut le cas avec ce film pour la MACSF, réalisé au mois de décembre dernier.

Ludovic Vossovic, le producteur du film, était ouvert à l'idée d'expérimenter l'IA générative pour les effets spéciaux visuels de ce film. (Le concept créatif étant une personne âgée qui dialogue avec une photo de lui-même plus jeune).

Sur le plateau, nous avons enregistré la voix du comédien Jean-Paul Dix en essayant d'obtenir une tonalité moins grave que celle de sa voix actuelle, pour la rajeunir en prévision du trucage.

Jean-Paul nous a ensuite envoyé plusieurs photos de lui plus jeune, que j’ai essayé d’animer avec différents outils d’IA générative, avant de choisir D-ID, qui proposait à l'époque une meilleure synchro labiale que Heygen et consorts.

J'adore ce type d'expérimentations, à la croisée de mes expertises audiovisuelles et avec les outils d'IA générative.

Cette édition est terminée, merci de l’avoir lue jusqu’ici ! Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇