De l'empathie des chatbots modernes

Salut les humains, les robots, les cyborgs, les chatbots, les androïdes, les rageux, les détendus, les augmentés et les ralentis, et bienvenue dans cette 57e édition de GENERATIVE, “toi même tu sais de quoi ça parle”, comme dirait mon clone.

Cette semaine nous revenons sur une avalanche de news immanquables, un focus sur Hume AI, l’autoproclamée “IA empathique” et et j’ai le plaisir d’interviewer Rémi Rostan, le créateur du magzaine LHC, réalisé à 99% avec l’IA.

Let’s go !

Un nouveau royaume ?

Apple a présenté ReALM, un nouveau système d'intelligence artificielle capable de comprendre les tâches à l'écran, le contexte conversationnel et les processus en arrière-plan. Cette approche innovante convertit les informations à l'écran en texte, permettant une IA plus efficace sur l'appareil. ReALM prend en compte à la fois le contenu affiché et les tâches actives, surpassant même GPT-4 malgré un nombre réduit de paramètres. Cette avancée majeure promet une expérience utilisateur prometteuse plus fluide pour le prochain Siri.

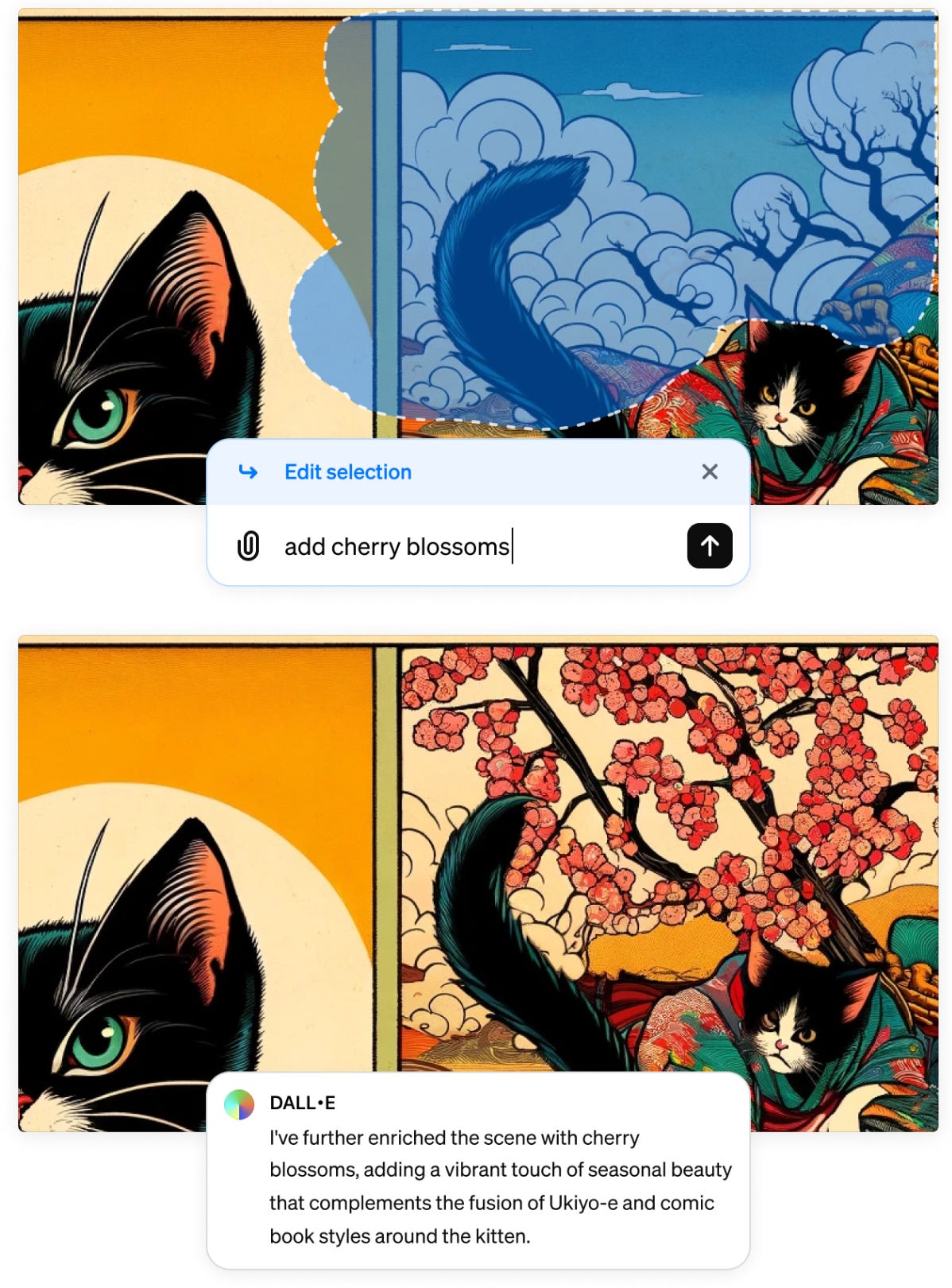

Inpainting dans DALL-E

OpenAI intègre une fonctionnalité d’inpainting dans DALL-E 3, permettant aux utilisateurs de personnaliser directement les images générées par l'IA. Cette fonction permet de sélectionner des zones spécifiques d'une image et d'y apporter des modifications, comme ajouter, supprimer ou modifier des objets et des caractéristiques. Une fonctionnalité attendue, présente depuis longtemps sur DALL-E 2.

GROK 2.0

Elon Musk a de nouveau secoué la toile en évoquant le chatbot Grok 2, suite au lancement de Grok 1.5. Ce dernier, déjà impressionnant en matière de codage et de mathématiques, laisse présager des avancées encore plus significatives. Le tweet de Musk suggère que Grok 2 surpassera toutes les IA actuelles, dans le style actuel de modération et de retenue du fondateur de Tesla.

Un clip avec Sora

L’artiste August Kamp a réalisé un clip avec Sora. Si les images sont aussi expérimentales que la musique, il est intéressant de présumer que Kamp a su s’approprier Sora pour exprimer sa vision et son style très personnels, loin des images de démo publiées par OpenAI.

Clonage Vocal

OpenAI a dévoilé “Voice Engine” sa nouvelle technologie capable de cloner une voix à partir d'un court échantillon, ce qui suscite à la fois enthousiasme et prudence. Consciente des risques de mauvaise utilisation, l'entreprise opte pour une approche mesurée en limitant pour l'instant l'accès à un groupe restreint de testeurs. Ce système promet d'innover dans l'assistance à la lecture, la traduction, l'amélioration des services, la communication non verbale et la récupération de la parole. OpenAI a intégré des mesures de sécurité telles que le marquage des contenus, la surveillance et le consentement explicite de l'orateur.

Stable Audio 2.0

Stability AI a publié une mise à jour de Stable Audio, son outil de génération musicale. C’est un modèle prompt-to-music formé avec des sons d’AudioSparx. Pour contrer l'usage de samples protégés, ils ont ajouté une reconnaissance de contenu qui bloque le matériel copyrighté. Astucieux et intéressant.

Et concrètement ça doit quoi ?

C’est inégal. Certaines générations inutilisables laissent à penser que le remplacement des musiciens par l’IA, c’est pas pour tout de suite. D’autres morceaux sont plus mélodieux. Je vous laisse juger.

Prompt : “Ambient Techno, meditation, Scandinavian Forest, 808 drum machine, 808 kick, claps, shaker, synthesizer, synth bass, Synth Drones, beautiful, peaceful, Ethereal, Natural, 122 BPM, Instrumental” (bof)

Prompt “Ambient house, new age, meditation, advertisement, 808 drum machine, 808 kick, claps, shaker, synthesizer, synth bass, soaring lead heavily reverbed, modern, sleek, beautiful, inspiring, futuristic” (pas mal)

Mais Stable Audio a une botte secrète. Une nouvelle “killer feature” dénommée “Audio-to-Audio”. Concrètement, ça marche comment ?

Vous pouvez uploader un fichier audio et le “remixer” via un prompt.

Encore plus fort, vous pouvez fredonner un air ou un instrument et matérialiser le son avec un prompt. Incroyable ou incroyable ? Je crois que c’est incroyable.

Show me the money

Pour compenser les coûts élevés de l’IA, Google envisagerait d'instaurer un paywall pour des fonctionnalités de recherche avancées par l'IA, ce qui marque un tournant dans sa stratégie habituellement gratuite. Cette démarche soulève des questions sur l'équilibre entre le modèle économique publicitaire et l'intégration de l'IA, Google risquant de perdre des utilisateurs face à des concurrents comme Microsoft.

Réalité de l’influence virtuelle

Le marché des influenceurs virtuels, évalué à 3,60 milliards de dollars en 2022, serait sur le point de concurrencer les influenceurs en chair et en os d'ici 2025. Contre toute attente, ces personnages "fictifs" génèrent de véritables ventes : une étude révèle que 35% des consommateurs américains ont déjà acheté des produits promus par ces avatars numériques. De quoi me donner envie de me cloner sur TikTok pour que vos ados me follow. Vive la comm transgénérationnelle.

New Kid On The Block

Un nouveau générateur de vidéo fait son apparition avec Higgsfield, un outil qui cible les créateurs de contenus, avec l’ambition de “développer un éditeur vidéo amélioré permettant aux utilisateurs de modifier les personnages et les objets dans les vidéos de manière intuitive.” La vidéo de démo donne envie de tester l’outil.

Real Time Generation

Krea.ai a publié une nouvelle fonctionnalité : le “multi image prompt” en temps réel.

Démo :

Haiper 2.0

Le générateur de vidéo qui monte qui monte qui monte s’appelle Haiper. En attendant Sora, le nerf de la guerre des générateurs actuels, c’est la cohérence temporelle. Des vidéos qui ne se déforment pas dans tous les sens 8 fois sur 10 (Good Morning Runway). Et sur ce point, Haiper semble tirer son épingle du jeu.

La plateforme vient de sortir un update de taille : il est désormais possible de générer des vidéos de 4 secondes (contre seulement 2 auparavant). N’hésitez pas à le tester, il est gratuit.

Meta robe en 3D

Meta a dévoilé Garment3DGen, une innovation capable de styliser la géométrie et les textures des vêtements à partir d'images 2D et de maillages 3D. Cette méthode permet d'adapter ces éléments sur des corps paramétriques et de simuler leur comportement. Une avancée significative qui offre des possibilités inédites pour les concepteurs et les amateurs de mode virtuelle.

Morph 2.0

En matière de génération de contenus audiovisuels par l’IA, la tendance qui se profile pour 2024, c’est la plateformes “all-in-one”. Nous avions parlé de LTX le mois dernier. Le prochain sur la liste s’appelle “Morph Studio”. Ce n’est pas un nouveau venu à proprement parler : leur serveur Discord existe depuis juillet 2023 et propose d’y générer gratuitement des vidéos avec une qualité que je qualifierais d’inférieure à celle proposée par Runway et Pika.

La nouveauté, c’est que Morph s’associé à Stability AI pour proposer une plateforme de création audiovisuelle. J’ai le sentiment que la compétition sur ce secteur s’annonce impitoyable et que certains acteurs trop en avance risquent d’y laisser des plumes. A suivre, avec un paquet de pop corn à portée de main.

Viggle 2.0

Viggle se présente comme “ le premier modèle de fondation vidéo-3D avec une réelle compréhension de la physique, capable de faire bouger n'importe quel personnage comme vous le souhaitez”. La nouvelle version 2.0. a été lancée, introduisant des améliorations significatives pour les utilisateurs. Viggle offre désormais une résolution vidéo supérieure, une représentation améliorée des expressions faciales, une réduction des artefacts dans les mouvements rapides et une optimisation plus rapide. Et c’est gratuit : https://discord.gg/qR8Atjxj

Hume : Un interlocuteur synthétique empathique

Un outil intrigant a récemment vu le jour dans le domaine de l'intelligence artificielle générative. Il s’agit de Hume AI, un outil capable d'analyser les sentiments et les émotions véhiculés par la voix. Cette technologie, présentée comme la première interface vocale empathique (EVI) au monde, ambitionne de révolutionner la façon dont les contenus sont consommés et adaptés en temps réel en fonction des réactions du public. En identifiant les nuances émotionnelles derrière les mots, Hume AI promet une interaction plus riche et plus nuancée entre les créateurs de contenu et leur audience.

L'outil utilise des modèles d'IA avancés pour examiner le ton de la voix, les expressions faciales, et le langage corporel, capturant ainsi les émotions des utilisateurs au-delà des paroles exprimées. Cette capacité à décoder les sentiments offre des applications potentielles non seulement dans le secteur de l’entertainment et de la création de contenu, mais aussi dans des domaines comme la thérapie.

Alors, je l’ai testé pour vous et, Spoiler Alert, je suis partagé pour le moment.

La raison principale, c’est que Hume.ai ne gère que l’anglais pour le moment.

Ecoutez donc :

Une fois qu’on switche en anglais, ça fonctionne beaucoup mieux. J’ai été saisi par le naturel des intonations de voix. La sensation conversationnelle est excellente, en dépit d’un temps de latence légèrement plus long que pour une conversation normale.

J’ai poussé l’expérience un peu plus loin pour tester l’”emotional intelligence” de Hume, en lui demandant des conseils au prétexte que je ne me sentais pas bien.

La réponse est aussi générique que les symptômes que je décris (fatigue, etc…) mais permet d’entrevoir la valeur ajoutée d’un interlocuteur à l’écoute et pas avare de conseils, fut-il synthétique.

Il est également possible d’interagir avec Hume en activant sa webcam. Un algorithme de reconnaissance faciale est alors capable de détecter vos émotions en fonctions de vos expressions faciales. Je l’ai testé, ça me parait assez convaincant :

Hume propose également une API qui ouvre des possibilités au développement d’applications tierces. Je pense à l’intégration dans les caméras selfies des smartphones pour adapter les réponses d’un futur Siri en fonction de votre état émotionnel, détecter une humeur dépressive, etc… ou dans les voitures pour lancer des conversations en cas de somnolence du conducteur.

Bref, si vous êtes meilleurs que moi en acting, que vous parlez bien anglais et que vous avez envie de tester cet outil, Hume.ai est gratuit pour le moment, et accessible ici :

Et toi, tu fais quoi avec l’IA ?

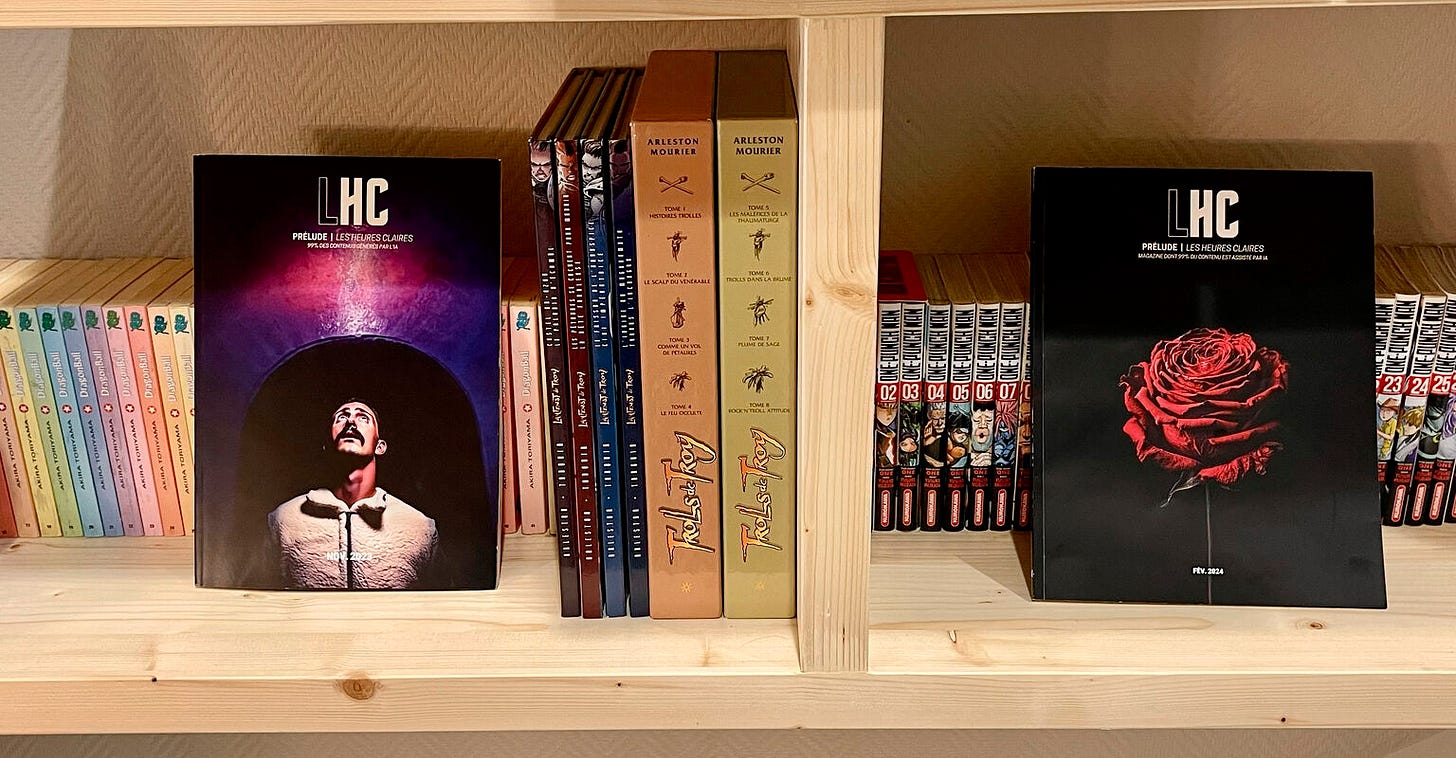

Cette semaine j’ai le plaisir d’interviewer mon camarade Rémi Rostan, créateur du magazine LHC 99% réalisé avec l’IA, et utilisateur avancé de chatGPT, DALL-E et Midjourney.

Bonjour Rémi, peux-tu te présenter ?

Salut Gilles, merci pour ton invitation ! Je m'appelle Rémi, j'ai 34 ans et je vis dans les Hautes-Alpes. Mon parcours entrepreneurial a débuté à l'âge de 19 ans, d'abord dans le secteur de la restauration. Par la suite, je me suis intéressé à la prise de vue par drone avant de plonger dans le vaste monde du web. J'y ai endossé plusieurs rôles : formateur en web marketing, community manager et depuis 10 ans en étant photographe agréé Google Street View pour les entreprises.

Actuellement, ma passion et mon énergie se focalisent sur l'élaboration du magazine LHC.

Quand as-tu commencé ton parcours en IA générative, et comment cela s'est-il passé ?

Mes précédentes activités, bien qu’enrichissantes, m’ont souvent contraint à suivre un process assez rigide, laissant peu de place à la créativité. À la fin novembre 2022, pendant ma veille sur différents réseaux sociaux, je suis tombé sur une trend qui commençait à faire du bruit : ChatGPT. Poussé par la curiosité, j'ai décidé de voir de quoi il s'agissait. Face à une interface épurée, juste une zone de texte m'invitant à saisir quelque chose, j'ai tapé mon premier message prompt, sans réaliser que j'interagissais déjà avec l’IA. Je m'attendais à une réponse banale, du genre de celles fournies par les bots de services clients. Mais la réponse obtenue m'a complètement bluffé. Il s’en est suivi une série d'itérations pendant des heures. Peu de temps après, en découvrant Midjourney, je suis totalement tombé dans la marmite.

Entre décembre et mars, une période qui tombe heureusement dans les mois traditionnellement plus calmes de mon activité de photographe Street View, j'ai consacré mon temps à expérimenter avec ces plateformes. Puis, le 26 août, un déclic : avec quelques milliers de visuels générés par l’IA et en attente d’une utilité, j’ai retrouvé des magazines de skate & lifestyle de mon adolescence, tels que Tricks, Cream, Blackcode ou le WAD, réputés pour leur originalité. C’est là que l’idée a germé : créer un magazine IA !

Peux-tu nous présenter LHC ?

LHC "Les Heures Claires", c’est un magazine mensuel assisté principalement avec l’aide de l’IA.

Les visuels sont générés par environ une douzaine d’IA, et une majeure partie du texte par ChatGPT.

Il y a désormais six numéros, dont deux imprimés ! La majorité de ces numéros peut être consultée gratuitement en ligne, et l’édition imprimée de février est disponible à la commande.

L’objectif derrière la structure tripartite de LHC était d’éviter de cantonner le magazine à une approche purement technique de l’intelligence artificielle. Inspiré par la capacité de ChatGPT à manier la satire et l’humour, j’ai été motivé à créer un magazine original, tout en gardant l’IA comme fil rouge. Chaque segment du magazine a été conçu pour explorer différentes facettes et potentiels de l’IA.

Dans la première partie, il y a des tutoriels proposés par GenIArt, des actualités sélectionnées par Sane d’Upmynt et des invités issus de l’IA comme Victor de Krea.AI, Colin Dunn de Visual Elecric pour n'en nommer que quelques-uns. Cette partie s'enrichit également d’expertise, comme l'angle juridique abordé par Aurore Sauviat, les colonnes s’ouvrent aussi à des tribunes, à l'instar de celle où tu as partagé tes réflexions sur Sora dans l'édition de mars. Tout ça dans le but de démystifier et de rendre accessible l’univers de l’IA.

La seconde partie se consacre à mettre en lumière une sélection d'artistes, parmi lesquels Neïla Romeyssa, le collectif [AI]magination, ou encore David Raichman. On y explore l’usage de l'IA dans divers domaines artistiques et culturels. Par exemple, dans le monde de la musique avec Joachim Garraud dans l'édition de février, ou dans celui de la littérature avec Rafaël, bibliothécaire, qui se plaît à piquer la curiosité de ChatGPT. J'ai également lancé la Battle du Chef avec l’envie d’intégrer la gastronomie d’une manière originale. Dans ce défi, l'IA propose et illustre une recette de saison tandis qu'une personnalité du monde culinaire est sollicitée pour préparer la même recette. Les lecteurs sont alors invités à élire le plat qui les séduit le plus, sans savoir qui est à l'origine de chaque création.

Dans la troisième et dernière section, l'humour grinçant se mêle à la critique de l'IA, créant un espace dédié à la satire. L'objectif est de révéler les capacités de l'IA à travers un prisme moqueur et critique. Cette partie regorge de contenus tels qu'une parodie de coach sportif, un horoscope inversé humoristique, et des billets critiques sur les comportements humains.

Quels ont été les principaux challenges que tu as rencontrés et comment les as-tu relevés ?

Je me suis lancé en solo avec beaucoup de naïveté dans l’univers de l’édition et du graphisme, découvrant un monde nouveau pour moi. N’étant pas graphiste de formation, j’apprends à utiliser InDesign depuis septembre. Le principal défi réside dans la création d’un contenu lisible et cohérent, le tout avec une mise en page claire (il reste d’ailleurs du travail à ce sujet), tout en supervisant seul l’ensemble du projet. Cela englobe tout, du marketing à la création du magazine, de la prise de contact avec les partenaires et contributeurs, à la mise en page, la gestion de l’impression, la formation et la veille technologique.

Je vis cette période, qui s’étend du 26 août à aujourd'hui, comme un véritable tourbillon. Les nuits sont courtes et les journées pourraient bénéficier de 48 heures, mais l’expérience est passionnante. Travailler avec le contenu généré par l’IA est un autre grand défi. Bien qu’innovant, ce contenu est loin d’être parfait, nécessitant des retouches constantes des textes et la correction des artefacts visuels.

Cette aventure, pleine de découvertes et de défis, est une expérience d’apprentissage intense. Je me suis habitué à organiser systématiquement une visio avec ceux qui me contactent, ou à partager un café avec ceux que je croise et qui me parlent de leur usage de l’IA et également de leurs feedbacks avec LHC, pour écouter leurs impressions, leurs suggestions, et plus encore... Je consigne chaque commentaire et, lorsqu'un point précis est fréquemment évoqué, il devient alors un sujet de travail prioritaire. Cela a notamment été le cas pour la charte graphique/édito du magazine, qui connaîtra des évolutions dans le prochain numéro. J'ai également le plaisir de vivre cette aventure aux côtés de personnes rencontrées comme Pierre Saal, qui suit LHC depuis ses débuts, ainsi qu’avec ma consoeur Nathalie Dupuy du magazine IALS. Avec elle, nos conversations téléphoniques s'étendent souvent bien au-delà d'une heure, signe des riches échanges que nous partageons dans l’aventure de créer un magazine avec l’IA.

Quels sont tes outils GEN AI préférés et pourquoi ?

Parmi les outils que j'emploie régulièrement, on trouve :

- ChatGPT, apprécié pour sa simplicité, son efficacité, et sa pertinence. À ce jour, les autres LLM ne m'ont pas convaincu, à l'exception de la dernière mouture de Claude qui m'a récemment fait une forte impression.

- Dall-E3 se distingue par sa compréhension et sa facilité d'utilisation. En y apportant des retouches via Lightroom/Photoshop, puis un traitement avec Magnific.AI pour diminuer son empreinte visuelle caractéristique, on peut obtenir des résultats surprenants.

- Midjourney, remarquable pour sa qualité et l'aspect druidique des instructions spécifiques qu'il faut lui fournir.

Magnific.AI, utilisé pour améliorer les images et pour sa fonction récente Style Transfer

Enfin, Generative Fill de Photoshop qui est un outil quotidien essentiel pour affiner rapidement les images générées.

Depuis quelques semaines, j’expérimente Beink Dream et Seelab, deux plateformes françaises méritant une attention particulière. Ravi de constater la présence marquée de la France dans cet écosystème, sans oublier de mentionner Pimento et, naturellement, Mistral.

Penses-tu que l'Ia générative t'ouvre de nouveaux terrains pour exprimer les côtés créatifs de ta personnalité ?

Carrément ! Je croise plein de gens qui, auparavant, se heurtaient à un mur d'impuissance créative : des idées plein la tête mais pas les moyens ou compétences pour les concrétiser à travers l'art visuel ou d'autres formes. C'était mon histoire aussi. L'avènement de l'IA est devenu un catalyseur extraordinaire pour éveiller cette créativité endormie. Elle m'a permis d'explorer des univers et des perspectives auxquels je n'aurais jamais pensé me frotter par d'autres moyens. C'est comme avoir découvert une boîte à outils pour le plaisir pur de créer. Le projet LHC naît de cette envie de réveiller cette créativité, souvent reléguée au second plan par le tumulte de la vie quotidienne et professionnelle. Transformer aujourd'hui cette passion en une activité professionnelle, c'est ouvrir la porte à un monde des possibles et c’est vraiment plaisant !

T'es tu essayé à la génération de vidéo ?

En fait, pas tellement. Je garde un œil attentif sur tout ce qui touche à la création vidéo, mais à mon sens, les outils actuels ne sont pas encore tout à fait au niveau. C'est compréhensible, après tout, c’est nouveau et tout cela va très vite. Il y a une décennie, avant que DJI ne révolutionne le marché des drones, j'avais initié un projet avec un drone artisanal. Cependant, la technologie de l'époque ne répondait pas encore aux exigences, et certaines de mes ambitions vidéo sont restées en suspens. N’ayant pas retouché à un drone depuis, ces projets sont toujours dans un coin de ma tête, et j'attends avec impatience de voir ce que Sora va proposer, ainsi que les autres acteurs, afin de déterminer si je peux concrétiser ces idées sans prendre le risque de voir mon investissement se crasher dans un sapin ou un rocher.

Quelles sont les innovations que tu anticipes sur l'année 2024 dans le domaine des outils d'IA générative ?

Évidemment, la vidéo avec Sora, les avancées en 3D sur lesquelles travaille Midjourney, et sans oublier l'arrivée de ChatGPT-5 pour cet été. OpenAI a cette habitude de laisser les autres acteurs innover à leur manière, puis, soudainement, ils dévoilent des progrès époustouflants auxquels personne ne s'attend. L'objectif avec tout ça ? Enrichir LHC avec des interactions IA incluant ces aspects !

2024 promet d'être une année encore très créative !

Merci beaucoup Rémi d'avoir pris le temps de répondre à mes questions !

Cette édition est terminée, merci de l’avoir lue. Si elle vous a plu, vous pouvez la partager en cliquant juste ici :

Vous pouvez également me suivre sur LinkedIn et activer la cloche 🔔, je poste régulièrement sur l’intelligence artificielle générative. Vous pouvez également me contacter pour toute proposition de création, intervention, conférence, projet, formation liée à l’intelligence artificielle générative.

Et n’oubliez pas de vous abonner pour ne rien rater des prochaines éditions 👇