News, workshop, podcast et médecine

Bonjour les humains et bienvenue dans cette nouvelle édition de GENERATIVE, la Newsletter consacrée aux outils d'intelligence artificielle générative et à leurs pratiques.

Au sommaire de ce vendredi, les news IA de la semaine, un retour d'expérience sur un workshop IA à Milan, la sortie du 3e épisode de IATUS, et l'interview d’Eric, radiologue augmenté par l'intelligence artificielle.

Bonne lecture !

Les news de la Semaine

MOM-AI

La récente installation de l’artiste Refik Anadol au Museum of Modern Art, intitulée "Unsupervised", explore ce qu'une machine pourrait rêver après avoir vu plus de 200 ans d'art dans la collection du MoMA. Anadol utilise l'intelligence artificielle pour interpréter et transformer l'ensemble de données du musée, créant de nouvelles formes qui pourraient exister dans les archives mais qui n'existent pas, pour réfléchir à tous les chemins non pris dans l'histoire de l'art moderne et spéculer sur ce qu'ils pourraient être. L'œuvre transforme l'environnement du hall Gund du musée en une animation "vivante" à grande échelle, grouillante de visualisations uniques qui se déroulent de manière imprévisible et n'ont pas de résultat prédéterminé.

Le projet implique plusieurs étapes d'un Machine Learning sophistiqué : le studio d'Anadol a utilisé un logiciel open source pour rechercher, trier et classer l'ensemble de données publiquement disponible de la collection du MoMA, créant une carte spatiale complexe de l'archive en 1024 dimensions. Le studio a ensuite utilisé un modèle de Machine Learning connu sous le nom de réseau antagoniste génératif (GAN) pour naviguer dans la carte de l'archive et, après des mois d'apprentissage, créer en permanence de nouvelles formes avec l'aide d'un logiciel de rendu personnalisé et d'un superordinateur. Les visuels en constante évolution sont rendus presque instantanément, en haute résolution, la machine "rêvant" de l'art moderne. Je trouve le résultat complètement fascinant.

Uberisation de l’IA ?

Une étude récente de l'École polytechnique fédérale de Lausanne (EPFL) a révélé qu'une proportion significative des personnes rémunérées pour former des modèles d'IA délèguent en réalité ce travail à l'IA elle-même. Les chercheurs ont embauché 44 personnes sur Amazon Mechanical Turk pour résumer 16 extraits de travaux de recherche médicale, puis ont analysé leurs réponses à l'aide d'un modèle d'IA qu'ils avaient formé eux-mêmes. Ils ont estimé que 33 à 46% des travailleurs avaient utilisé des modèles d'IA comme ChatGPT.

Cette tendance pourrait s'amplifier à mesure que les chatbots deviennent plus puissants et facilement accessibles. Cependant, l'utilisation de données générées par l'IA pour former d'autres modèles d'IA pourrait introduire davantage d'erreurs dans des modèles déjà sujets à l'erreur. Si ces modèles génèrent des sorties incorrectes qui sont ensuite utilisées pour former d'autres modèles d'IA, les erreurs peuvent être absorbées par ces modèles et amplifiées avec le temps.

Identifier les deepfakes

LinkedIn et l'Université de Californie à Berkeley ont développé une nouvelle méthode pour détecter les photos de profil générées par l'IA. Cette méthode identifie avec précision 99,6% des images artificiellement générées, tout en ne confondant que 1% des images réelles avec des fausses. La méthode combine une approche géométrique pour identifier un attribut unique dans les visages générés par ordinateur et des méthodes basées sur les données pour le mesurer et le détecter. Elle utilise un classificateur léger et rapidement entraînable et nécessite une formation sur un petit ensemble de visages synthétiques. Les chercheurs ont utilisé cinq moteurs de synthèse différents pour créer 41 500 visages synthétiques et ont utilisé 100 000 vraies photos de profil LinkedIn comme données supplémentaires.

Dans un contexte où l’AI generated devient de plus en plus difficile à distinguer de la réalité , il s'agit d'une étape prometteuse vers des communautés numériques plus sûres.

Le futur de l’IA ?

Google DeepMind a créé RoboCat, un robot capable d’apprendre de manière autonome une variété de tâches et d'alterner entre différents corps robotiques. Il peut même générer ses propres données d'entraînement, ce qui accélère son apprentissage.

L'IA de RoboCat est basée sur le modèle Gato, qui a été formé sur un ensemble de données diversifié comprenant des textes, des images et des données de contrôle robotique. Le robot a montré une capacité à maîtriser une variété de défis et à apprendre rapidement de nouvelles tâches. Les chercheurs de DeepMind estiment que cette avancée pourrait conduire à la création de robots beaucoup plus adaptables dans un avenir proche.

Les jeunes et l’IA

The Verge a récemment publié un article qui explore l'utilisation de l'IA et les sentiments du public à son égard. Malgré une couverture médiatique importante, l'utilisation d'outils dédiés à l'IA reste limitée, principalement chez les jeunes utilisateurs. Les outils d'IA sont principalement utilisés pour des expériences créatives, comme la génération de musique et de vidéos, la création d'histoires et la manipulation de photos. Les applications plus professionnelles comme la programmation sont moins courantes.

Les gens ont de grandes attentes quant à l'impact de l'IA sur le monde, au-delà des autres technologies émergentes. Près des trois quarts des personnes interrogées pensent que l'IA aura un impact important ou modéré sur la société. Cependant, les préoccupations concernant l'IA sont nombreuses, allant de la perte d'emplois à la menace pour la vie privée et à l'utilisation abusive par les gouvernements et les entreprises. Enfin, l'article souligne que la majorité des personnes interrogées sont favorables à une réglementation plus stricte des systèmes d'IA et à la divulgation de leur utilisation.

Natural Intelligence

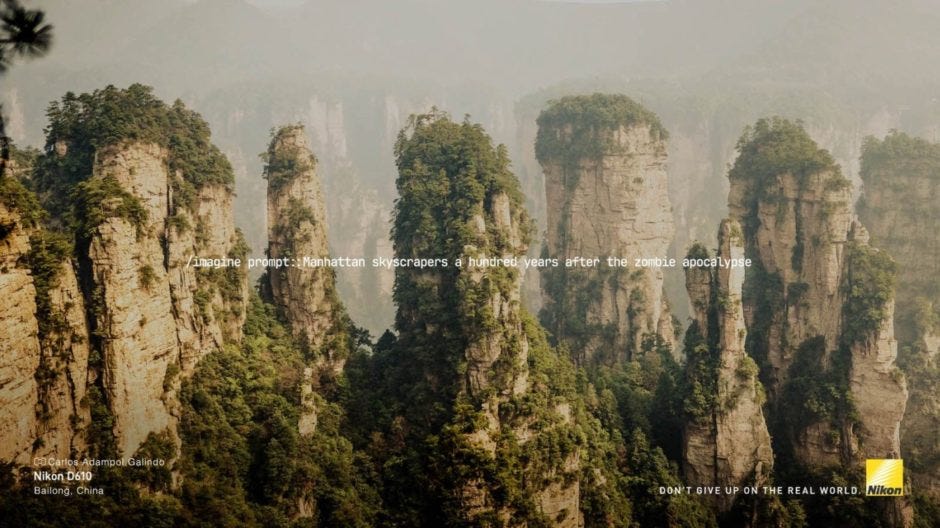

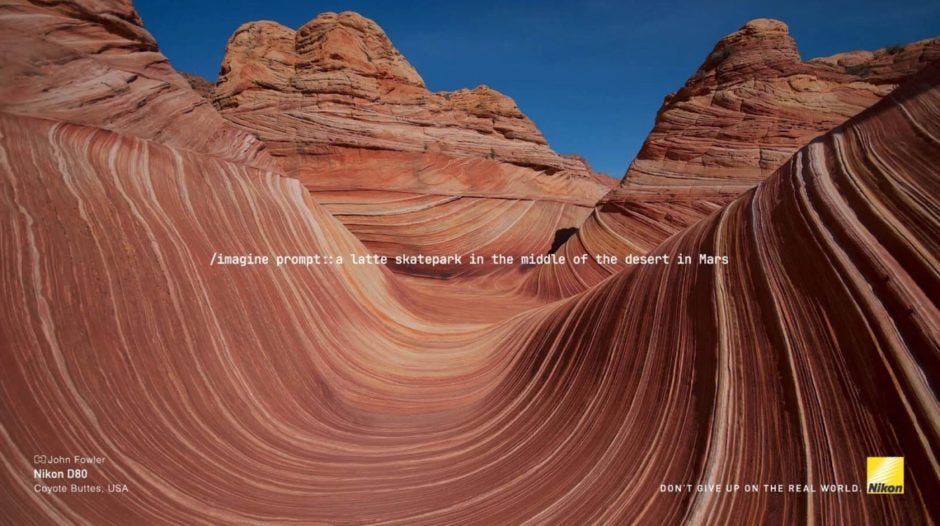

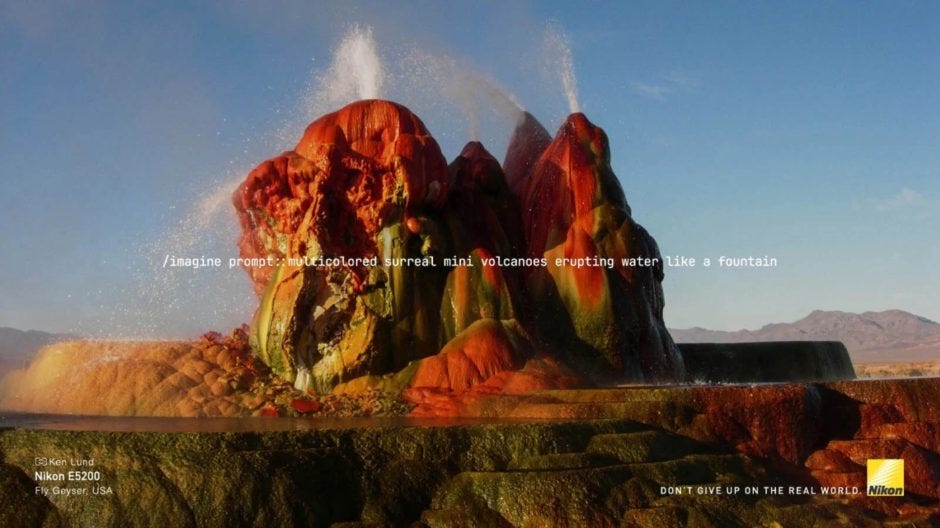

Nikon a lancé une campagne publicitaire au Pérou pour mettre en avant la beauté du monde réel face à l'essor des images générées par l'intelligence artificielle. Intitulée "N'abandonnez pas le monde réel", la campagne met en scène des photos prises par de vrais photographes, montrant des paysages naturels extraordinaires. La campagne vise à rappeler que la technologie et l'intelligence artificielle ne sont pas les seuls moyens de créer des images impressionnantes et que la nature a beaucoup à offrir.

Cependant, cette campagne a suscité des controverses. Selon une enquête du média DIY Photography, Nikon aurait utilisé des images provenant de banques d'images gratuites, comme Unsplash et Flickr, sans rémunérer les photographes. De plus, bien que la campagne prône l'authenticité des images, Nikon a largement retouché les photos utilisées.

Au final, de très belles images pour une campagne impactante, dont le concept qui mêle réalité et éthique aurait gagné à être infusé dans la totalité de l”ADN du projet.

udioPaLM

Google a dévoilé AudioPaLM, un outil d'intelligence artificielle qui comprend et produit du texte et de la parole. AudioPaLM combine les technologies de texte et de parole en un seul système. Il est capable de gérer des informations telles que la voix et le ton de la personne qui parle. L'outil peut traduire de la parole à la parole tout en conservant la voix de la personne qui parle, même dans l'audio traduit. Il peut aussi traduire de la parole en texte dans de nombreuses langues, même si ces combinaisons de langues n'ont pas été utilisées pendant l'entraînement. En plus, AudioPaLM peut écrire ce que dit l'audio original, montrant ainsi qu'il peut comprendre et produire de la parole. Impressionnant sur le papier, je suis curieux de tester.

ChatGPT killer ?

DeepMind, la filiale de Google spécialisée en intelligence artificielle, travaille sur une alternative à GPT-4, le modèle linguistique derrière ChatGPT. Ce nouveau modèle, nommé Gemini, combine les fonctionnalités d'un modèle linguistique avec les technologies précédemment développées par DeepMind. Gemini est multimodal, capable de traiter plusieurs types de données comme le texte, l'audio ou les images.

Selon Demis Hassabis, PDG de DeepMind, Gemini surpassera ChatGPT d'OpenAI pour devenir le modèle de langage le plus avancé au monde. Gemini bénéficie des avancées d'AlphaGo, une IA conçue par DeepMind, pour planifier des tâches et résoudre efficacement des problèmes. Pour finaliser Gemini, Google a fusionné DeepMind avec les équipes de Brain, un projet de recherche en apprentissage profond. Cette fusion vise à rattraper le retard de Google sur ses concurrents, OpenAI et Microsoft. Gemini devrait animer la plupart des services de Google liés à l'intelligence artificielle, dont le chatbot Bard ou le futur moteur de recherche du groupe.

Smaller, Faster, Better, Stronger

Microsoft a révélé Phi-1, un nouveau modèle linguistique plus petit mais plus puissant que GPT-3.5 d'OpenAI. Phi-1, qui compte seulement 1,3 milliard de paramètres, a été conçu pour la programmation en Python. Il a été formé en trois jours sur 8 GPU A100 de Nvidia, en utilisant des données de haute qualité, certaines provenant d'Internet et d'autres générées par GPT-3.5. Les chercheurs de Microsoft ont privilégié la qualité des données plutôt que la quantité, ce qui a permis de réduire la taille de Phi-1. Ce modèle nécessite moins de puissance de calcul, ce qui est plus écologique. Produire des modèles spécialistes plus petits, moins coûteux et moins énergivores que les modèles généralistes semble devenir une tendance qui va se généraliser sur le second semestre 2023.

Bild licencie

Bild, le tabloïd allemand emblématique du groupe Axel Springer, a annoncé une réduction drastique de ses effectifs et un investissement dans l'IA afin de combler le vide. Environ un tiers des 600 emplois pourraient disparaître, certaines tâches devant être automatisées. Cette annonce intervient dans le cadre d'un effort pour réaliser une économie de 100 millions d'euros d'ici à 2025 pour Bild et un autre quotidien du groupe, Die Welt.

Cette décision marque une rupture importante dans la stratégie d'Axel Springer. Au cours des dernières années, l'entreprise avait misé sur la croissance numérique des titres Bild et Die Welt, injectant d'importants investissements dans leur développement multicanal. Cependant, cette stratégie n'a pas produit les résultats escomptés. En dépit d'une forte augmentation du nombre d'abonnements payants en ligne, Bild n'a pas réussi à inverser son déclin.

L'initiative a été critiquée par l'association allemande des journalistes (DJV) qui l'a qualifiée de "rupture de digue". La DJV a averti que le "collègue robot" posait des problèmes significatifs en matière de responsabilité éditoriale et de protection des données, et a appelé les employés de presse à s'opposer à ce qu'elle a appelé "l'exemple Springer". Cette controverse souligne les défis que le journalisme doit relever à l'ère de l'automatisation et de l'IA.

Vers des chatbots spécialistes personnalisés ?

Reka, une startup fondée par des chercheurs de DeepMind, Google, Baidu et Meta, a récemment levé 58 millions de dollars. Son offre ? Des modèles d'IA personnalisés pour les entreprises.

Les grands modèles de langage comme GPT-4 d'OpenAI sont appréciés pour leur capacité à analyser et générer du texte. Cependant, leur caractère généraliste peut être un obstacle pour les organisations qui souhaitent les utiliser pour des tâches spécifiques.

Le premier produit de Reka s'appelle Yasa. Il s'agit d'un un assistant IA multimodal formé pour comprendre les images, les vidéos et les données tabulaires en plus des mots et des phrases. Il peut générer des idées, répondre à des questions de base et extraire des informations à partir des données internes d'une entreprise. Yasa peut être facilement personnalisé pour des données et des applications propriétaires.

Reka prévoit de se concentrer sur l'IA qui peut accepter et générer encore plus de types de données et s'améliorer continuellement. Elle propose également un service pour adapter les LLM qu'elle a développés à des ensembles de données d'entreprise personnalisés ou propriétaires.

“Help me Google”

Google introduit une nouvelle fonctionnalité IA, "Help me organize", dans Google Sheets. Cette fonctionnalité utilise l'IA générative pour suggérer et créer des modèles de tableaux, comme des feuilles de route de produits, des budgets ou des événements. Les utilisateurs peuvent ensuite insérer le tableau et le personnaliser à leur guise. Google envisage cette fonctionnalité pp our assister les tâches qui nécessitent un suivi et une organisation complexes. Cette fonctionnalité est en cours de déploiement progressif pour les testeurs du programme Workspace Labs de Google.

Prédire les tubes ?

En utilisant l'apprentissage automatique, les scans cérébraux et une playlist de 24 chansons, une nouvelle étude de l'Université Claremont Graduate prétend pouvoir utiliser l'IA pour identifier les tubes musicaux avec une précision de 97%.

L’IA est utilisée pour analyser l'activité cérébrale de sujets humains, pendant l'écoute de morceaux. Les signaux cérébraux recueillis "reflètent l'activité d'un réseau cérébral associé à l'humeur et aux niveaux d'énergie", et ces données peuvent être utilisées pour prédire les résultats du marché et le nombre de streams qu'une chanson recevra. Un modèle d'apprentissage automatique a été formé pour traduire les données du scan cérébral en résultats commerciaux réels, partageant finalement des prédictions qui étaient précises à 97%, contre 67% lorsqu'un modèle statistique non IA utilisait les mêmes données.

“Are we living in a F**** movie or what ?”

Snoop Dogg

Brainsonic dépoussière la Warner !

La Warner fête ses 100 ans cette année. En France, cet anniversaire s’accompagne de ressorties de films incontournables du studio dans plus de 200 salles, en collaboration avec UGC. A cette occasion, UGC a sollicité l'agence parisienne Brainsonic pour créer des animations générées par l'intelligence artificielle. Ces vidéos seront diffusées avant des films comme 2001: l’Odyssée de l’espace, Blade Runner, Dune, Gravity, Joker, Mad Max Fury Road, Matrix, Ready Player One, V pour Vendetta.

De passage chez Brainsonic la semaine dernière (poke Mathieu Cruq), j'ai pu découvrir certaines de ces animations, qui valent définitivement le détour !

Workshop IA à Milan

Cette semaine, j'ai eu le plaisir de co-animer un workshop consacré à chatGPT, Midjourney et quelques autres outils d'intelligence artificielle à Milan, dans les locaux du groupe Campari.

Le public était composé de responsables marketing et innovation internationaux des marques du groupe. Après une matinée consacrée à la théorie, à l'étude de use cases faites marque et à des informations légales sur l'utilisation de l'IA, l'après midi a pris la forme de travaux pratiques dans lesquels nos “étudiants” ont travaillé sur des activations de marque en utilisant des outils d'intelligence artificielle générative.

Une expérience gratifiante auprès d'un public intéressé et motivé, qui a bien saisi la valeur ajoutée de l’IA pour optimiser leurs process métiers.

Merci à Fleet Collective, Marie Robin et à Jeremie Moritz pour cette belle opportunité !

Je profite de ce post pour vous inviter à vous abonner à WYWYN, la newsletter Tech-IA éclectique de Jérémie.

IATUS parle de Midjourney

Mon acolyte Laura Ghazal et moi avons le plaisir de vous présenter le 3e épisode de IATUS, notre podcast qui démystifie l'intelligence artificielle générative.

Cette semaine nous parlons d'un outil phare de la création visuelle assistée par l'IA : Midjourney. Explications, historique, fonctionnalités, nouveautés, perspectives et éthique, nous avons essayé de faire le tour de tous ces sujets en 15 minutes.

J'espère que vous aurez au moins autant de plaisir à nous écouter que nous en avons eu à enregistrer ce podcast !

Et toi, tu fais quoi avec l’IA ?

Aujourd’hui, j’ai le plaisir d’interviewer un ami de longue date, Eric, qui utilise l’IA dans son activité médicale.

Peux tu te présenter brièvement ?

Bonjour, Je m'appelle Eric, je suis médecin spécialiste, radiologue, installé en libéral depuis 2010. J'ai une activité de radiologie diagnostique (radiographie conventionnelle, échographie, Scanner et IRM) mais aussi interventionnelle (essentiellement infiltrations sous contrôle de l'imagerie), notamment la scopie (radiographie basse dose en continu, comme si on filmait) ou bien sous contrôle échographique : cela permet de suivre le trajet de l'infiltration pour optimiser le résultat, on contrôle le site d'injection.

Peux tu m'expliquer concrètement comment tu utilises l'intelligence artificielle générative ?

Depuis 2 ans environ, nous utilisons dans nos cabinets de radiologie conventionnelle un outil IA de relecture de radiographies et mammographies. le processus est simple :

- une radiographie numérisée est pratiquée par la manipulatrice.

- Les données brutes sont uploadées dans notre logiciel patient (RIS : Radiology Information System) puis sauvegardées dans un système d'archivage numérique qui nous permet de lire les radios sur des écrans dédiés.

En ce qui concerne l'IA : le fichier est en même temps uploadé via VPN sur un serveur sécurisé externalisé, venant alimenter une base de donnée très importante qui est digérée par l'IA, laquelle nous renvoie un diagnostic simple avec 3 réponses : fracture, luxation, épanchement. l’IA renvoie également un double des radiographies avec une zone d'intérêt que l'IA pense être pathologique : un petit cadre plein si l'IA est certaine, un cadre en pointillés si elle a un doute. Nous avons également un module d'IA qui recherche les microcalcifications dans les mammographies et fonctionne sur le même principe.

Le temps de retour du diagnostic de l'IA est d'environ 2 minutes ce qui est parfait car cela me laisse le temps d'interpréter la radiographie sans être influencé.

Que te permet-elle de faire que tu ne faisais pas avant ? Quelle est sa valeur ajoutée ?

Elle est un outil d'aide au diagnostic, elle permet de lever des doutes car parfois les cas sont difficiles, mais ce n'est pas tout, elle m'oblige à me remettre en question et me challenge en permanence m'obligeant à donner le meilleur de moi même : quelle humiliation que de se faire battre par une IA !! 😅

Son autre intérêt est qu'elle permet de diminuer les incidences de radiologie (clichés de face, profil, oblique etc), ce qui au total diminue fortement la dose de rayons X. Enfin elle permet d'éviter en cas de doute de pratiquer d'autres modalités comme le scanner pour confirmer un fracture par exemple, et permet de faire des économies à la sécurité sociale et aux patients.

Peux tu quantifier son apport ?

Je pense qu'il est difficile de quantifier de manière empirique un apport qui mesure la confiance d'exercer son métier mais l'on va dire qu'elle diminue fortement le doute qui me pétrit à chaque examen et ce d'au moins 80% ! On pourrait quantifier également le temps gagné mais cela reste également empirique, du moins pour l'instant.

Comment aimerais tu l'utiliser à l'avenir ?

J'aimerais et je pense que c'est cela qui va se passer, inverser le process : l'IA fait le diagnostic et le radiologue supervise, cela permettra de gagner beaucoup de temps. et je pense qu'à terme l'IA sera autonome avec des systèmes d'autocritique, mais d'ici là je serai à la retraite :)

Utilises-tu d'autre outils d'IA générative ? Si oui lesquels ?

Je me suis abonné à ChatGPT pour utiliser la dernière version, je suis en train de chercher un moyen d'automatiser certaines taches dans le cadre de mon travail et l’IA générative est parfaite dans ce domaine.

Comment vois tu l'avenir de ce point de vue ?

Le travail tel qu'on le pratique va changer en profondeur, les taches rébarbatives (et progressivement de + en + de taches complexes) vont être gérées par les IA, mais je reste confiant car l'être humain ajoutera sa touche unique qui ne répond pas forcément à la logique : son imprévisibilité !

Merci Eric pour ce retour d’expérience très intéressant à lire !

Cette édition est maintenant terminée, je vous souhaite un excellent weekend, empli de soleil et de prompts inspirés ou expérimentaux, voire les deux à la fois.

N’hésitez pas à me faire des retours en commentaires ou à me contacter, je suis disponible pour tout projet de création assistée par l’IA, de formation ou de conférence sur l’IA générative.

Si la lecture vous a plu, pensez à vous abonner pour ne rien rater des prochaines éditions 👇